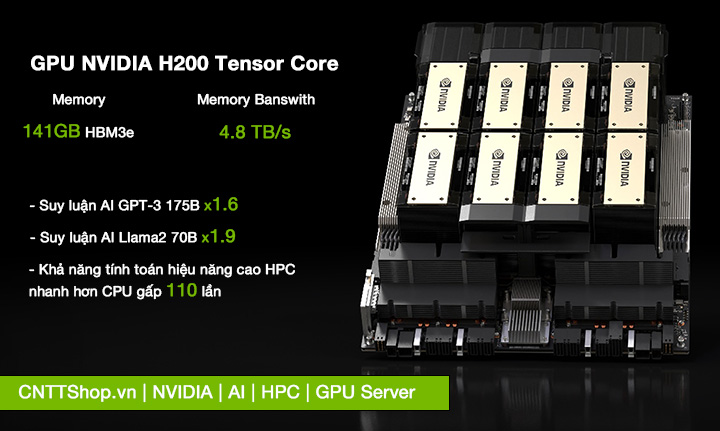

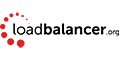

NVIDIA H200 là GPU máy chủ có kiến trúc NVIDIA Hopper™ và bộ nhớ HBM3e dung lượng 141 GB với băng thông 4.8 TB/s, tăng tốc hiệu suất các mô hình AI tạo sinh và các mô hình ngôn ngữ lớn (LLM), đồng thời cải thiện sức mạnh tính toán phức tạp cho các tác vụ HPC với mức độ tiêu tốn năng lượng tối ưu. GPU NVIDIA H200 phù hợp cho những doanh nghiệp và tổ chức có nhu cầu cao về tính toán hiệu năng và trí tuệ nhân tạo.

GPU NVIDIA H200 tăng tốc hiệu suất AI và HPC

1. Được xây dựng bởi kiến trúc NVIDIA Hopper™

NVIDIA H200 cung cấp các tính năng, khả năng và hiệu suất vượt trội để đáp ứng những thách thức của các hệ thống tính toán xử lý phức tạp và trí tuệ nhân tạo AI với hàng tỷ tham số.

Được xây dựng với nền tảng GPU NVIDIA Hopper™ có kiến trúc hơn 80 tỷ bóng bán dẫn, và những công nghệ đột phá như NVLink, Transformer Engine, MIG, NVIDIA Confidential Computing, mang đến sức mạnh đột phá cho GPU NVIDIA H200. Máy chủ chạy bằng GPU NVIDIA H200 cung cấp những gì bạn cần để thành công trong các mô hình học sâu (từ GPT-3 đến Llama2) và AI tạo sinh, hỗ trợ các tác vụ HPC trong các lĩnh vực như nghiên cứu khoa học, khí hậu học, y học..vv và để các nhà cung cấp dịch vụ Cloud cung cấp các dịch vụ AI và HPC hiệu suất cao cho khách hàng.

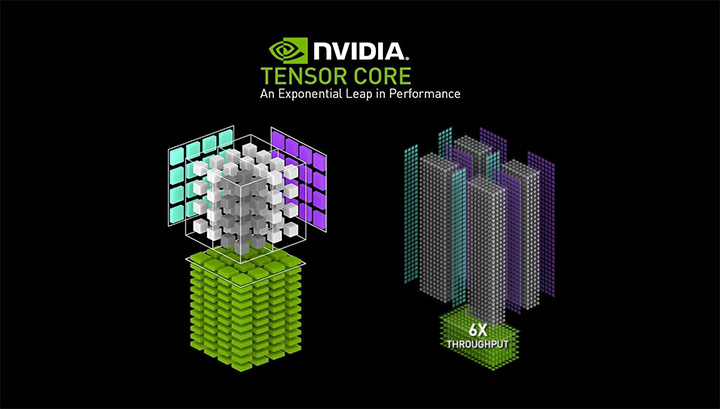

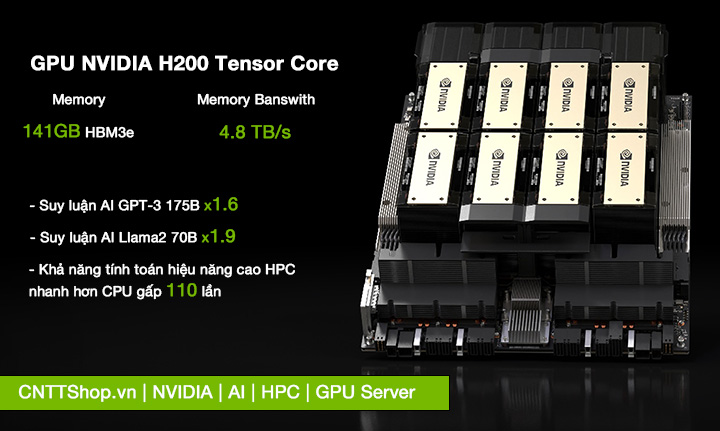

2. Lõi Tensor thế hệ thứ tư

NVIDIA H200 sử dụng lõi Tensor thế hệ thứ tư, được cải tiến trong kiến trúc NVIDIA Hopper™. Các lõi Tensor này được thiết kế để tăng tốc độ và hiệu suất tính toán cho các ứng dụng AI và HPC, đặc biệt là với sự hỗ trợ của Transformer Engine và các công nghệ tiên tiến khác như NVLink thế hệ thứ tư và MIG thế hệ thứ hai.

Các lõi Tensor thế hệ mới này có hiệu suất FLOPS cao hơn tăng gấp ba lần số phép tính dấu phẩy động mỗi giây cho các định dạng TF32, FP64, FP16 và INT8 so với thế hệ trước. NVIDIA H200 hỗ trợ nhiều loại dữ liệu chính xác và cung cấp các đường dẫn dữ liệu số nguyên và dấu phẩy động độc lập, mang lại hiệu suất cao và tăng tốc đáng kể cho các phép tính trong môi trường AI và HPC. Điều này giúp GPU NVIDIA H200 trở thành một giải pháp mạnh mẽ và hiệu quả cho các máy chủ của doanh nghiệp hay trung tâm dữ liệu cần tối ưu hóa hiệu suất tính toán.

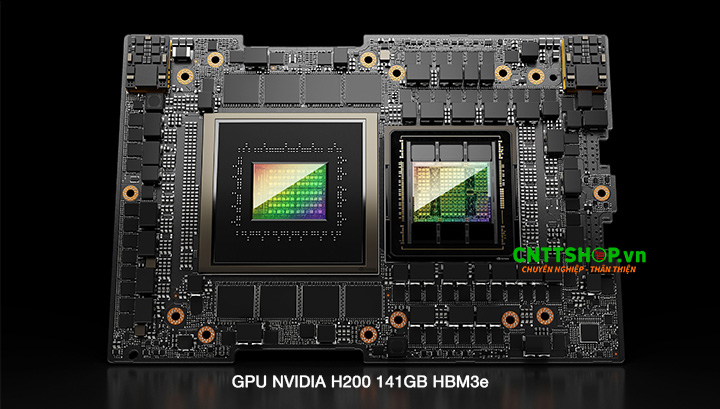

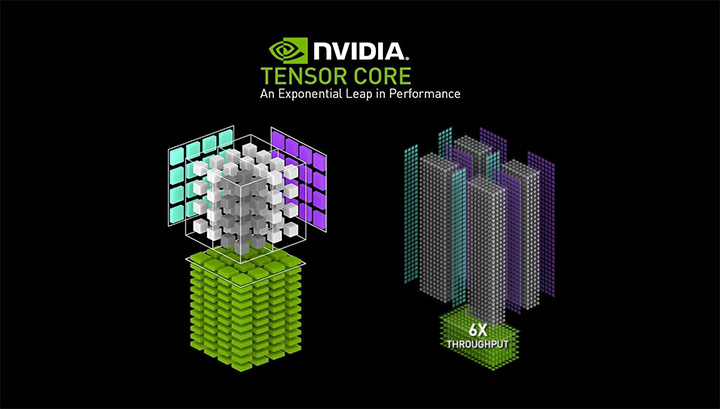

3. Bộ nhớ GPU HBM3e 141GB

NVIDIA H200 là GPU đầu tiên trang bị bộ nhớ HBM3e dung lượng lên đến 141 gigabyte (GB) với băng thông 4.8 TB/s. So với sản phẩm tiền nhiệm GPU NVIDIA H100 thì GPU H200 có dung lượng gấp đôi và có tốc độ băng thông nhanh hơn gấp 1.4 lần, giúp các máy chủ tăng tốc hiệu suất cho AI và tăng tốc độ xử lý các tác vụ liên quan đến tính toán khoa học, phân tích dữ liệu lớn.

Việc chuyển sang bộ nhớ HBM3e mang lại cho NVIDIA khả năng sử dụng cả ngăn xếp HBM dung lượng cao hơn cũng như đạt được hiệu suất cao hơn. Dung lượng bộ nhớ và băng thông có xu hướng là những yếu tố hạn chế chính trong AI và HPC, vì vậy đây được coi là một cách để mở rộng giới hạn về mặt bộ nhớ.

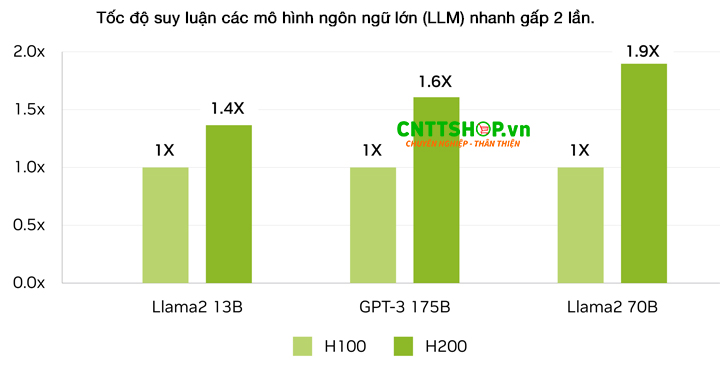

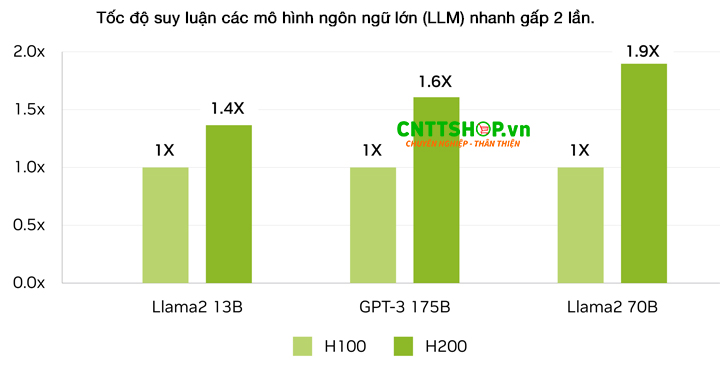

4. Tốc độ suy luận AI nhanh hơn gấp 2 lần

NVIDIA H200 tăng tốc độ suy luận lên tới 2 lần so với GPU H100 khi xử lý các mô hình ngôn ngữ lớn (LLM) như Llama2 hay suy luận GPT-3 175B. GPU H200 chính là giải pháp lý tưởng, mang lại hiệu suất vượt trội và hiệu quả kinh tế cho các doanh nghiệp trong bối cảnh AI không ngừng phát triển, các doanh nghiệp dựa vào LLM để giải quyết nhiều nhu cầu suy luận đa dạng. Để đáp ứng những yêu cầu này, các trình tăng tốc suy luận AI cần phải cung cấp thông lượng cao nhất với tổng chi phí sở hữu (TCO) thấp nhất khi triển khai trên quy mô lớn cho cơ sở người dùng lớn.

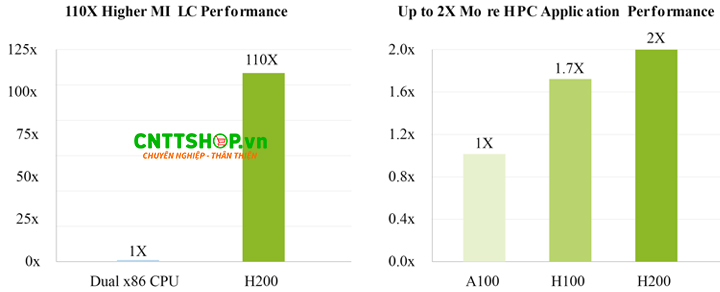

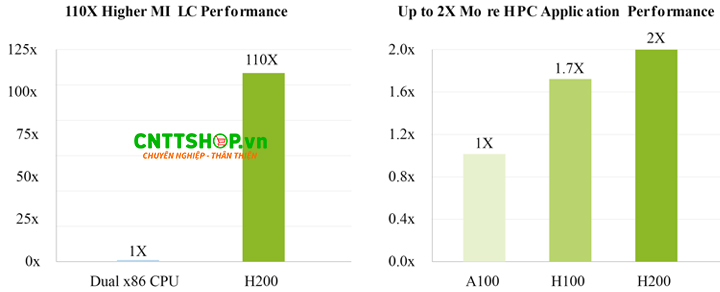

5. Khả năng xử lý tác vụ hiệu năng cao nhanh hơn CPU gấp 110 lần

GPU NVIDIA H200 có băng thông bộ nhớ xuất sắc đạt 4.8 terabyte mỗi giây (TB/s) nó rất quan trọng đối với các ứng dụng HPC, cho phép truyền dữ liệu nhanh hơn, giảm các điểm nghẽn cổ chai trong quá trình xử lý phức tạp. GPU H200 đảm bảo dữ liệu có thể được truy cập và xử lý một cách hiệu quả cho các ứng dụng HPC (như mô phỏng, nghiên cứu khoa học và trí tuệ nhân tạo), dẫn đến thời gian hoàn thành kết quả nhanh hơn đến 110 lần so với CPU truyền thống.

6. Tiêu thụ năng lượng hiệu quả

GPU NVIDIA H200 sử dụng năng lượng một cách hiệu quả hơn, nó có thể thực hiện nhiều tác vụ hơn và xử lý dữ liệu nhanh hơn trong khi tiêu thụ ít năng lượng hơn so với các GPU khác. Điều này không chỉ giúp giảm chi phí vận hành và giảm tổng chi phí sở hữu, H200 trở thành một công cụ quý giá cho các doanh nghiệp đang cần đầu tư vào lĩnh vực AI và HPC.

7. GPU NVIDIA H200 SXM và H200 NVL

NVIDIA H200 được ra mắt với hai phiên bản chính: H200 SXM và H200 NVL. Dưới đây là sự so sánh và mô tả chi tiết về hai phiên bản này.

7.1. GPU NVIDIA H200 SXM

NVIDIA H200 SXM được thiết kế sử dụng form factor SXM, kết nối GPU trực tiếp với bo mạch chủ thông qua socket chuyên dụng. Thiết kế này giúp tăng cường khả năng truyền tải dữ liệu và tản nhiệt hiệu quả hơn. Cung cấp băng thông bộ nhớ và hiệu suất cao nhờ vào thiết kế kết nối trực tiếp. Hỗ trợ nhiều kết nối NVLink giữa các GPU, tăng cường khả năng giao tiếp giữa các GPU trong cùng một hệ thống.

NVIDIA H200 SXM phù hợp cho các trung tâm dữ liệu, siêu máy tính, và các ứng dụng HPC yêu cầu hiệu suất cao. Được sử dụng trong các hệ thống AI, machine learning, và deep learning.

7.2. GPU NVIDIA H200 NVL

H200 NVL được thiết kế chân cắm chuẩn PCIe thế hệ thứ 5 để kết nối lên bo mạch chủ, đơn giản và dễ dàng cài đặt, phù hợp với hầu hết các bo mạch của các loại máy chủ server thế hệ mới trên thị trường hiện nay. H200 NVL hỗ trợ 2 hoặc 4 NVLink bridge, cung cấp băng thông lên đến 900GB/s, tăng cường khả năng giao tiếp và truyền tải dữ liệu giữa các GPU.

NVIDIA H200 NVL lý tưởng cho các doanh nghiệp cần đầu tư vào lĩnh vực AI và HPC, nơi yêu cầu hiệu suất suy luận AI cao và xử lý dữ liệu nhanh chóng với tổng chi phí sở hữu (TCO) thấp hơn.

8. Thông số kỹ thuật chi tiết của GPU NVIDIA H200

| Specifications NVIDIA H200 Tensor Core GPU |

| Form Factor |

H200 SXM |

H200 NVL |

| FP64 |

34 TFLOPS |

34 TFLOPS |

| FP64 Tensor Core |

67 TFLOPS |

67 TFLOPS |

| FP32 |

67 TFLOPS |

67 TFLOPS |

| TF32 Tensor Core |

989 TFLOPS |

989 TFLOPS2 |

| BFLOAT16 Tensor Core |

1,979 TFLOPS |

1,979 TFLOPS |

| FP16 Tensor Core |

1,979 TFLOPS |

1,979 TFLOPS |

| FP8 Tensor Core |

3,958 TFLOPS |

3,958 TFLOPS |

| INT8 Tensor Core |

3,958 TFLOPS |

3,958 TFLOPS |

| GPU Memory |

141GB |

141GB |

| GPU Memory Bandwidth |

4.8TB/s |

4.8TB/s |

| Decoders |

7 NVDEC

7 JPEG |

7 NVDEC

7 JPEG |

| Confidential Computing |

Supported |

Supported |

| Max Thermal Design Power (TDP) |

Up to 700W (configurable) |

Up to 600W (configurable) |

| Multi-Instance GPUs |

Up to 7 MIGs @16.5GB each |

Up to 7 MIGs @16.5GB each |

| Form Factor |

SXM |

PCIe |

| Interconnect |

NVIDIA NVLink®: 900GB/s

PCIe Gen5: 128GB/s |

2- or 4-way NVIDIA NVLink bridge: 900GB/s PCIe Gen5: 128GB/s |

| Server Options |

NVIDIA HGX™ H200 partner and NVIDIA-Certified Systems™ with 4 or 8 GPUs |

NVIDIA MGX™ H200 NVL partner and NVIDIA-Certified Systems with up to 8 GPUs |

| NVIDIA AI Enterprise |

Add-on |

Included |

9. CNTTShop - Nhà cung cấp GPU NVIDIA H200 chính hãng, giá tốt.

Thật vui mừng khi chứng kiến những sản phẩm GPU của NVIDIA ra mắt trên thị trường, đặc biệt là GPU NVIDIA H200 đây là sản phẩm tinh túy thúc đẩy sự phát triển của các mô hình AI và các hệ thống tính toán phức tạp cho các công ty công nghệ, tài chính, y học, khoa học, và kỹ thuật.. Nếu bạn đọc cần tư vấn giải pháp NVIDIA, AI, HPC vui lòng liên hệ tới chúng tôi.

CNTTShop.vn là nhà cung cấp uy tín chuyên cung cấp các sản phẩm GPU NVIDIA chính hãng cho máy chủ, cam kết mang đến cho khách hàng những giải pháp công nghệ tiên tiến nhất với mức giá cạnh tranh. Với đội ngũ chuyên gia giàu kinh nghiệm và dịch vụ hỗ trợ tận tâm, CNTTShop không chỉ đảm bảo chất lượng sản phẩm mà còn cung cấp dịch vụ tư vấn và hỗ trợ kỹ thuật toàn diện. Khách hàng sẽ được hưởng lợi từ các sản phẩm GPU NVIDIA hiệu suất cao, đáp ứng nhu cầu xử lý dữ liệu, AI và HPC, giúp nâng cao hiệu quả kinh doanh và phát triển bền vững. Với phương châm "Chuyên nghiệp - Thân thiện", CNTTShop luôn đồng hành cùng doanh nghiệp trong hành trình chinh phục những thách thức công nghệ mới.

Switch

Switch Wifi - Access Point

Wifi - Access Point Firewall

Firewall Router

Router Module Quang

Module Quang![Module Quang Cisco]() Module Quang Cisco

Module Quang Cisco![Module quang HPE]() Module quang HPE

Module quang HPE![Module quang Maipu]() Module quang Maipu

Module quang Maipu![Module quang Brocade]() Module quang Brocade

Module quang Brocade![Module quang Fortinet]() Module quang Fortinet

Module quang Fortinet![Module quang Aruba]() Module quang Aruba

Module quang Aruba![Module quang OEM]() Module quang OEM

Module quang OEM![Module quang Juniper]() Module quang Juniper

Module quang Juniper![Module quang Dell]() Module quang Dell

Module quang Dell![Module quang Palo Alto]() Module quang Palo Alto

Module quang Palo Alto![Module quang Huawei]() Module quang Huawei

Module quang Huawei![Module quang Arista]() Module quang Arista

Module quang Arista![Module quang F5]() Module quang F5

Module quang F5![Module quang H3C]() Module quang H3C

Module quang H3C![Module Quang Allied Telesis]() Module Quang Allied Telesis

Module Quang Allied Telesis![Module quang SonicWall]() Module quang SonicWall

Module quang SonicWall![Module quang Mikrotik]() Module quang Mikrotik

Module quang Mikrotik![Module quang Handar]() Module quang Handar

Module quang Handar Máy chủ (Server)

Máy chủ (Server) Thiết bị lưu trữ (SAN, NAS)

Thiết bị lưu trữ (SAN, NAS) Load Balancing

Load Balancing Video Conferencing

Video Conferencing Phụ kiện máy chủ

Phụ kiện máy chủ Thiết Bị IoT

Thiết Bị IoT Phụ Kiện Mạng

Phụ Kiện Mạng

.png)

Bạn đang cần tư vấn về sản phẩm: H200 ?