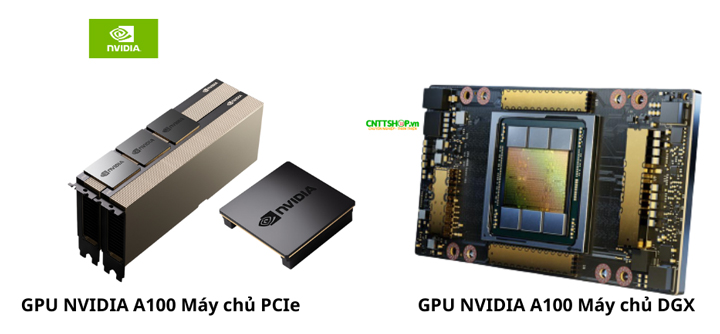

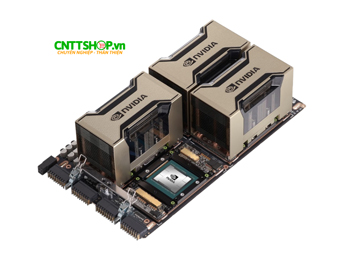

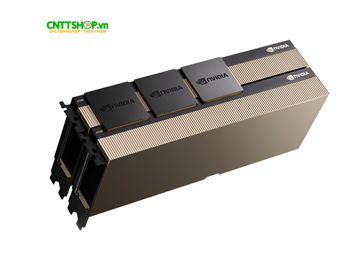

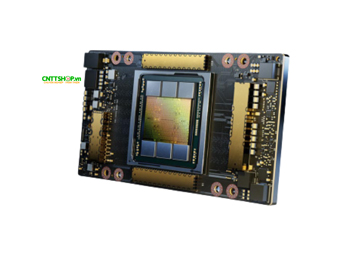

1. NVIDIA A100 – Giới thiệu tổng quan

NVIDIA A100 là GPU kiến trúc Ampere, tối ưu cho trung tâm dữ liệu AI, HPC và Big Data, mang đến sự cân bằng giữa hiệu năng, chi phí vận hành và khả năng triển khai linh hoạt. Với sức mạnh tính toán vượt trội, A100 không chỉ tăng tốc huấn luyện AI mà còn giúp tối ưu hóa chi phí bằng khả năng xử lý đa nhiệm, phù hợp với nhiều loại workload khác nhau. GPU này hỗ trợ cả hai chuẩn kết nối SXM4 và PCIe, tương thích với cả máy chủ phổ thông và hệ thống chuyên dụng, giúp doanh nghiệp dễ dàng mở rộng hạ tầng AI một cách hiệu quả.

GPU này có 4 phiên bản:

- A100 80GB SXM4: RAM 80GB HBM2e, hiệu suất cao nhất, hỗ trợ NVLink, tối ưu cho AI Training và HPC, giá cao nhất.

- A100 40GB SXM4: RAM 40GB HBM2e, phù hợp với AI Inference và mô phỏng khoa học, giá thấp hơn bản 80GB SXM4.

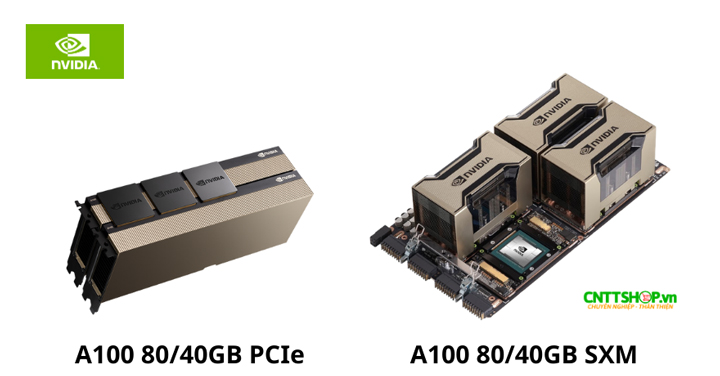

- A100 80GB PCIe: RAM 80GB HBM2e, dễ triển khai trên server phổ thông, phù hợp với AI Training và Big Data.

- A100 40GB PCIe: RAM 40GB HBM2e, tối ưu cho AI Inference và Big Data, giá thấp nhất.

2. Những công nghệ tiên tiến trên NVIDIA A100

Kiến trúc Ampere – Bước tiến lớn về hiệu suất

NVIDIA A100 sử dụng kiến trúc Ampere, cải thiện đáng kể hiệu suất so với thế hệ trước. Được trang bị Tensor Cores thế hệ thứ 3, A100 tăng tốc cả AI training và AI inference bằng cách xử lý các phép toán ma trận chuyên sâu nhanh hơn CUDA Cores truyền thống. GPU này hỗ trợ nhiều định dạng dữ liệu như FP64, FP32, TF32, BFLOAT16, FP16, INT8, INT4, tối ưu cho cả tính toán khoa học và Deep Learning.

Một trong những nâng cấp quan trọng là TF32 (Tensor Float 32), giúp tăng tốc độ tính toán FP32 lên 20 lần mà không cần tinh chỉnh mô hình AI. Điều này giúp rút ngắn đáng kể thời gian huấn luyện mà vẫn đảm bảo độ chính xác cao.

Bộ nhớ HBM2e – Hiệu suất cao cho AI & HPC

NVIDIA A100 được trang bị bộ nhớ HBM2e lên đến 80GB, với băng thông tối đa 2.039 TB/s, nhanh hơn 1.7 lần so với thế hệ trước.

Nhờ dung lượng và tốc độ cao, A100 có thể xử lý các mô hình AI Generative, Large Language Models (LLM) như GPT-4, DALL-E mượt mà hơn, giảm thời gian huấn luyện. Trong HPC, băng thông lớn giúp tối ưu hiệu suất cho các mô phỏng khoa học, khí động học và AI y tế.

Multi-Instance GPU (MIG) – Chia nhỏ GPU, tối ưu tài nguyên

Một GPU A100 có thể được chia thành 7 GPU nhỏ độc lập nhờ công nghệ Multi-Instance GPU (MIG). Mỗi GPU có bộ nhớ và tài nguyên riêng, giúp tối ưu hóa việc sử dụng phần cứng.

MIG giúp doanh nghiệp có thể chạy nhiều workload AI đồng thời mà không cần mua nhiều GPU riêng lẻ. Điều này giúp tăng hiệu suất, tiết kiệm tài nguyên và tối ưu chi phí, đặc biệt trong các ứng dụng AI inference và Big Data.

NVLink & PCIe Gen4 – Băng thông lớn, giảm độ trễ

NVIDIA A100 có ba dạng kết nối chính, giúp mở rộng hệ thống theo yêu cầu khác nhau:

-

NVLink 600GB/s (dành cho phiên bản SXM4): Phiên bản A100 SXM4 hỗ trợ NVLink, giúp kết nối nhiều GPU lại với nhau trong hệ thống HGX/DGX. Nhờ NVLink, GPU có thể chia sẻ bộ nhớ tốc độ cao và truyền tải dữ liệu nhanh hơn, phù hợp với AI Training, HPC và các trung tâm dữ liệu lớn.

-

NVLink Bridge 600GB/s (dành cho phiên bản PCIe): A100 PCIe không hỗ trợ NVSwitch, nhưng vẫn có thể kết nối 2 GPU với nhau thông qua NVIDIA NVLink Bridge, tạo liên kết tốc độ cao giữa 2 card GPU, giúp cải thiện hiệu suất xử lý song song.

-

PCIe Gen4 64GB/s (dành cho phiên bản PCIe & SXM): Đây là chuẩn kết nối giữa GPU và CPU, cũng như giữa GPU với GPU nếu không dùng NVLink. PCIe Gen4 nhanh hơn gấp đôi so với PCIe Gen3, giúp truyền tải dữ liệu mượt mà hơn khi GPU hoạt động trên hệ thống server phổ thông.

Nhờ hỗ trợ cả NVLink và PCIe, NVIDIA A100 có thể triển khai linh hoạt theo quy mô hệ thống. Phiên bản SXM tối ưu cho AI Training đa GPU, trong khi PCIe phù hợp với server phổ thông và các tác vụ AI inference

Sparsity – Giảm tải tính toán, tăng tốc suy luận AI

Công nghệ Sparsity tự động loại bỏ các tham số không cần thiết trong mô hình AI, giúp giảm tải tính toán mà không ảnh hưởng đến độ chính xác.

Nhờ đó, AI inference có thể chạy nhanh hơn gấp 2 lần, đặc biệt hiệu quả với các mô hình như GPT-4, BERT. Đồng thời, giảm thiểu mức tiêu thụ điện năng, tối ưu chi phí vận hành trong trung tâm dữ liệu AI.

Điện năng tiêu thụ – Cân bằng hiệu suất và chi phí vận hành

NVIDIA A100 có mức tiêu thụ điện năng từ 250W đến 400W tùy theo phiên bản, giúp cân bằng giữa hiệu suất và chi phí vận hành.

-

Phiên bản PCIe (40GB & 80GB): TDP từ 250W đến 300W, phù hợp với hệ thống server phổ thông, không yêu cầu hạ tầng làm mát quá phức tạp.

-

Phiên bản SXM4 (40GB & 80GB): TDP 400W, yêu cầu hệ thống làm mát tốt hơn, nhưng đổi lại mang lại hiệu suất cao hơn và khả năng mở rộng mạnh mẽ với NVLink.

Nhờ khả năng tối ưu điện năng mà vẫn duy trì hiệu suất cao, A100 giúp giảm gánh nặng vận hành, phù hợp với các trung tâm dữ liệu AI cần cân bằng giữa hiệu suất và chi phí tiêu thụ điện.

3. Khả năng tính toán của NVIDIA A100

NVIDIA A100 được trang bị lõi Tensor Cores thế hệ thứ 3, giúp tăng tốc đáng kể khả năng tính toán trong AI Training, AI Inference và HPC. GPU này hỗ trợ nhiều định dạng dữ liệu khác nhau, tối ưu cho từng loại ứng dụng.

NVIDIA A100 cung cấp hiệu suất tính toán cao trên nhiều chuẩn dữ liệu:

-

FP64: 9.7 TFLOPS

-

FP64 Tensor Core: 19.5 TFLOPS

-

FP32: 19.5 TFLOPS

-

TF32 Tensor Core: 156 TFLOPS

-

BFLOAT16 Tensor Core: 312 TFLOPS

-

FP16 Tensor Core: 312 TFLOPS

-

INT8 Tensor Core: 1.248 TOPS

-

INT4 Tensor Core: 2.496 TOPS

Với khả năng xử lý FP64, A100 phù hợp với các bài toán khoa học, mô phỏng và HPC yêu cầu độ chính xác cao. Trong khi đó, các định dạng TF32, FP16, INT8 giúp tối ưu tốc độ suy luận AI và Deep Learning, đặc biệt trong AI Generative và Large Language Models (LLM) như GPT-4 và BERT.

4. Các phiên bản NVIDIA A100 & Ứng dụng phù hợp

4.1. A100 40GB PCIe – Lựa chọn tiết kiệm, dễ triển khai

A100 40GB PCIe là phiên bản dễ triển khai nhất, phù hợp với máy chủ PCIe phổ thông mà không cần hệ thống chuyên dụng SXM4. Với TDP 250W, GPU này tiết kiệm điện năng hơn so với phiên bản SXM, giúp giảm chi phí vận hành.

Phiên bản này hỗ trợ NVLink Bridge, cho phép kết nối tối đa 2 GPU để tăng băng thông giao tiếp lên 600GB/s, nhưng không hỗ trợ NVSwitch như phiên bản SXM4, giới hạn khả năng mở rộng khi sử dụng nhiều GPU.

Phiên bản này phù hợp khi:

-

Cần một GPU tích hợp dễ dàng vào server PCIe phổ thông.

-

Chạy AI inference, Big Data Analytics hoặc các mô hình AI vừa và nhỏ.

-

Muốn tận dụng MIG (Multi-Instance GPU) để chia GPU thành 7 phần, xử lý nhiều tác vụ đồng thời.

-

Chỉ sử dụng 2 GPU kết nối với nhau bằng NVLink Bridge để tăng băng thông.

Không thích hợp nếu:

-

Cần AI Training quy mô lớn với hơn 2 GPU, vì không hỗ trợ NVSwitch.

-

Muốn triển khai trên hệ thống DGX/HGX, vì đây là GPU PCIe, không phải SXM4.

4.2. A100 80GB PCIe – Bộ nhớ lớn, phù hợp với AI & Big Data

A100 80GB PCIe có bộ nhớ gấp đôi so với bản 40GB, giúp xử lý AI Generative, Large Language Models (LLM) như GPT-4 hiệu quả hơn. Băng thông 1,935 GB/s cho phép truy xuất dữ liệu nhanh hơn, giảm thời gian huấn luyện mô hình.

Giống như phiên bản 40GB PCIe, A100 80GB PCIe hỗ trợ NVLink Bridge, giúp kết nối 2 GPU với nhau để tăng băng thông, nhưng không thể kết nối nhiều hơn 2 GPU bằng NVSwitch như phiên bản SXM4.

Phiên bản này phù hợp khi:

-

Cần bộ nhớ lớn hơn để chạy mô hình AI phức tạp, AI Generative, Big Data.

-

Muốn tận dụng MIG để chạy nhiều workload AI nhỏ trên cùng một GPU.

-

Cần kết nối 2 GPU với nhau bằng NVLink Bridge để mở rộng băng thông.

Không thích hợp nếu:

-

Cần kết nối hơn 2 GPU, vì không hỗ trợ NVSwitch như SXM4.

-

Muốn tối ưu tốc độ truyền tải giữa nhiều GPU trong hệ thống DGX/HGX.

4.3. A100 40GB SXM – Tận dụng NVLink để tăng tốc AI

A100 40GB SXM sử dụng chuẩn SXM4, hỗ trợ NVLink 600GB/s, cho phép kết nối nhiều GPU để tăng tốc AI Training và HPC. Băng thông bộ nhớ 1,555 GB/s cao hơn phiên bản PCIe, giúp xử lý dữ liệu lớn nhanh hơn.

Phiên bản này phù hợp khi:

-

Cần GPU có khả năng mở rộng với NVLink để kết nối nhiều GPU cùng lúc.

-

Chạy AI Training, AI Inference tốc độ cao hoặc các bài toán HPC & mô phỏng khoa học.

-

Sử dụng hệ thống NVIDIA HGX A100 để tối ưu hiệu suất cho trung tâm dữ liệu AI.

Không thích hợp nếu hạ tầng máy chủ không hỗ trợ SXM, vì GPU này chỉ hoạt động trên hệ thống chuyên dụng.

4.4. A100 80GB SXM – Phiên bản mạnh nhất cho AI & HPC

A100 80GB SXM là phiên bản mạnh nhất trong dòng A100, được thiết kế cho AI Generative, Large Language Models (LLM) và trung tâm dữ liệu AI quy mô lớn. Bộ nhớ 80GB HBM2e và băng thông 2,039 GB/s giúp GPU này xử lý nhanh chóng các mô hình AI khổng lồ như GPT-4, BERT, DALL-E. NVLink 600GB/s giúp mở rộng hệ thống với nhiều GPU, tạo thành cụm tính toán mạnh mẽ.

Phiên bản này phù hợp khi:

-

Cần GPU mạnh nhất trong dòng A100 để chạy AI Training cường độ cao, AI Generative và HPC.

-

Làm việc với LLM và AI mô phỏng khoa học quy mô lớn.

-

Sử dụng hệ thống DGX hoặc HGX, nơi cần kết nối nhiều GPU để tối ưu hiệu suất.

Không thích hợp nếu hệ thống chỉ hỗ trợ PCIe, hoặc ngân sách có giới hạn vì đây là phiên bản có giá cao nhất trong dòng A100.

4.5. Bảng so sánh

|

Phiên bản |

Điểm mạnh |

Điểm yếu |

|

A100 80GB PCIe |

- Dung lượng bộ nhớ lớn 80GB HBM2e, phù hợp với AI Generative, LLM, Big Data. - Băng thông 1,935 GB/s, giúp xử lý dữ liệu nhanh hơn. - Tương thích với server PCIe, không yêu cầu hạ tầng SXM. - Hỗ trợ NVLink Bridge (2 GPU), tăng băng thông lên 600GB/s. |

- Chỉ hỗ trợ NVLink Bridge (2 GPU), không có NVSwitch, hạn chế mở rộng nhiều GPU. - TDP 300W, đòi hỏi hệ thống làm mát tốt hơn bản 40GB PCIe. |

|

A100 40GB PCIe |

- Tương thích với server PCIe phổ thông, không cần hạ tầng chuyên biệt. - TDP 250W, tiết kiệm điện năng hơn so với bản SXM. - Hỗ trợ MIG 7 phần, tối ưu tài nguyên cho nhiều workload AI nhỏ. - Hỗ trợ NVLink Bridge (2 GPU), tăng băng thông lên 600GB/s. |

- Chỉ hỗ trợ NVLink Bridge (2 GPU), không có NVSwitch, hạn chế mở rộng nhiều GPU. - Băng thông bộ nhớ thấp hơn SXM, giảm hiệu suất khi xử lý mô hình AI lớn. |

|

A100 80GB SXM4 |

- Phiên bản mạnh nhất, tối ưu cho AI Generative, LLM và trung tâm dữ liệu AI. - 80GB HBM2e, băng thông 2,039 GB/s, giúp xử lý mô hình AI khổng lồ nhanh hơn. - Hỗ trợ NVLink & NVSwitch, mở rộng GPU dễ dàng cho AI training phân tán. |

- Yêu cầu hệ thống SXM4, không thể triển khai trên server PCIe. - Giá cao nhất trong dòng A100. - TDP 400W, yêu cầu hệ thống làm mát và nguồn điện mạnh. |

|

A100 40GB SXM4 |

- Hỗ trợ NVLink 600GB/s, tăng tốc AI training và HPC. - Băng thông bộ nhớ 1,555 GB/s, giúp giảm độ trễ khi xử lý dữ liệu lớn. - Tích hợp trong hệ thống NVIDIA HGX A100, tối ưu cho trung tâm dữ liệu. |

- Cần hệ thống SXM chuyên dụng, không thể sử dụng trên server PCIe phổ thông. - TDP 400W, yêu cầu làm mát tốt hơn so với PCIe. |

5. Mua NVIDIA A100 tại CNTTShop, Chính hãng, giá tốt

NVIDIA A100 là GPU lý tưởng cho AI, HPC và Big Data, mang đến hiệu suất vượt trội, bộ nhớ HBM2e tốc độ cao và khả năng mở rộng linh hoạt. Với 4 phiên bản khác nhau, A100 phù hợp cho cả AI Training, AI Inference và mô phỏng khoa học, đáp ứng nhu cầu từ server phổ thông đến hệ thống chuyên dụng SXM4. Nhờ NVLink, MIG và Sparsity, A100 tối ưu cả hiệu suất tính toán lẫn chi phí vận hành, giúp doanh nghiệp tăng tốc xử lý AI mà vẫn kiểm soát được ngân sách. Đây là lựa chọn hàng đầu cho các trung tâm dữ liệu AI hiện đại.

CNTTShop là đơn vị cung cấp GPU NVIDIA A100 chính hãng, cam kết mang đến mức giá tốt nhất cùng chế độ bảo hành đầy đủ. Với kinh nghiệm triển khai giải pháp AI, HPC và Data Center, CNTTShop hỗ trợ tư vấn chọn GPU phù hợp, đảm bảo hiệu suất tối ưu cho từng nhu cầu. Chúng tôi cung cấp sản phẩm chính hãng, giao hàng nhanh, hỗ trợ kỹ thuật chuyên sâu, giúp doanh nghiệp triển khai AI hiệu quả với chi phí hợp lý.

Địa chỉ phân phối GPU NVIDIA A100 tại Hà Nội

Công Ty TNHH Công Nghệ Việt Thái Dương - CNTTShop

Địa chỉ: NTT03, Thống Nhất Complex, 82 Nguyễn Tuân, Thanh Xuân, Hà Nội.

Điện Thoại: 0906 051 599

Email: kd@cnttshop.vn

website: cnttshop.vn

Địa chỉ phân phối GPU NVIDIA A100 tại TP. Hồ Chí Minh

Công Ty TNHH Công Nghệ Việt Thái Dương - CNTTShop

Địa chỉ: Số 13, đường 7C, khu phố 4, phường An Phú, TP Thủ Đức, Hồ Chí Minh.

Điện Thoại: 0906 051 599

Email: kd@cnttshop.vn

website: cnttshop.vn

.png)

Bạn đang cần tư vấn về sản phẩm: A100 ?