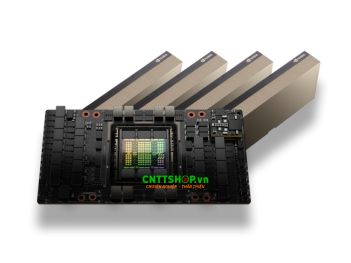

1. Giới thiệu về GPU H100 SXM5 80GB

NVIDIA H100 SXM5 80GB là GPU được xây dựng dựa trên kiến trúc NVIDIA Hopper, có hiệu năng tối ưu dành cho các hoạt động đào tạo, suy luận AI và môi trường HPC. H100 SXM5 80GB sử dụng kết nối NVLink Gen 4 thông qua NVSwitch tạo ra một hệ thống vận chuyển dữ liệu tốc độ cao lên tới 900 GB/s. Cung cấp dung lượng bộ nhớ 80GB HBM3 với băng thông 3.35TB/s, sản phẩm này có thể xử lý khối lượng dữ liệu khổng lồ với tốc độ cao và độ trễ thấp.

2. Đánh giá hiệu năng của sản phẩm

Được xây dựng trên kiến trúc Hopper, H100 SXM5 80GB sở hữu những con số ấn tượng như:

- 8 GPCs, 66 TPCs và 132 SMs.

- 16,896 CUDA Cores.

- 528 Tensor Cores thế hệ thứ 4.

- Hiệu suất FP8 có thể đạt tới 3,958 TFLOPS.

Những con số này cho thấy, GPU này có thể xử lý song song hiệu quả trong các tác vụ đồ hoạ, AI và HPC. Các Tensor Cores thế hệ 4 có khả năng xử lý các dạng số học tiên tiến như FP8, giúp tăng tốc độ huấn luyện và suy luận AI, tối ưu hoá thời gian xử lý lượng dữ liệu lớn.

Trang bị 80GB HBM3, gồm 5 stack HBM3 kết nối với GPU thông qua 10 bộ điều khiển bộ nhớ 512-bit, cung cấp tổng băng thông 3.35 TB/s - cao hơn đáng kể so với 2TB/s của A100. Điều này mang đến khả năng xử lý nhanh chóng các tập dữ liệu lớn trong AI, phân tích dữ liệu và mô phỏng khoa học.

Ngoài ra, bộ nhớ đệm L2 Cache 50MB đóng vai trò quan trọng trong việc giảm độ trễ truy xuất dữ liệu, giúp cải thiện hiệu suất trong các thuật toán AI và HPC mà không cần truy cập quá nhiều vào bộ nhớ HBM3.

Thông qua việc hỗ trợ kết nối NVLink thế hệ thứ 4, tổng băng thông của hệ thống trên 900GB/s, cho phép kết nối nhiều GPU hiệu quả, đặc biệt hữu ích trong các trung tâm dữ liệu và siêu máy tính. GPU này hỗ trợ PCIe Gen 5, mang lại băng thông gấp đôi PCIe Gen 4, giúp tối ưu tốc độ truyền tải dữ liệu giữa GPU và CPU, cải thiện hiệu suất hệ thống tổng thể.

3. Các tính năng nổi bật của H100 SXM5 80G

NVIDIA H100 SXM5 80G được thiết kế với nhiều tính năng quan trọng, giúp cải thiện hiệu suất tính toán song song, giảm độ trễ bộ nhớ và tăng tốc độ xử lý dữ liệu.

3.1. Thread Block Clusters

Thread Block Clusters là một tính năng mới trong kiến trúc NVIDIA Hopper (H100), cho phép một nhóm Thread Blocks hoạt động đồng thời trên nhiều Streaming Multiprocessors (SMs) trong cùng một GPU. Nhờ đó, hiệu suất xử lý song song được nâng cao, giúp tối ưu hoá hiệu năng cho các ứng dụng AI, HPC và đồ hoạ phức tạp.

Thông qua cơ chế đồng bộ hóa phần cứng và mạng kết nối SM-to-SM chuyên dụng, các Thread Block trong cùng một Cluster có thể trao đổi dữ liệu một cách nhanh chóng mà không cần thông qua bộ nhớ toàn cục.

3.2. Distributed Shared Memory (DSMEM)

Thay vì việc các Thread Blocks cần phải ghi dữ liệu vào bộ nhớ toàn cục để các Thread khác có thể đọc được làm giảm thời gian trao đổi dữ liệu, DSMEM cho phép toàn bộ bộ nhớ chia sẻ trên các SMs trong một Cluster được ánh xạ vào một không gian địa chỉ chung, cho phép các Threads truy cập trực tiếp dữ liệu của các Thread Blocks khác mà không cần qua bộ nhớ toàn cục.

Không chỉ giúp tăng tốc độ truy cập dữ liệu, tính năng này cũng được hỗ trợ bởi mạng kết nối tương tự như Tread Blocks, giúp cải thiện độ trễ khi truy cập bộ nhớ từ xa. Nhờ đó tốc độ truyền dữ liệu giữa các Thread Blocks có thể nhanh hơn gấp 7 lần so với việc sử dụng bộ nhớ toàn cục. Tính năng này cung cấp một cơ chế truy cập chung vào vùng nhớ DSMEM, giúp nhiều Thread Blocks có thể tham chiếu đến cùng một dữ liệu mà không phải sao chép qua bộ nhớ toàn cục. Ngoài ra, các thao tác DSMEM có thể thực hiện thông qua các hoạt động sao chép không đồng bộ, kết hợp với rào cản bộ nhớ chia sẻ, giúp đồng bộ hoá dữ liệu một cách chính xác mà không làm gián đoạn quá trình xử lý của GPU.

3.3. Asynchronous Execution

Tính năng trên H100 SXM5 80G cho phép thực hiện đồng thời nhiều hoạt động khác nhau để tối đa hoá hiệu suất và tối ưu hoá việc sử dụng tài nguyên. Trong kiến trúc NVIDIA Hopper (H100), tính năng TMA tối ưu việc sao chép dữ liệu giữa bộ nhớ toàn cục và bộ nhớ chia sẻ. Với mô hình copy descriptor, TMA xử lý dữ liệu đa chiều hiệu quả hơn và hoạt động không đồng bộ, cho phép threads tiếp tục tính toán mà không cần chờ dữ liệu.

Ngoài ra, Asynchronous Transaction Barrier giúp đồng bộ hoá linh hoạt hơn bằng cách đếm số lượng giao dịch bộ nhớ, thay vì chỉ theo dõi số thread. Như vậy sẽ đảm bảo dữ liệu sẵn sàng trước khi tiếp tục xử lý, tăng hiệu quả trao đổi dữ liệu không đồng bộ.

3.4. MIG

Multi-Instance GPU (MIG) là tính năng cho phép chia nhỏ GPU thành nhiều phân vùng độc lập, mỗi GPU Instance trên H100 SXM5 có dung lượng tính toán gấp 3 lần và băng thông bộ nhớ gần gấp đôi so với A100.

NVIDIA H100 SXM nâng cao bảo mật với khả năng hỗ trợ đầy đủ các cấu hình MIG, cho phép nhiều người dùng hoặc ứng dụng khác nhau có thể sử dụng các phần GPU mà không ảnh hưởng đến nhau. Việc tối ưu hoá tài nguyên cũng là một điểm nổi bật khi mỗi GPU Instance trên H100 có thể sở hữu các bộ giải mã hình ảnh và video chuyên dụng như NVDEC và NVJPG, giúp tăng tốc xử lý đa tác vụ khác đang chạy trên GPU.

4. Thông số kỹ thuật sản phẩm

|

NVIDIA H100 SXM5 80GB |

|

|

GPU Architecture |

NVIDIA Hopper |

|

Board Form Factor |

SXM5 |

|

Số lượng SM (Streaming Multiprocessors) |

132 |

|

Số lượng TPC (Texture Processing Clusters) |

66 |

|

Số lượng FP32 Cores/SM |

128 |

|

Số lượng FP32 Cores/GPU |

16896 |

|

Số lượng FP64 Cores/SM |

64 |

|

Số lượng FP64 Cores/GPU |

8448 |

|

Số lượng INT32 Cores/SM |

64 |

|

Số lượng INT32 Cores/GPU |

8448 |

|

Số lượng Tensor Cores/SM |

4 |

|

Số lượng Tensor Cores/GPU |

528 |

|

GPU Boost Clock cho FP8, FP16, BF16, TF32 Tensor Core Ops |

1830 MHz |

|

GPU Boost Clock cho FP64 Tensor Core Ops, FP32 và FP64 non-Tensor Core Ops |

1980 MHz |

|

Peak FP8 Tensor TFLOPS (FP16 Accumulate) |

1978.9/3957.8 |

|

Peak FP8 Tensor TFLOPS (FP32 Accumulate) |

1978.9/3957.8 |

|

Peak FP16 Tensor TFLOPS (FP16 Accumulate) |

989.4/1978.9 |

|

Peak FP16 Tensor TFLOPS (FP32 Accumulate) |

989.4/1978.9 |

|

Peak BF16 Tensor TFLOPS (FP32 Accumulate) |

989.4/1978.9 |

|

Peak TF32 Tensor TFLOPS |

494.7/989.4 |

|

Peak FP64 Tensor TFLOPS |

66.9 |

|

Peak INT8 Tensor TOPS |

1978.9/3957.8 |

|

Peak FP16 TFLOPS (non-Tensor) |

133.8 |

|

Peak BF16 TFLOPS (non-Tensor) |

133.8 |

|

Peak FP32 TFLOPS (non-Tensor) |

66.9 |

|

Peak FP64 TFLOPS (non-Tensor) |

33.5 |

|

Peak INT32 TOPS |

33.5 |

|

Texture Units |

528 |

|

Memory Interface |

5120-bit HBM3 |

|

Memory Size |

80 GB |

|

Memory Data Rate |

2619 MHz DDR |

|

Memory Bandwidth |

3352 GB/sec |

|

L2 Cache Size |

50 MB |

|

Shared Memory Size/SM |

Configurable up to 228 KB |

|

Register File Size/SM |

256 KB |

|

Register File Size/GPU |

33792 KB |

|

TDP |

Up to 700 Watts (configurable) |

|

Số lượng Transistors |

80 billion |

|

GPU Die Size |

814 mm2 |

|

TSMC Manufacturing Process |

4N customized for NVIDIA |

|

Compute Capability |

9.0 |

5. H100 SXM5 ứng dụng trong môi trường nào?

NVIDIA H100 SXM5 80GB được thiết kế cho các môi trường AI và HPC mở rộng với mật độ hiệu suất đa petaflop cực cao. GPU này phù hợp với các mô hình và tập dữ liệu yêu cầu cao như:

- Mô phỏng HPC quy mô lớn: H100 SXM5 được thiết kế với khả năng thực hiện giao tiếp trực tiếp với CPU và GPU khác trong hệ thống, giúp giảm độ trễ và tăng hiệu suất xử lý. Nhờ đó, nó có thể thực hiện các phép tính khổng lồ và tốc độ truyền tải dữ liệu cao.

- Huấn luyện AI trên hệ thống dữ liệu lớn: Những mô hình AI hiện đại như mô hình ngôn ngữ lớn (LLM), mô hình thị giác máy tính (CV) hay Deep Learning đòi hỏi phải phân tích lượng dữ liệu lớn trong quá trình đào tạo. GPU H100 SXM5 có khả năng kết nối trực tiếp với CPU thông qua giao tiếp NVLink và PCIe, giúp tăng tốc độ truyền dữ liệu giữa bộ nhớ và GPU.

- Nghiên cứu thành phần thuốc và vật liệu: Trong lĩnh vực y học và khoa học vật liệu, các nhà nghiên cứu cần thực hiện mô phỏng phân từ, phân tích cấu trúc protein hoặc thiết kế vật liệu mới bằng các thuật toán phức tạp. GPU cần có khả năng xử lý nhiều phép tính đồng thời với băng thông bộ nhớ cao để tải dữ liệu lớn. H100 SXM5 có thể giúp tăng tốc độ mô phỏng và phân tích dữ liệu, nhờ đó rút ngắn thời gian nghiên cứu và phát triển các loại thuốc và vật liệu mới.

6. Mua GPU H100 SXM5 80GB chính hãng, giá tốt ở đâu?

Sản phẩm H100 SXM5 80GB là một trong những GPU cao cấp hàng đầu của NVIDIA dành cho các ứng dụng tính toán hiệu suất cao (HPC) và trí tuệ nhân tạo (AI) được thiết kế theo kiến trúc Hopper. Với 80GB HBM3 dung lượng bộ nhớ, GPU này cung cấp băng thông bộ nhớ lên đến 3.35TB/s, gần gấp đôi so với thế hệ A100. Sử dụng form factor SXM5, sản phẩm hỗ trợ NVLink Gen 4, cung cấp băng thông 900GB/s khi kết nối với các GPU khác trong cùng hệ thống.

CNTTShop là nhà cung cấp uy tín các sản phẩm GPU NVIDIA chính hãng với mức giá cạnh tranh, được đông đảo khách hàng tại Việt Nam tin tưởng. Với hai chi nhánh tại Hà Nội và TP. Hồ Chí Minh, cùng nguồn hàng luôn sẵn kho số lượng lớn, chúng tôi đảm bảo giao hàng nhanh chóng trên toàn quốc. Liên hệ ngay để nhận tư vấn miễn phí và trải nghiệm dịch vụ chuyên nghiệp từ đội ngũ chuyên gia của chúng tôi!

6.1. Địa chỉ cung cấp sản phẩm NVIDIA chính hãng tại Hà Nội

Công Ty TNHH Công Nghệ Việt Thái Dương - CNTTShop

Địa chỉ: NTT03, Thống Nhất Complex, 82 Nguyễn Tuân, Thanh Xuân, Hà Nội.

Điện Thoại: 0906 051 599

Email: kd@cnttshop.vn

website: cnttshop.vn

6.2. Địa chỉ cung cấp sản phẩm NVIDIA chính hãng tại TP.Hồ Chí Minh

Công Ty TNHH Công Nghệ Việt Thái Dương - CNTTShop

Địa chỉ: Số 13, đường 7C, khu phố 4, phường An Phú, TP Thủ Đức, Hồ Chí Minh.

Điện Thoại: 0906 051 599

Email: kd@cnttshop.vn

website: cnttshop.vn

.png)

Bạn đang cần tư vấn về sản phẩm: H100 SXM5 ?