Switch

Switch Wifi - Access Point

Wifi - Access Point Firewall

Firewall Router

Router Module Quang

Module Quang![Module Quang Cisco]() Module Quang Cisco

Module Quang Cisco![Module quang HPE]() Module quang HPE

Module quang HPE![Module quang Maipu]() Module quang Maipu

Module quang Maipu![Module quang Brocade]() Module quang Brocade

Module quang Brocade![Module quang Fortinet]() Module quang Fortinet

Module quang Fortinet![Module quang Aruba]() Module quang Aruba

Module quang Aruba![Module quang OEM]() Module quang OEM

Module quang OEM![Module quang Juniper]() Module quang Juniper

Module quang Juniper![Module quang Dell]() Module quang Dell

Module quang Dell![Module quang Palo Alto]() Module quang Palo Alto

Module quang Palo Alto![Module quang Huawei]() Module quang Huawei

Module quang Huawei![Module quang Arista]() Module quang Arista

Module quang Arista![Module quang F5]() Module quang F5

Module quang F5![Module quang H3C]() Module quang H3C

Module quang H3C![Module Quang Allied Telesis]() Module Quang Allied Telesis

Module Quang Allied Telesis![Module quang SonicWall]() Module quang SonicWall

Module quang SonicWall![Module quang Mikrotik]() Module quang Mikrotik

Module quang Mikrotik![Module quang Handar]() Module quang Handar

Module quang Handar- Module-quang-Finisar

Máy chủ (Server)

Máy chủ (Server)Hãng sản xuất

Chassis

Cấu hình

Máy trạm Workstation

Thiết bị lưu trữ (SAN, NAS)

Thiết bị lưu trữ (SAN, NAS) Load Balancing

Load Balancing Video Conferencing

Video Conferencing Phụ kiện máy chủ

Phụ kiện máy chủ Thiết Bị IoT

Thiết Bị IoT Phụ Kiện Mạng

Phụ Kiện Mạng

NVIDIA DGX B200 - Siêu máy chủ AI thế hệ mới tối ưu hóa hiệu năng cho AI, HPC và Generative AI

- 8 GPU B200 NVIDIA Tensor Core.

- Kết nối GPU: NVLink thế hệ 5, băng thông 14.4 TB/s.

- CPU: 2x Intel Xeon 8570 PCIe Gen5.

- Lưu trữ hệ điều hành: 2x 1.92 TB NVMe M.2 SSD.

- Bộ nhớ đệm: 8x 3.84 TB NVMe U.2 SED.

- Bộ nhớ hệ thống: Tối đa 4TB.

- Cổng kết nối mạng: 4 cổng OSFP (hỗ trợ kết nối card NVIDIA ConnectX-7 VPI) và 2 cổng dual-port QSFP112 NVIDIA BlueField-3 DPU.

- Phần mềm hỗ trợ: NVIDIA AI Enterprise, NVIDIA Base Command.

- Hệ điều hành: DGX OS/ Ubuntu.

BẠN ĐANG QUAN TÂM MÁY CHỦ NÀY?

Hotline: 0866 176 188 - 0968 498 887 Hotline: 0868 397 388 - 0866 851 388Có thể thuê máy chủ này! Vui lòng liên hệ tới chúng tôi để được hỗ trợ tốt nhất.

AI đang thay đổi hoàn toàn cách doanh nghiệp vận hành, từ tự động hóa quy trình, nâng cao dịch vụ khách hàng đến tạo ra những hiểu biết sâu sắc và thúc đẩy đổi mới. Tuy nhiên, với sự phát triển không ngừng của các khối lượng công việc AI, nhu cầu về năng lực tính toán vượt xa khả năng thông thường của nhiều doanh nghiệp. NVIDIA DGX B200 giúp các doanh nghiệp tăng tốc thời gian xử lý dữ liệu và khai thác tối đa tiềm năng của AI, đáp ứng mọi nhu cầu khắt khe trong môi trường AI hiện đại. Hãy cùng CNTTShop tìm hiểu về NVIDIA DGX B200 ở bài viết dưới đây!

1. Giới thiệu NVIDIA DGX B200

NVIDIA DGX B200 là máy chủ AI chuyên dụng có thiết kế đặc biệt để xử lý các tác vụ AI phức tạp như học sâu (Deep Learning), mô hình ngôn ngữ lớn (LLMs) và thị giác máy tính (Computer Vision). Được trang bị 8 GPU NVIDIA Blackwell B200 Tensor Core, DGX B200 mang đến khả năng tính toán ấn tượng, có thể xử lý các tác vụ AI đòi hỏi băng thông cao và tốc độ tính toán cực lớn.

Hệ thống này sở hữu băng thông bộ nhớ lên đến 64 TB/s HBM3e cùng băng thông kết nối GPU 14.4 TB/s nhờ 2 NVIDIA NVSwitch, đảm bảo hiệu suất xử lý khối lượng dữ liệu khổng lồ theo thời gian thực. Đặc biệt, khả năng kết nối mạng của DGX B200 hỗ trợ lên đến 400Gbps qua InfiniBand và Ethernet, giúp doanh nghiệp dễ dàng mở rộng hạ tầng AI theo yêu cầu.

2. Cấu tạo phần cứng của siêu máy chủ NVIDIA DGX B200

Siêu máy chủ AI DGX B200 được thiết kế với cấu trúc phần cứng tối ưu hoá cho mọi giai đoạn của quá trình phát triển trí tuệ nhân tạo.

2.1. GPU NVIDIA Blackwell B200 Tensor Core

Điểm nổi bật nhất của máy chủ thế hệ mới này chính là việc tích hợp 8 GPU NVIDIA Blackwell với kiến trúc Tensor Core, mang đến hiệu suất tính toán nhanh chóng. Tensor Core không chỉ cải thiện khả năng thực thi các tác vụ AI thông thường mà còn xử lý tốt các phép toán ma trận. So với phiên bản tiền nhiệm DGX H100, hệ thống này có thể tăng hiệu suất đào tạo lên gấp 3 lần và suy luận lên gấp 15 lần, đáp ứng tốt về mặt tốc độ cho các ứng dụng AI.

2.2. Bộ nhớ và lưu trữ linh hoạt

DGX B200 được trang bị 2TB RAM, có thể mở rộng lên đến 4TB, hỗ trợ các mô hình AI quy mô lớn và xử lý nhiều tác vụ đồng thời mà không gặp phải tình trạng nghẽn. Hệ thống sử dụng 2 ổ NVMe M.2 1.9TB cho hệ điều hành và ứng dụng quan trọng, giúp giảm độ trễ và tối ưu hóa việc khởi động và tải ứng dụng AI. Ngoài ra, 8 ổ NVMe U.2 3.84TB cung cấp không gian lưu trữ tốc độ cao cho các tập dữ liệu AI lớn.

2.3. NVSwitch – Kết nối GPU băng thông siêu cao

NVIDIA DGX B200 được trang bị 2 NVSwitch thế hệ thứ 5, cung cấp băng thông tổng cộng lên đến 14.4 TB/s, đảm bảo khả năng kết nối giữa các GPU Blackwell với tốc độ vượt trội. Công nghệ NVIDIA NVLink tích hợp cho phép các GPU giao tiếp trực tiếp mà không thông qua CPU hoặc bộ nhớ hệ thống trung gian, giúp tối ưu hóa tốc độ truyền dữ liệu và giảm độ trễ trong các tác vụ tính toán phức tạp.

Với khả năng kết nối toàn diện, NVSwitch cho phép DGX B200 tận dụng tối đa hiệu suất của từng GPU, một yếu tố quan trọng trong huấn luyện các mô hình AI quy mô lớn như LLMs (Large Language Models) và Generative AI. Việc chia sẻ bộ nhớ giữa các GPU trở nên hiệu quả hơn, giúp xử lý dữ liệu khối lượng lớn mà không gặp tình trạng nghẽn băng thông hay gián đoạn.

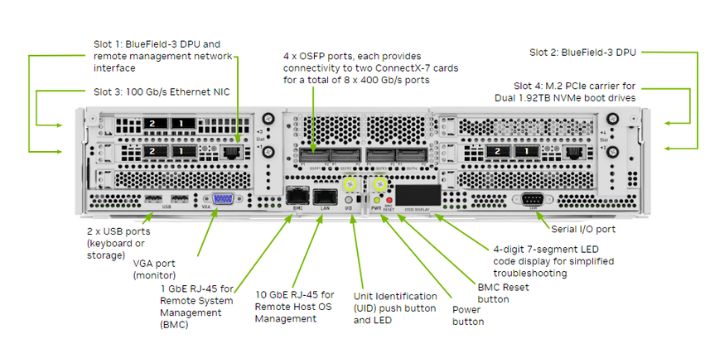

2.4. Hệ thống cổng kết nối mạng tốc độ cao

NVIDIA DGX B200 sở hữu hệ thống cổng kết nối tốc độ cao, giúp tối ưu hóa hiệu suất xử lý dữ liệu trong các tác vụ AI và HPC (High-Performance Computing). Hệ thống bao gồm 4 cổng OSFP và 2 cổng kép QSFP112, cung cấp tốc độ truyền dữ liệu lên đến 400Gb/s cho cả Ethernet và InfiniBand.

Các cổng OSFP, khi sử dụng với NVIDIA ConnectX-7 VPI, cung cấp 8 kênh kết nối tốc độ cao với khả năng chuyển đổi linh hoạt giữa các công nghệ truyền dữ liệu. VPI (Virtual Protocol Interconnect) cho phép xử lý dữ liệu lớn hiệu quả, giúp hệ thống hạn chế tình trạng nghẽn băng thông và đảm bảo khả năng vận hành ổn định ngay cả trong các môi trường tính toán phức tạp.

Trong khi đó, 2 cổng kép QSFP112 kết nối trực tiếp với NVIDIA BlueField-3 DPU, đóng vai trò tách biệt trong việc xử lý các nhiệm vụ quản lý dữ liệu, mạng và bảo mật. BlueField-3 DPU giúp giảm tải đáng kể cho CPU và GPU bằng cách thực hiện các tác vụ quản lý độc lập. Đồng thời, nó cung cấp khả năng tối ưu hóa băng thông và độ trễ thấp, đi kèm với các tính năng bảo mật nâng cao như mã hóa dữ liệu toàn diện và kiểm soát truy cập thông minh.

3. Hệ sinh thái phần mềm tối ưu hoá AI của DGX B200

DGX B200 không chỉ sở hữu sức mạnh phần cứng vượt trội mà còn được hỗ trợ bởi một hệ sinh thái phần mềm chuyên dụng từ NVIDIA, tối ưu hóa cho việc phát triển, đào tạo và triển khai các ứng dụng AI. Các phần mềm này cho phép nhà phát triển tận dụng toàn bộ tiềm năng của hệ thống một cách hiệu quả và dễ dàng mở rộng khi cần thiết.

NVIDIA AI Enterprise: Là nền tảng phần mềm toàn diện, tích hợp sẵn các framework AI phổ biến như TensorFlow và PyTorch, giúp chúng tận dụng triệt để hiệu năng của GPU Tensor Core. Sự tối ưu hóa này giúp rút ngắn thời gian đào tạo mô hình, đồng thời tăng độ linh hoạt trong việc triển khai AI trên quy mô lớn. NVIDIA AI Enterprise cũng hỗ trợ khả năng tự động hóa xử lý dữ liệu, giúp doanh nghiệp tiết kiệm thời gian và tài nguyên.

NVIDIA Base Command: Hoạt động như một trung tâm điều phối thông minh giúp quản lý tất cả tài nguyên trong hệ thống DGX B200 hiệu quả. Base Command có thể tự động phân bổ GPU cho các tác vụ AI dựa trên yêu cầu cụ thể, đảm bảo mọi tác vụ nhận đủ tài nguyên để hoạt động tối ưu. Ngoài ra, tính năng lập lịch trình xử lý thông minh giúp giảm thời gian chờ đợi giữa các tác vụ. Quản trị viên có thể giám sát hiệu suất theo thời gian thực thông qua giao diện quản lý trực quan để xử lý kịp thời mọi vấn đề về hiệu suất.

DGX OS: Hệ điều hành dựa trên Ubuntu, được tối ưu hóa đặc biệt cho các tác vụ AI. Hệ điều hành này tích hợp các trình điều khiển NVIDIA mới nhất, giúp các GPU Tensor Core hoạt động trơn tru với hiệu suất cao nhất. DGX OS còn giúp tăng tốc quá trình khởi động hệ thống và tải dữ liệu cho các mô hình lớn, trong khi tính năng bảo mật tích hợp đảm bảo an toàn dữ liệu AI khỏi các mối đe dọa tiềm ẩn.

CUDA-X: Bộ thư viện phần mềm và công cụ hỗ trợ tăng tốc các ứng dụng AI và tính toán hiệu năng cao (HPC). Các thư viện như cuDNN giúp xử lý Deep Neural Networks (DNN) nhanh hơn, rút ngắn thời gian đào tạo mô hình. Trong khi đó, TensorRT tối ưu hóa các mô hình để suy luận với tốc độ nhanh hơn mà vẫn duy trì độ chính xác cao – rất phù hợp cho các ứng dụng thời gian thực. Các thư viện cuBLAS và cuSPARSE cũng được tối ưu để tăng tốc các phép toán ma trận và đại số tuyến tính, giúp quá trình xử lý dữ liệu AI trở nên mượt mà hơn.

4. NVIDIA cung cấp những dịch vụ hỗ trợ nào cho DGX B200?

NVIDIA cung cấp hệ sinh thái dịch vụ toàn diện để hỗ trợ các doanh nghiệp triển khai và tối ưu hóa hiệu quả sử dụng DGX B200, giúp đẩy nhanh quá trình phát triển AI từ khâu cài đặt đến vận hành liên tục.

NVIDIA Enterprise Services: Hỗ trợ kỹ thuật chuyên sâu, tối ưu hóa hệ thống và xử lý sự cố, giúp doanh nghiệp khai thác tối đa khả năng của DGX B200.

NVIDIA Deep Learning Institute (DLI): Các khóa đào tạo AI chuyên sâu, hướng dẫn phát triển và tối ưu mô hình AI trên nền tảng DGX B200, giúp nâng cao kỹ năng cho đội ngũ kỹ thuật.

Enterprise Business-Standard Support: Bảo hành phần cứng và phần mềm trong 3 năm, hỗ trợ 24/7 qua cổng thông tin và hỗ trợ trực tiếp trong giờ làm việc, đảm bảo hệ thống luôn hoạt động ổn định.

5. Thông số kỹ thuật sản phẩm

|

DGX B200 Technical Specifications |

|

|

GPU |

8x NVIDIA B200 Tensor Core GPUs |

|

GPU Memory |

1,440GB total |

|

Performance |

72 petaFLOPS training and 144 petaFLOPS inference |

|

NVIDIA® NVSwitch™ |

2x |

|

System Power Usage |

~14.3kW max |

|

CPU |

2 Intel® Xeon® Platinum 8570 Processors (112 Cores total, 2.1 GHz Base, 4 GHz Max Boost) |

|

System Memory |

Up to 4TB |

|

Networking |

4x OSFP ports (8x single-port NVIDIA ConnectX-7 VPI) – Up to 400Gb/s InfiniBand/Ethernet 2x dual-port QSFP112 NVIDIA BlueField-3 DPU – Up to 400Gb/s InfiniBand/Ethernet |

|

Management Network |

10Gb/s onboard NIC with RJ45 100Gb/s dual-port ethernet NIC Host baseboard management controller (BMC) with RJ45 |

|

Storage |

OS: 2x 1.9TB NVMe M.2 Internal storage: 8x 3.84TB NVMe U.2 |

|

Software |

NVIDIA AI Enterprise – Optimized AI Software NVIDIA Base Command – Orchestration, Scheduling, and Cluster Management DGX OS / Ubuntu – Operating System |

|

Rack Units (RU) |

10 RU |

|

System Dimensions |

Height: 17.5in (444mm) Width: 19.0in (482.2mm) Length: 35.3in (897.1mm) |

|

Operating Temperature |

5–30°C (41–86°F) |

|

Enterprise Support |

Three-year Enterprise Business-Standard Support for hardware and software 24/7 Enterprise Support portal access Live agent support during local business hours |

6. Liên hệ CNTTShop để mua sản phẩm máy chủ NVIDIA DGX B200 chính hãng

NVIDIA DGX B200 là giải pháp máy chủ AI toàn diện, có hiệu suất mạnh mẽ và linh hoạt cho các doanh nghiệp trong kỷ nguyên trí tuệ nhân tạo. Được trang bị 8 GPU NVIDIA Blackwell và bộ nhớ HBM3e băng thông cao, hệ thống này tối ưu hóa cả quá trình huấn luyện và suy luận, đảm bảo xử lý hiệu quả các mô hình AI phức tạp. Đóng vai trò là nền tảng cho NVIDIA DGX BasePOD và SuperPOD, DGX B200 cho phép mở rộng cơ sở hạ tầng AI dễ dàng, phù hợp với mọi quy mô doanh nghiệp

CNTTShop tự hào là đơn vị cung cấp chính hãng NVIDIA DGX B200 uy tín hàng đầu tại Việt Nam. Chúng tôi cam kết mang đến cho khách hàng những sản phẩm chất lượng cao, đã được kiểm tra kỹ lưỡng trước khi giao. Đội ngũ kỹ thuật giàu kinh nghiệm luôn sẵn sàng hỗ trợ nhanh chóng và tận tình để đảm bảo hệ thống của bạn vận hành hiệu quả nhất. Hãy liên hệ ngay với chúng tôi để nhận tư vấn chi tiết và trải nghiệm dịch vụ chuyên nghiệp hàng đầu!

6.1. Địa chỉ phân phối NVIDIA DGX B200 tại Hà Nội

Công Ty TNHH Công Nghệ Việt Thái Dương - CNTTShop

Địa chỉ: NTT03, Thống Nhất Complex, 82 Nguyễn Tuân, Thanh Xuân, Hà Nội.

Điện Thoại: 0906 051 599

Email: kd@cnttshop.vn

website: cnttshop.vn

6.2. Địa chỉ phân phối NVIDIA DGX B200 tại TP. Hồ Chí Minh

Công Ty TNHH Công Nghệ Việt Thái Dương - CNTTShop

Địa chỉ: Số 13, đường 7C, khu phố 4, phường An Phú, TP Thủ Đức, Hồ Chí Minh.

Điện Thoại: 0906 051 599

Email: kd@cnttshop.vn

website: cnttshop.vn

.png)

Bạn đang cần tư vấn về sản phẩm: #DGX B200 ?