Xây dựng Máy chủ AI Hiệu năng Cao - Tiết kiệm chi phí, Làm chủ hạ tầng CNTT và dữ liệu.

Khi trí tuệ nhân tạo (AI) không còn là một xu hướng ngắn hạn mà đã trở thành nền tảng cốt lõi trong nhiều lĩnh vực, việc sở hữu hạ tầng AI mạnh mẽ, ổn định và có khả năng mở rộng trở thành yếu tố then chốt. Trong đó, máy chủ AI (AI Server) chính là trung tâm xử lý của hệ thống, thiếu nó, doanh nghiệp khó triển khai hiệu quả mô hình ngôn ngữ lớn (LLM), xử lý dữ liệu lớn thời gian thực hay phát triển các ứng dụng AI có tính ứng dụng và cạnh tranh.

Nhiều doanh nghiệp đang tăng tốc lựa chọn và xây dựng cấu hình Máy chủ AI Tuy nhiên, đi kèm với đó là các vấn đề và câu hỏi như sau:

- Chi phí đầu tư và vận hành là bao nhiêu?

- Khả năng tùy biến và mở rộng như thế nào?

- Máy chủ AI với cấu hình như thế nào là phù hợp với mô hình và dữ liệu cần xử lý?

- Máy chủ AI cần GPU nào phù hợp?

- Điện năng tiêu thụ và tản nhiệt có đảm bảo không?

- Kết nối mạng (Networking) ra sao?

- Hệ thống lưu trữ (Storage) cần bao nhiêu TB?

- CPU & RAM cần ở mức nào? Bao nhiêu core..vv, bao nhiêu RAM là đủ để tránh nghẽn cổ chai?

- ...vv

Tại CNTTShop, chúng tôi đang cung cấp AI Server đồng bộ sẵn, đồng thời hỗ trợ giải pháp "Xây dựng Máy chủ AI" tùy chỉnh theo nhu cầu thực tế và khả năng mở rộng trong tương lai. Đây là lựa chọn chiến lược giúp bạn kiểm soát chi phí, làm chủ hạ tầng và toàn quyền sáng tạo trên hệ thống của chính mình.

Bạn có thể vận hành các mô hình học sâu phức tạp, huấn luyện LLM hàng tỷ tham số,..vv hay tạo ra âm nhạc, hình ảnh, video bằng AI, tất cả trên một hệ thống do chính bạn thiết kế, tối ưu và sở hữu. Đó không chỉ là sự tiện lợi, mà còn là năng lực cạnh tranh cốt lõi, mở ra khả năng đổi mới không giới hạn trong kỷ nguyên của AI.

Các thành phần và bước quan trọng khi xây dựng Máy chủ AI hiệu năng cao

Phân tích nhu cầu sử dụng

Trước khi bắt tay vào lựa chọn và xây dựng một máy chủ AI, việc quan trọng đầu tiên là xác định rõ nhu cầu sử dụng. Điều này giúp tránh lãng phí ngân sách và đảm bảo hệ thống phù hợp với mô hình AI mà doanh nghiệp muốn triển khai. Một số yếu tố cần phân tích bao gồm:

- Mục đích sử dụng: Máy chủ AI sẽ phục vụ cho việc gì? Huấn luyện mô hình học sâu (training), suy luận (inference), xử lý dữ liệu lớn thời gian thực, hay kết hợp nhiều tác vụ cùng lúc?

- Loại mô hình AI: Doanh nghiệp đang hoặc sẽ sử dụng mô hình nào? Ví dụ: LLM (Large Language Models), computer vision, hay hệ thống gợi ý (recommendation systems). Đồng thời, cần xem xét kích thước mô hình (số lượng tham số) để dự đoán nhu cầu phần cứng.

- Ngân sách: Mức đầu tư dành cho máy chủ AI là bao nhiêu? Đây là yếu tố quyết định việc lựa chọn GPU cao cấp (như Nvidia H100, H200) hay các giải pháp tiết kiệm hơn (như Nvidia RTX Pro 6000, L40, L40s..).

- Khả năng mở rộng: Doanh nghiệp có kế hoạch nâng cấp khi workload tăng lên không? Nếu có, cần lựa chọn kiến trúc cho phép bổ sung GPU, RAM hoặc nâng cấp hạ tầng mạng mà không phải thay mới toàn bộ.

- Môi trường triển khai: Máy chủ sẽ đặt tại on-premises (trong doanh nghiệp) hay tại các Data Center của Viettel, VNPT, FPT, CMC…? Yếu tố này ảnh hưởng trực tiếp đến thiết kế hạ tầng nguồn điện, tản nhiệt và khả năng kết nối mạng.

Mô hình triển khai máy chủ AI là gì?

Máy chủ AI có thể được triển khai theo nhiều mô hình khác nhau, tùy thuộc vào quy mô ứng dụng và yêu cầu tính toán của doanh nghiệp. Có thể chia thành ba cấp độ chính:

- Nghiên cứu & thử nghiệm (R&D, Test demo): Ở giai đoạn thử nghiệm mô hình hoặc phát triển nguyên mẫu (prototype), chỉ cần máy chủ với 1 đến 2 GPU tầm trung như RTX A6000, RTX Pro 6000 Max-Q/Server, A100 hoặc H100. Cấu hình này đủ để chạy inference, fine-tuning mô hình vừa và nhỏ, hoặc demo ứng dụng AI trước khi triển khai thực tế.

- Triển khai mô hình AI quy mô vừa: Khi cần huấn luyện hoặc vận hành các mô hình AI phức tạp hơn, đặc biệt trong doanh nghiệp vừa và lớn, cần hệ thống 4 đến 8 GPU hiệu năng cao như RTX Pro 6000 Server Edition, H100, H200. Đây là cấu hình phổ biến cho các workload AI/ML, computer vision, recommendation systems ở mức sản xuất (production).

- AI Training quy mô lớn (LLM, GenAI): Với những mô hình ngôn ngữ lớn (LLM) hoặc Generative AI có hàng tỷ tham số, cần cụm máy chủ (AI cluster) 8 đến 16 GPU kết nối qua NVLink/NVSwitch và sử dụng bộ nhớ HBM dung lượng lớn. Đây là mô hình hạ tầng ở cấp độ doanh nghiệp hoặc trung tâm nghiên cứu, cho phép huấn luyện nhanh, xử lý dữ liệu khổng lồ và mở rộng theo nhu cầu trong tương lai.

Chọn khung máy chủ (Chasiss Server)

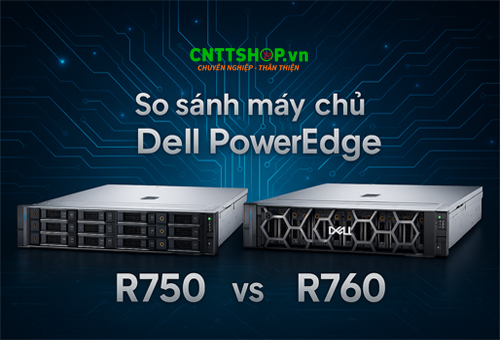

Việc lựa chọn khung máy chủ (chassis server) là bước quan trọng để đảm bảo hệ thống có thể đáp ứng nhu cầu xử lý AI hiện tại và khả năng mở rộng trong tương lai. Một chassis phù hợp cần hỗ trợ số lượng GPU lớn, khả năng tản nhiệt tối ưu và nguồn điện đủ mạnh. Một số dòng máy chủ tại CNTTShop đang được nhiều doanh nghiệp và tổ chức lựa chọn đó là:

- Dell PowerEdge R760XA, R750, R960xa: Dòng máy chủ cao cấp, hỗ trợ nhiều GPU và phù hợp cho hầu hết các workload AI/ML từ trung bình đến lớn.

- Supermicro / Asus ESC8000A-E12 / E13: Thiết kế chuyên dụng cho AI, hỗ trợ tới 8 GPU dạng SXM hoặc PCIe, thích hợp cho các tác vụ huấn luyện AI chuyên sâu.

- NVIDIA DGX H100/H200: Giải pháp máy chủ AI đồng bộ "all-in-one" dành cho AI training quy mô lớn, tích hợp sẵn phần cứng, phần mềm tối ưu, thường được các trung tâm nghiên cứu và doanh nghiệp lớn lựa chọn.

Chọn GPU "Trái tim" của AI Server

Trong bất kỳ hệ thống Máy chủ AI nào, GPU chính là thành phần quan trọng nhất, quyết định trực tiếp đến hiệu năng xử lý, khả năng huấn luyện và suy luận của mô hình. Việc lựa chọn GPU phù hợp cần dựa vào quy mô ứng dụng, độ phức tạp của mô hình và ngân sách đầu tư.

- Dung lượng VRAM: Khi chọn GPU cần đảm bảo đủ đủ bộ nhớ cho dataset và mô hình lớn, tránh tình trạng out-of-memory.

- Chuẩn tính toán: cân nhắc GPU hỗ trợ FP8/FP4 để tối ưu hiệu năng LLM và GenAI.

- Điện năng & tản nhiệt: GPU có hiệu năng cao tiêu thụ công suất lớn, đòi hỏi PSU và cooling tương ứng.

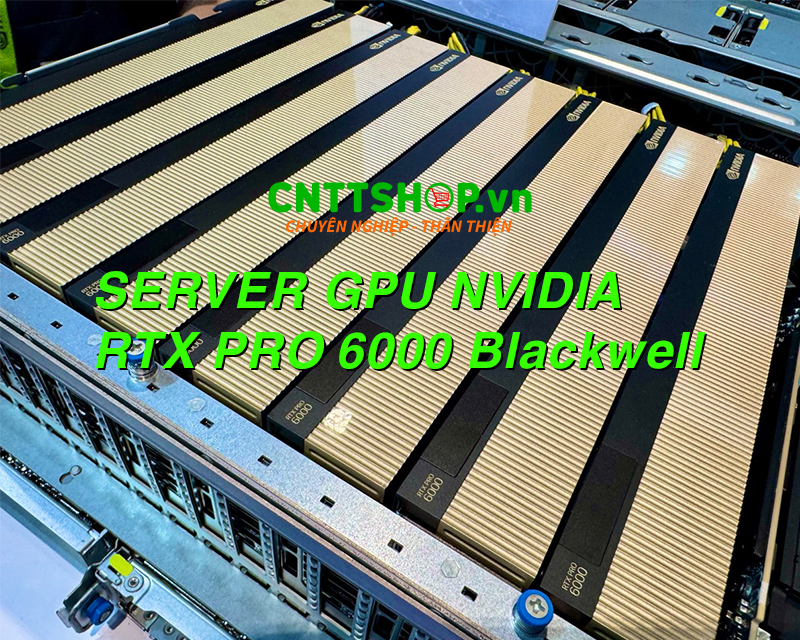

- RTX Series (A6000, RTX Pro 6000 Blackwell, RTX 6000 Ada): Đây là lựa chọn lý tưởng cho các tác vụ AI/ML tầm trung, bao gồm huấn luyện các mô hình vừa, inference tốc độ cao và xử lý hình ảnh, video. Ưu điểm là chi phí hợp lý hơn so với GPU Data Center nhưng vẫn cung cấp hiệu năng mạnh mẽ, phù hợp cho doanh nghiệp vừa và nhỏ hoặc phòng nghiên cứu.

- NVIDIA Data Center GPUs (A100, H100, H200, B200/GB200): Dành cho những mô hình AI khổng lồ như LLM hay Generative AI, các dòng GPU này hỗ trợ kết nối nhiều card thông qua NVLink/NVSwitch, mang lại băng thông siêu cao và hiệu năng vượt trội. Đây là lựa chọn tối ưu cho trung tâm dữ liệu, tập đoàn lớn hoặc những tổ chức cần hạ tầng AI cluster.

Lưu ý quan trọng: Khi triển khai hệ thống có nhiều người dùng, hãy kiểm tra khả năng hỗ trợ MIG (Multi-Instance GPU) để chia nhỏ tài nguyên GPU cho nhiều tác vụ, giúp tối ưu hiệu suất và giảm lãng phí.

GPU chính là “trái tim” của máy chủ AI. Doanh nghiệp cần cân nhắc giữa hiệu năng, ngân sách và khả năng mở rộng để lựa chọn GPU phù hợp, đảm bảo hệ thống vận hành ổn định và sẵn sàng cho các bài toán AI trong tương lai.

Bộ vi xử lý CPU & bộ nhớ RAM

Bên cạnh GPU, CPU và RAM là hai thành phần quan trọng giúp hệ thống AI Server vận hành ổn định, tránh nghẽn cổ chai và tận dụng tối đa sức mạnh của GPU.

CPU - Bộ vi xử lý

Để đảm bảo băng thông truyền dữ liệu giữa GPU và hệ thống, cần chọn CPU có số nhân cao và hỗ trợ nhiều lane PCIe Gen 4/5. Những dòng CPU thường được sử dụng cho máy chủ AI bao gồm:

- Intel Xeon Scalable Gen 4/5, tối ưu cho hệ thống đa socket, hỗ trợ nhiều GPU.

- AMD EPYC Genoa/Bergamo, nổi bật với số nhân lớn, băng thông bộ nhớ cao và khả năng mở rộng vượt trội.

RAM - Bộ nhớ hệ thống

Dung lượng RAM phải được thiết kế tối thiểu gấp 2–4 lần tổng VRAM của GPU để tránh tình trạng quá tải.

- Ví dụ: với cụm 8x H100 80GB (tổng 640GB VRAM) → cần 1TB đến 2TB RAM để hệ thống hoạt động trơn tru.

- Nên sử dụng DDR5 RDIMM ECC, vừa có tốc độ cao, vừa đảm bảo tính ổn định và khả năng sửa lỗi, giúp hệ thống duy trì hiệu suất liên tục khi chạy các tác vụ AI nặng.

CPU nhiều nhân + RAM dung lượng lớn chính là nền tảng để GPU phát huy tối đa sức mạnh, đặc biệt trong huấn luyện mô hình AI quy mô lớn (LLM, GenAI) hoặc xử lý dữ liệu big data.

Lưu trữ dữ liệu (Storage)

Trong hệ thống AI Server, lưu trữ dữ liệu là yếu tố không thể bỏ qua, bởi hầu hết workload AI đều yêu cầu truy xuất dữ liệu nhanh và liên tục. Việc thiết kế storage phù hợp sẽ giúp tăng tốc quá trình huấn luyện, giảm độ trễ và đảm bảo an toàn dữ liệu.

- SSD NVMe tốc độ cao: Dùng để lưu dataset và checkpoint, giúp tăng tốc độ đọc/ghi, rút ngắn thời gian huấn luyện và inference.

- Dung lượng lưu trữ: Tùy quy mô dự án, thường cần 15 đến 30TB SSD NVMe cho dữ liệu huấn luyện chính, kết hợp với HDD dung lượng lớn để lưu trữ lâu dài (archive, backup).

- Hỗ trợ RAID: Triển khai RAID 5/6/10 nhằm tăng độ an toàn dữ liệu và đảm bảo hệ thống vẫn hoạt động ổn định ngay cả khi xảy ra sự cố phần cứng.

Với chiến lược lưu trữ hợp lý, doanh nghiệp vừa đảm bảo tốc độ xử lý cao, vừa duy trì độ tin cậy và an toàn cho toàn bộ hệ thống AI.

Kết nối mạng (Networking)

Đối với AI Server, hệ thống mạng (networking) giữ vai trò quan trọng trong việc truyền tải dữ liệu giữa các thành phần và giữa nhiều máy chủ trong cụm (AI cluster). Kết nối mạng mạnh mẽ giúp tối ưu hiệu năng tổng thể, đặc biệt trong những tác vụ huấn luyện mô hình lớn.

- Single Server: Với các hệ thống đơn lẻ, băng thông 25 - 100GbE là đủ để đảm bảo tốc độ trao đổi dữ liệu giữa CPU, GPU và bộ lưu trữ.

- Multi-node AI Cluster: Khi triển khai các cụm máy chủ AI quy mô lớn (ví dụ cho LLM, GenAI), cần đến 200/400Gbps InfiniBand hoặc Ethernet tốc độ cao. Những card mạng như Mellanox ConnectX-7/8 được ưu tiên nhờ độ trễ thấp, băng thông cực lớn và hỗ trợ RDMA (Remote Direct Memory Access), giúp các GPU trên nhiều server hoạt động gần như đồng bộ.

Một hạ tầng mạng được thiết kế đúng chuẩn không chỉ đảm bảo hiệu năng cao mà còn là điều kiện tiên quyết để xây dựng hệ thống AI phân tán, sẵn sàng cho các workload AI trong tương lai.

Nguồn (PSU)

Trong máy chủ AI, bộ nguồn (PSU - Power Supply Unit) là thành phần then chốt để đảm bảo hệ thống vận hành ổn định. Do các GPU AI tiêu thụ lượng điện năng rất lớn, việc lựa chọn PSU phù hợp có ý nghĩa quyết định đến độ bền và hiệu suất của toàn bộ máy chủ.

- Mức tiêu thụ điện của GPU: Một GPU NVIDIA H100 có thể tiêu thụ tới ~700W. Với cấu hình 8 GPU, tổng công suất cần thiết có thể vượt quá 5kW - chưa kể CPU, RAM, ổ cứng và các thiết bị ngoại vi.

- Công suất PSU cần thiết: Tùy vào số lượng GPU và cấu hình hệ thống, doanh nghiệp cần chuẩn bị nguồn điện từ 3kW đến 12kW. Các PSU cho AI Server thường là loại hiệu suất cao (80 Plus Platinum/Titanium) để giảm hao phí điện năng và đảm bảo ổn định khi tải nặng liên tục.

Lưu ý khi triển khai: Hệ thống nguồn nên có khả năng dự phòng (redundant PSU) để tránh downtime khi một nguồn gặp sự cố. Đồng thời, cần tính toán song song với hệ thống tản nhiệt và hạ tầng điện trong Data Center để đáp ứng an toàn cho tải AI cường độ cao.

Việc lựa chọn PSU không chỉ đơn giản là "đủ công suất", mà còn liên quan đến tính ổn định, an toàn và hiệu suất vận hành lâu dài của toàn bộ máy chủ AI.

Tản nhiệt (Cooling)

Trong máy chủ AI, hệ thống tản nhiệt đóng vai trò sống còn, quyết định sự ổn định và tuổi thọ của phần cứng. Với các GPU hiệu năng cao như H100 hay H200, lượng nhiệt tỏa ra là cực lớn. Nếu không kiểm soát tốt, hệ thống dễ rơi vào tình trạng throttling (giảm hiệu năng để hạ nhiệt), ảnh hưởng trực tiếp đến tốc độ huấn luyện và suy luận mô hình.

- Airflow tối ưu: Thiết kế luồng gió hợp lý bằng các quạt công suất lớn, kết hợp khe thoáng khí khoa học, giúp duy trì nhiệt độ ổn định trong môi trường Data Center. Đây là giải pháp phổ biến, chi phí hợp lý, phù hợp với hầu hết server từ 2–8 GPU.

- Tản nhiệt nước (Liquid Cooling): Với hệ thống nhiều GPU công suất cao (8 - 16 GPU), lượng nhiệt phát sinh có thể vượt quá ngưỡng mà airflow truyền thống xử lý. Khi đó, giải pháp liquid cooling là lựa chọn tối ưu, mang lại hiệu quả làm mát vượt trội, giảm độ ồn và duy trì hiệu năng bền vững trong thời gian dài.

Một hệ thống AI Server chỉ thực sự vận hành ở đỉnh hiệu suất khi đi kèm giải pháp tản nhiệt phù hợp. Doanh nghiệp cần cân nhắc giữa chi phí, quy mô GPU và môi trường triển khai để lựa chọn airflow hay liquid cooling, đảm bảo hạ tầng luôn hoạt động ổn định 24/7.

Kết luận

Xây dựng máy chủ AI hiệu năng cao không chỉ là giải pháp kỹ thuật mà còn là lựa chọn chiến lược giúp doanh nghiệp tối ưu chi phí, làm chủ hạ tầng CNTT và đảm bảo an toàn dữ liệu.

- Nếu nhu cầu chủ yếu là AI inference hoặc training mô hình nhỏ → lựa chọn cấu hình 2-4 GPU (RTX Pro 6000, A100) là đủ.

- Nếu triển khai LLM/GenAI quy mô lớn → cần hệ thống mạnh hơn với 8 GPU H100/H200/B200, RAM 1-2TB, SSD NVMe tốc độ cao.

- Nếu xây dựng cụm AI farm → cần trang bị thêm hạ tầng networking InfiniBand 200/400Gbps để đảm bảo khả năng mở rộng và hiệu năng tối đa.

Tại CNTTShop.vn, chúng tôi luôn sẵn sàng đồng hành cùng bạn:

- Kho hàng lớn, giao ngay với đầy đủ card đồ họa cao cấp NVIDIA: L40, L40S, RTX Pro 6000, A100, H100, H200, B200.

- Máy chủ AI 2U, 4U từ các thương hiệu hàng đầu như Dell, Cisco, Asus, Leadtek, tối ưu cho lắp đặt GPU.

- Linh kiện chính hãng: CPU Intel Xeon, AMD EPYC, RAM DDR5 ECC, SSD/NVMe tốc độ cao (Samsung, Kingston), phụ kiện như NVLink Bridge 2-way, 4-way.

- Chính hãng 100%, Đầy đủ CO/CQ.

Liên hệ CNTTShop.vn ngay hôm nay để được tư vấn cấu hình và báo giá tốt nhất, sẵn sàng cùng bạn xây dựng hạ tầng AI mạnh mẽ, ổn định và tối ưu chi phí dài hạn.

.png)

Bình luận bài viết!