Switch

Switch Wifi - Access Point

Wifi - Access Point Firewall

Firewall Router

Router Module Quang

Module Quang![Module Quang Cisco]() Module Quang Cisco

Module Quang Cisco![Module quang HPE]() Module quang HPE

Module quang HPE![Module quang Maipu]() Module quang Maipu

Module quang Maipu![Module quang Brocade]() Module quang Brocade

Module quang Brocade![Module quang Fortinet]() Module quang Fortinet

Module quang Fortinet![Module quang Aruba]() Module quang Aruba

Module quang Aruba![Module quang OEM]() Module quang OEM

Module quang OEM![Module quang Juniper]() Module quang Juniper

Module quang Juniper![Module quang Dell]() Module quang Dell

Module quang Dell![Module quang Palo Alto]() Module quang Palo Alto

Module quang Palo Alto![Module quang Huawei]() Module quang Huawei

Module quang Huawei![Module quang Arista]() Module quang Arista

Module quang Arista![Module quang F5]() Module quang F5

Module quang F5![Module quang H3C]() Module quang H3C

Module quang H3C![Module Quang Allied Telesis]() Module Quang Allied Telesis

Module Quang Allied Telesis![Module quang SonicWall]() Module quang SonicWall

Module quang SonicWall![Module quang Mikrotik]() Module quang Mikrotik

Module quang Mikrotik![Module quang Handar]() Module quang Handar

Module quang Handar- Module-quang-Finisar

Máy chủ (Server)

Máy chủ (Server)Hãng sản xuất

Chassis

Cấu hình

Máy trạm Workstation

Thiết bị lưu trữ (SAN, NAS)

Thiết bị lưu trữ (SAN, NAS) Load Balancing

Load Balancing Video Conferencing

Video Conferencing Phụ kiện máy chủ

Phụ kiện máy chủ Thiết Bị IoT

Thiết Bị IoT Phụ Kiện Mạng

Phụ Kiện Mạng

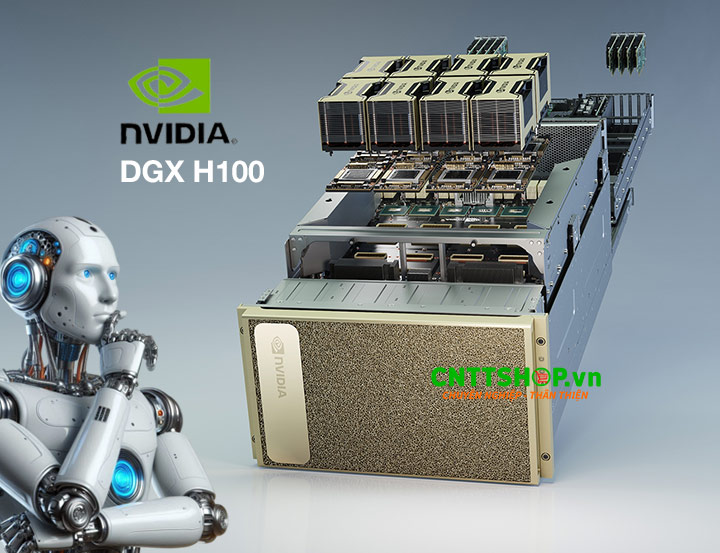

Nvidia DGX H100 - Máy Chủ AI Cao Cấp Tăng Tốc Hiệu Suất AI, HPC

Máy chủ trí tuệ nhân tạo Nvidia DGX H100 có sức mạnh đỉnh cao từ các thành phần cao cấp và công nghệ tiên tiến:

- Kích thươc: Rack 4U, 14.0in x 19.0in x 35.3in (H x W x L).

- GPU: 8x NVIDIA H100 Tensor Core.

- GPU Memory: 640GB HBM3 3 TB/s.

- CPU: 2x Intel® Xeon® Platinum 8480C, (Hỗ trợ CPU Intel và AMD).

- RAM: 2TB.

- 4x Nvidia NVSwitch 4th generation.

- Cổng mạng: 4 port OSFP và 2 cổng QSFP112 (hỗ trợ kết nối 10 card mạng NVIDIA ConnectX-7).

- Lưu trữ hệ điều hành: 2x 1.92TB NVMe M.2.

- Lưu trữ nội bộ: 8x 3.84TB NVMe U.2.

- Nguồn điện: 6x 200-240V AC 3.3 kW.

- Hiệu suất tính toán: 32 triệu tỷ phép tính mỗi giây khi sử dụng định dạng FP8.

- Phần mềm quản lý và tối ưu AI: NVIDIA AI Enterprise, NVIDIA Base Command.

- Hệ điều hành hỗ trợ: DGX OS / Ubuntu / Red Hat Enterprise Linux / Rocky.

BẠN ĐANG QUAN TÂM MÁY CHỦ NÀY?

Hotline: 0866 176 188 - 0968 498 887 Hotline: 0868 397 388 - 0866 851 388Có thể thuê máy chủ này! Vui lòng liên hệ tới chúng tôi để được hỗ trợ tốt nhất.

Hiên nay trí tuệ nhân tạo không còn dừng ở mức nghiên cứu mà được áp dụng phổ biến trong thực tế. AI đã trở thành công cụ quan trọng giúp doanh nghiệp nâng cao hiệu suất và tối ưu hóa quy trình làm việc trong mọi lĩnh vực. Để tận dụng tối đa tiềm năng của AI, việc đẩy nhanh tốc độ nghiên cứu và phát triển mô hình AI cũng như vận hành các ứng dụng AI một cách hiệu quả là yếu tố yêu tiên hàng đầu đối với doanh nghiệp. Điều này đòi hỏi một hạ tầng tính toán mạnh mẽ, có thể xử lý khối lượng dữ liệu khổng lồ với tốc độ tối ưu nhất và độ chính xác cao nhất.

Máy chủ NVIDIA DGX H100 chính là tiêu chuẩn vàng cho hạ tầng AI. Được xây dựng với kiến trúc phần cứng mạnh mẽ, cấu trúc mạng và khả năng kết nối tốc độ cao, khả năng mở rộng từ một máy chủ đơn lẻ tới một hệ thống siêu máy chủ AI. DGX H100 giúp triển khai AI hiệu quả hơn, đào tạo mô hình AI nhanh hơn ở mọi quy mô.

Hãy cùng CNTTShop tìm hiểu chi tiết về máy chủ AI DGX H100 chính hãng NVIDIA tại nội dung sau:

Tổng quan về Nvidia DGX H100

NVIDIA DGX H100 là một dòng máy chủ AI cao cấp do chính hãng NVIDIA thiết kế và sản xuất, được xây dựng với 8 GPU NVIDIA H100 Tensor Core có băng thông 900 GB/giây và bộ nhớ 640GB, kết hợp với 2 CPU Intel Xeon Platinum 8480C 112 Cores trong một kích thước 4U. Nó có sức mạnh tính toán lên đến 32 petaFLOPS FP8, cùng hệ thống kết nối băng thông cao, lý tưởng cho các tác vụ AI, và HPC. DGX H100 cung cấp hiệu suất vô song để đào tạo, triển khai và phục vụ các mô hình AI. Bạn có thể kết hợp 9 máy chủ DGX H100 với nhau để tạo nên một siêu máy chủ xử lý các bộ dữ liệu khổng lồ và các mô hình phức tạp như GPT-4, Llama 3.1, BERT, Stable Diffusion.

DGX H100 áp dụng các công nghệ tiên tiến như NVLink, NVSwitch, kết nội mạng chuẩn InfiniBand hoặc Ethernet và tích hợp phần mềm NVIDIA AI Enterprise, NVIDIA NGC giúp dễ dàng triển khai, quản lý và tối ưu hóa AI. Với sản phẩm tinh hoa công nghệ này bạn có thể có thể tăng tốc các dự án AI của mình, giảm thiểu thời gian huấn luyện và nhanh chóng đạt được kết quả mong muốn, đồng thời đảm bảo hiệu quả tối đa cho các ứng dụng tính toán và các ứng dụng Ai phức tạp.

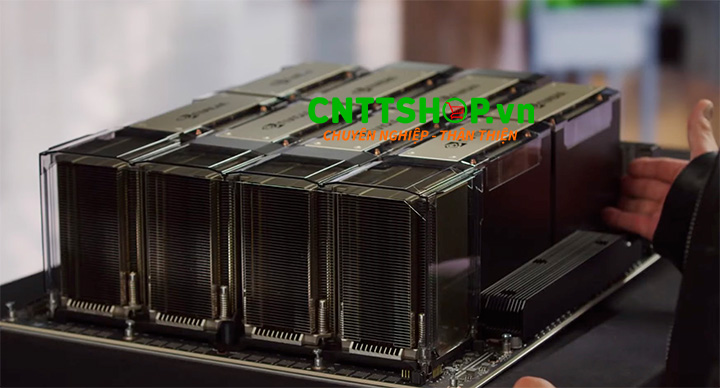

Các thành phần phần cứng tạo nên sức mạnh của DGX H100

GPU - Tăng tốc xử lý AI

NVIDIA DGX H100 được trang bị 8 GPU NVIDIA H100, mang lại hiệu suất vượt trội cho các tác vụ AI và HPC. Mỗi GPU đi kèm với 80GB bộ nhớ HBM3, cung cấp băng thông bộ nhớ lên đến 3TB/giây, giúp xử lý khối lượng dữ liệu khổng lồ với tốc độ tối ưu. Hệ thống đạt hiệu suất tính toán đáng kinh ngạc lên đến 1.000 TFLOPS FP8, đáp ứng yêu cầu của các mô hình trí tuệ nhân tạo tiên tiến nhất. Đặc biệt, mỗi GPU được trang bị 18 cổng NVLink 4.0, khi được kết nối bởi cầu NVLink tạo ra băng thông hai chiều tổng cộng 900GB/giây, giúp giao tiếp giữa các GPU trong cùng một nút diễn ra nhanh chóng và hiệu quả, nâng cao hiệu suất xử lý dữ liệu quy mô lớn.

Bộ xử lý CPU

DGX H100 được trang bị 2 bộ vi xử lý Intel Xeon Platinum 8480C, mỗi CPU sở hữu 56 nhân với xung nhịp tối đa 3,8 GHz, mang lại hiệu suất xử lý mạnh mẽ để đáp ứng các yêu cầu tính toán khắt khe trong AI và HPC. Mỗi CPU còn được tích hợp bộ nhớ đệm L3 dung lượng 256 MB, giúp tăng tốc độ truy xuất dữ liệu và tối ưu hiệu suất tính toán. Ngoài việc hỗ trợ CPU của Intel thiết bị này còn hỗ trợ các CPU cao cấp khác của AMD như AMD EPYC 9004,..vv.

Trong hệ thống DGX H100, CPU đóng vai trò quan trọng trong việc quản lý các tác vụ cấp hệ thống, bao gồm điều phối dữ liệu, xử lý I/O, và tối ưu hóa luồng công việc giữa các GPU. Bằng cách hoạt động như một nhóm tài nguyên chung, CPU đảm bảo rằng tất cả 8 GPU NVIDIA H100 có thể hoạt động đồng bộ, đạt hiệu suất tối đa và giảm thiểu độ trễ trong quá trình tính toán và xử lý dữ liệu.

Bộ nhớ & Lưu trữ trên DGX H100

NVIDIA DGX H100 được trang bị hệ thống bộ nhớ và lưu trữ tối ưu để đáp ứng nhu cầu tính toán AI và HPC quy mô lớn. Mỗi GPU NVIDIA H100 sở hữu 80 GB bộ nhớ HBM3 với băng thông lên đến 3 TB/s (Tổng cộng 8 GPU có 640GB bộ nhớ), giúp xử lý khối lượng dữ liệu khổng lồ trong các mô hình ngôn ngữ lớn.

Hệ thống lưu trữ với 30 TB dung lượng NVMe SSD, bao gồm 8 ổ NVMe U.2 3.84 TB, được sử dụng để lưu trữ toàn bộ mô hình AI. Khi cần thiết, các phần dữ liệu từ NVMe sẽ được luân chuyển vào bộ nhớ GPU HBM3 để phục vụ quá trình tính toán.

Về bộ nhớ RAM của hệ thống, đóng vai trò như một bộ nhớ trung gian tốc độ cao, giúp điều phối việc truyền dữ liệu giữa HBM3 và NVMe để tối ưu hóa hiệu suất xử lý. DGX H100 đi kèm 2 TB RAM DDR5-4800 ECC, cung cấp dung lượng lớn và băng thông cao, giúp đảm bảo tính toàn vẹn dữ liệu và tối ưu hóa hiệu suất trong quá trình huấn luyện AI, mô phỏng và phân tích dữ liệu.

Hệ thống mạng và kết nối trong NVIDIA DGX H100

Máy chủ DGX H100 được trang bị 4 cổng OSF và 2 cổng QSFP112 có thể kết nối với 10 card NVIDIA ConnectX-7 VPI, tùy vào từng loại card sẽ có 1-port hoặc 2-port tốc độ 400 Gb/s, hỗ trợ cả hai giao thức InfiniBand và Ethernet. Điều này cung cấp băng thông cực lớn, giúp tối ưu hóa việc truyền dữ liệu giữa các hệ thống trong các cụm máy chủ AI, đảm bảo hiệu suất tối đa cho các mô hình học sâu và HPC.

Bên trong hệ thống, DGX H100 có thể tích hợp 4 thiết bị NVIDIA NVSwitch, hỗ trợ giao tiếp GPU trong hệ thống với độ trễ cực thấp. Mỗi NVSwitch có thể kết nối lên đến 18 NVLink 4.0, cung cấp băng thông hai chiều tổng cộng 900 GB/s giữa các GPU. Điều này giúp tăng cường khả năng mở rộng, nâng cáo sức mạnh cho toàn bộ hệ thống.

Nguồn cấp điện cho DGX H100

NVIDIA DGX H100 được trang bị 6 bộ nguồn dự phòng 3300W, đảm bảo cung cấp năng lượng liên tục và ổn định ngay cả trong trường hợp một hoặc nhiều bộ nguồn gặp sự cố.

Hệ thống yêu cầu điện áp đầu vào từ 200-240V AC, phù hợp với các trung tâm dữ liệu và cơ sở hạ tầng điện chuyên dụng.

Với mức tiêu thụ điện tối đa lên đến 10.2 kW, DGX H100 được thiết kế để cung cấp hiệu suất tính toán vượt trội, đáp ứng nhu cầu xử lý của các mô hình AI lớn, HPC và điện toán hiệu năng cao.

Các công nghệ kết nối tiên tiến mang tới sức mạnh tối đa cho DGX H100

Để các thành phàn phần cứng cốt lõi bên trong DGX H100 phát huy hết sức mạnh, không thể thiếu được 3 công nghệ kết nối NVLink, NVSwitch và PCIe Bus, giúp tối ưu hóa luồng dữ liệu giữa GPU, CPU và các thiết bị ngoại vi.

- NVLink 4.0 cung cấp băng thông tổng cộng 900 GB/s, đảm bảo giao tiếp tốc độ cao giữa các H100 GPU, giúp xử lý AI hiệu quả hơn.

- NVSwitch hoạt động như một bộ chuyển mạch trung tâm, cho phép bất kỳ GPU nào trong hệ thống có thể giao tiếp với GPU khác khi các tuyến NVLink trực tiếp đã được sử dụng.

- PCIe Gen5 kết nối GPU với CPU, thiết bị lưu trữ NVMe và các ngoại vi khác với băng thông 128 GB/s, đảm bảo hiệu suất truyền tải dữ liệu vượt trội.

Phần mềm và hệ điều hành trên DGX H100

DGX H100 không chỉ là một hệ thống phần cứng mạnh mẽ mà còn được tối ưu hóa với hệ sinh thái phần mềm chuyên dụng, giúp khai thác tối đa sức mạnh của các GPU NVIDIA H100 và tối ưu hóa hiệu suất trong các tác vụ AI, HPC.

Hệ điều hành tối ưu cho AI

DGX H100 hỗ trợ các điều hành tùy chỉnh dựa trên Linux như: DGX OS / Ubuntu / Red Hat Enterprise Linux / Rocky, được tối ưu hóa để hỗ trợ các thư viện, trình điều khiển và công cụ cần thiết cho AI, Deep Learning và HPC.

NVIDIA Base Command

DGX H100 được tích hợp NVIDIA Base Command, nền tảng phần mềm quản lý orchestration và cluster management ở cấp độ doanh nghiệp. Base Command cung cấp:

- Điều phối tài nguyên: Quản lý GPU, CPU, bộ nhớ và lưu trữ để đảm bảo hiệu suất tối ưu.

- Tích hợp với NVIDIA AI Enterprise: Bộ phần mềm AI chuyên dụng giúp đơn giản hóa quá trình phát triển và triển khai AI trong môi trường doanh nghiệp.

NVIDIA AI Enterprise

NVIDIA AI Enterprise là một bộ phần mềm AI đầy đủ, cung cấp môi trường phát triển và triển khai AI chuyên nghiệp, bao gồm:

- Các thư viện tối ưu hóa cho AI như TensorRT, RAPIDS, cuDNN, cuBLAS.

- Hỗ trợ framework AI hàng đầu: TensorFlow, PyTorch, MXNet...

- Khả năng ảo hóa và triển khai container với NVIDIA GPU Cloud (NGC).

NVIDIA DGX H100 có sức mạnh như thế nào?

NVIDIA DGX H100 là một hệ thống AI mạnh mẽ có khả năng xử lý các tác vụ đòi hỏi cao như AI tạo sinh, xử lý ngôn ngữ tự nhiên và các mô hình đề xuất học sâu. Sức mạnh của nó nằm ở khả năng đào tạo các mô hình ngôn ngữ lớn (LLM) đòi hỏi dữ liệu và tài nguyên tính toán khổng lồ nhất hiện nay.

DGX H100 tăng cường khả năng đào tạo LLM nhanh hơn tới 30 lần so với các thế hệ trước (DGX A100), nhờ các tính năng cải tiến của nó. Bao gồm Transformer Engine để nhân ma trận nhanh chóng, NVLink Switch System để chia sẻ dữ liệu liền mạch và cộng tác trên nhiều GPU, và FP8 precision để cải thiện độ chính xác về số với ít bộ nhớ và băng thông sử dụng hơn.

Hơn nữa, DGX H100 có thể đào tạo hiệu quả mô hình ngôn ngữ lớn (LLM) với tối đa 395 tỷ tham số bằng kỹ thuật mixture-of-experts (MoE). Quá trình này chia mô hình thành các mô hình con nhỏ hơn, mỗi mô hình chuyên về các khía cạnh nhiệm vụ khác nhau, đạt được hiệu suất và hiệu quả vượt trội.

So sánh NVIDIA DGX H100 và DGX A100

DGX H100 so với DGX A100 đều được thiết kế cho các khối lượng công việc AI, nhưng chúng dựa trên các kiến trúc khác nhau và đại diện cho các thế hệ cơ sở hạ tầng NVIDIA khác nhau. DGX H100 là thế hệ máy chủ AI mới hơn DGX A100, nó có kiến trúc tối ưu hơn và hiệu suất mạnh mẽ hơn.

- Kiến trúc: Hệ thống DGX H100 được hỗ trợ bởi kiến trúc Hopper (H100) mới hơn, trong khi kiến trúc Ampere (A100) cũ hơn hỗ trợ hệ thống DGX A100.

- Mô hình GPU: Cả hai hệ thống đều chạy 8 GPU NVIDIA Tensor Core, nhưng mỗi hệ thống chạy loại riêng: GPU H100 cho hệ thống DGX H100 và GPU A100 cho hệ thống DGX A100.

- Bộ nhớ GPU: DGX H100 cung cấp 80GB HBM3 cho mỗi GPU so với 40GB hoặc 80GB HBM2e cho mỗi GPU của A100.

- Băng thông bộ nhớ: DGX H100 có 3 TB/giây cho mỗi GPU, so với 2 TB/giây cho mỗi GPU của A100.

- Kết nối GPU: DGX H100 giao tiếp với NVLink 4.0 + NVSwitch băng thông 900 GB/giây, trong khi DGX A100 giao tiếp với NVLink 3.0 + NVSwitch băng thông 600 GB/giây.

- CPU: Hệ thống DGX A100 sử dụng bộ xử lý AMD EPYC 7742 64 lõi, trong khi hệ thống DGX H100 sử dụng 2 bộ xử lý Intel Xeon Platinum.

- Bộ nhớ hệ thống (RAM): Sự khác biệt về RAM giữa DGX H100 và A100 là 2 TB DDR5 so với 1 TB DDR4.

- Tốc độ mạng nhanh hơn gấp 2 lần: Hệ thống DGX H100 cung cấp 8 x 400 Gbps InfiniBand so với 8 x 200 Gbps InfiniBand của A100. Cả hai đều cung cấp Ethernet.

- Lưu trữ nhiều hơn gấp 2 lần: Cũng có sự khác biệt đáng kể về lưu trữ giữa DGX A100 so với H100 (SSD NVMe 15 TB so với SSD NVMe 30 TB).

>>> Xem bài viết so sánh chi tiết giữa DGX H100 và DGX A100 tại đường dẫn sau: https://cnttshop.vn/blogs/tri-tue-nhan-tao-ai/so-sanh-he-thong-may-chu-nvidia-dgx-h100-va-dgx-a100

Các trường hợp sử dụng tốt nhất cho DGX H100

DGX H100 đặc biệt phù hợp với:

- Đào tạo mô hình lớn: Đào tạo các mô hình phức tạp đòi hỏi sức mạnh tính toán mở rộng.

- Suy luận thời gian thực: Phân phối các mô hình ML trong thời gian thực với độ trễ tối thiểu.

- Nghiên cứu AI: Tiến hành nghiên cứu tiên tiến nhằm vượt qua ranh giới của những gì có thể có trong AI.

- Phân Tích Dữ Liệu và AI Doanh Nghiệp: Xử lý dữ liệu lớn (Big Data), phân tích dự đoán và tối ưu hóa kinh doanh. Ứng dụng trong tài chính, bảo hiểm, chuỗi cung ứng với khả năng tính toán nhanh hơn gấp nhiều lần so với hệ thống truyền thống.

- HPC và mô phỏng khoa học: Giải quyết các bài toán vật lý, hóa học lượng tử, khí hậu, mô phỏng động lực học phân tử. Tăng tốc các thuật toán tính toán song song nhờ khả năng xử lý đồng thời của nhiều GPU.

Thông số kỹ thuật chi tiết của DGX H100

| Specification | Details |

|---|---|

| GPU | 8x NVIDIA H100 Tensor Core GPUs |

| GPU Memory | Total 640GB |

| Performance | 32 petaFLOPS FP8 |

| GPU Interconnect | 4x NVIDIA® NVSwitch™ 4th generation |

| Power Consumption | Up to 10.2kW |

| Processor (CPU) | 2x Intel® Xeon® Platinum 8480C |

| CPU Cores | 112 cores total, 2.00 GHz (Base), 3.80 GHz (Max Boost) |

| System Memory (RAM) | 2TB |

| Networking | 4x OSFP ports connecting 8x single-port NVIDIA ConnectX-7 VPI Speed: Up to 400Gb/s InfiniBand/Ethernet 2x dual-port QSFP112 NVIDIA ConnectX-7 VPI Speed: Up to 400Gb/s InfiniBand/Ethernet |

| Management Network | 10Gb/s onboard NIC with RJ45 100Gb/s Ethernet NIC Baseboard Management Controller (BMC) with RJ45 |

| Storage | OS Storage: 2x 1.92TB NVMe M.2 Internal Storage: 8x 3.84TB NVMe U.2 |

| Software | NVIDIA AI Enterprise – Optimized AI software NVIDIA Base Command – Orchestration, scheduling, and cluster management Supported OS: DGX OS / Ubuntu / Red Hat Enterprise Linux / Rocky |

| Support | 3-year business-standard hardware & software support |

| System Weight | 130.45kg (287.6lbs) |

| Packaged Weight | 170.45kg (376lbs) |

| System Dimensions | Height: 356mm (14.0in) Width: 482.2mm (19.0in) Length: 897.1mm (35.3in) |

| Operating Temperature | 5–30°C (41–86°F) |

| Description | NVIDIA DGX H100 – The Gold Standard for AI Infrastructure |

Địa chỉ bán NVIDIA DGX H100 chính hãng, giá tốt, tại Việt Nam

DGX H100 không chỉ dành cho các tổ chức nghiên cứu AI, các nhà máy phát triển AI, các trung tâm dữ liệu cung cấp các dịch vụ AI, mà còn phù hợp với doanh nghiệp muốn tận dụng sức mạnh AI để giải quyết công việc, tăng tốc đổi mới, tối ưu hóa vận hành và đưa ra quyết định thông minh hơn. Nếu bạn muốn sở hữu Siêu Máy Chủ AI NVIDIA DGX H100 vui lòng liên hệ tới CNTTShop để được hỗ trợ tốt nhất.

Chúng tôi cam kết cung cấp sản phẩm chính hãng, giá tốt, đội ngũ chuyên gia chuyên nghiệp, giàu kinh nghiệm có thể hỗ trợ và tư vấn các giải pháp về AI tối ưu nhất cho bạn.

Địa chỉ phân phối máy chủ NVIDIA DGX H100 tại Hà Nội

Công Ty TNHH Công Nghệ Việt Thái Dương - CNTTShop

Địa chỉ: NTT03, Thống Nhất Complex, 82 Nguyễn Tuân, Thanh Xuân, Hà Nội.

Điện Thoại: 0906 051 599

Email: kd@cnttshop.vn

website: cnttshop.vn

Địa chỉ phân phối máy chủ NVIDIA DGX H100 tại TP. Hồ Chí Minh

Công Ty TNHH Công Nghệ Việt Thái Dương - CNTTShop

Địa chỉ: Số 13, đường 7C, khu phố 4, phường An Phú, TP Thủ Đức, Hồ Chí Minh.

Điện Thoại: 0906 051 599

Email: kd@cnttshop.vn

website: cnttshop.vn

.png)

Bạn đang cần tư vấn về sản phẩm: #DGX-H100 ?