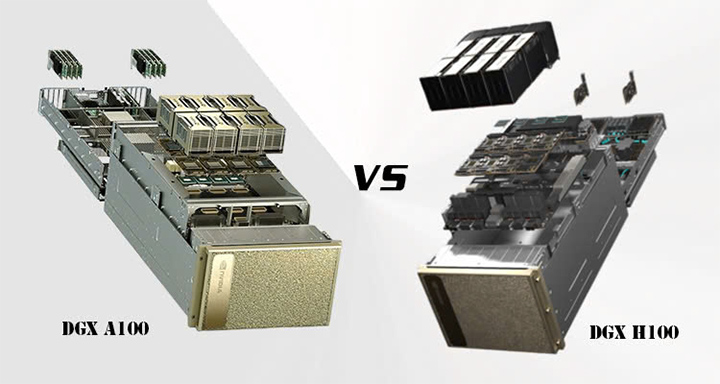

So Sánh Hệ Thống Máy Chủ NVIDIA DGX H100 và DGX A100

Cả hai máy chủ NVIDIA DGX H100 và DGX A100 đều được hãng công nghệ NVIDIA phát triển cho hệ thống AI, nhưng DGX H100 là thế hệ mới hơn, được cải tiến đáng kể so với DGX A100. Chắc chắn DGX A100 sẽ có giá thành thấp hơn DGX H100, nhưng trên DGX H100 sử dụng GPU mạnh mẽ hơn và kiến trúc hiện đại tối ưu hơn. Tuy nhiên để lựa chọn mua máy chủ AI nào phù hợp, còn phải xét đến quy mô phát triển trí tuệ nhân tạo Ai của doanh nghiệp cũng như tổng chi phí đầu tư cho phép.

Sau đây chúng tôi sẽ đưa ra nội dung so sánh chi tiết giữa NVIDIA DGX H100 và NVIDIA DGX A100, đây là cơ sở quan trọng giúp bạn lựa chọn được hệ thống máy chủ AI phù hợp cho cơ sở hạ tầng AI của doanh nghiệp, hay trung tâm dữ liệu AI.

Tổng quan về Máy chủ NVIDIA DGX H100 và DGX A100

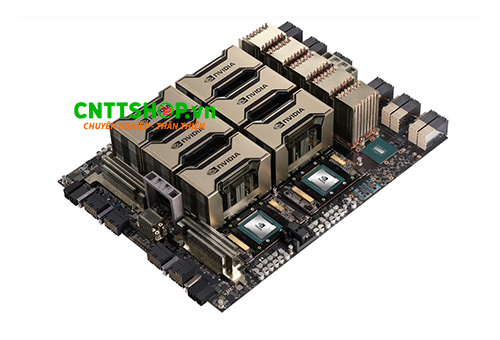

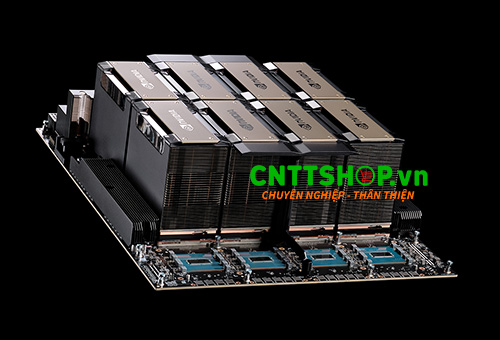

NVIDIA DGX H100 và DGX A100 là hai thế hệ máy chủ AI hàng đầu, được thiết kế để cung cấp hiệu suất tính toán mạnh mẽ cho các ứng dụng trí tuệ nhân tạo (AI), học sâu (Deep Learning), HPC và phân tích dữ liệu quy mô lớn. Cả hai hệ thống đều tích hợp tám GPU NVIDIA hiệu suất cao, cùng với bộ xử lý mạnh mẽ, hệ thống kết nối và lưu trữ tốc độ cao, giúp tối ưu hóa khả năng huấn luyện và suy luận mô hình AI.

DGX H100 là phiên bản nâng cấp mới nhất, sử dụng GPU NVIDIA H100 với kiến trúc Hopper, mang lại hiệu suất vượt trội so với DGX A100, vốn sử dụng GPU NVIDIA A100 dựa trên kiến trúc Ampere. Điểm khác biệt quan trọng giữa hai hệ thống này nằm ở khả năng xử lý dữ liệu, tốc độ bộ nhớ và hiệu suất AI tổng thể. DGX H100 có bộ nhớ HBM3 nhanh hơn, băng thông lớn hơn, và hiệu suất tính toán cao hơn gấp nhiều lần so với thế hệ trước DGX A100 sử dụng bộ nhớ GPU HBM2.

Máy chủ NVIDIA DGX A100 vẫn là một lựa chọn mạnh mẽ, phù hợp với các trung tâm dữ liệu AI yêu cầu tính toán hiệu quả về chi phí và năng lượng. NVIDIA DGX A100 có hai phiên bản là DGX A100 640G và DGX A100 320G giúp doanh nghiệp dễ dàng lựa chọn hệ thống phù hợp với nhu cầu.

Trong khi đó, DGX H100 được tối ưu hóa để đáp ứng nhu cầu của các tổ chức nghiên cứu, doanh nghiệp triển khai mô hình AI quy mô lớn, đặc biệt là các mô hình học sâu phức tạp như LLM (Large Language Models).

Cả hai hệ thống đều hỗ trợ kết nối NVLink, NVSwitch và kết nối mạng infiniband tốc độ cao, khả năng mở rộng linh hoạt và các công cụ phần mềm NVIDIA Command, NVIDIA AI Enterprise giúp đơn giản hóa việc triển khai AI và quản lý hệ thống. Với DGX H100, các doanh nghiệp có thể khai thác tiềm năng và sức mạnh của GPU Hopper để đạt hiệu suất AI cao hơn gấp 3 lần so với DGX A100, mang đến lợi thế vượt trội trong các ứng dụng AI hiện đại.

So sánh về hiệu năng và GPU

DGX H100 được trang bị 8 GPU H100 Tensor Core có kiến trúc Hopper 4nm, chứa tới 80 tỷ bóng bán dẫn, 14.592 lõi CUDA và 456 lõi Tensor thế hệ thứ tư, với 640GB bộ nhớ HBM3 băng thông cao. Trong khi đó, DGX A100 được trang bị 8 GPU A100 Tensor Core với kiến trúc Ampere 7nm chứa 54 tỷ bóng bán dẫn, 6.912 lõi CUDA, 432 lõi Tensor với bộ nhớ HBM2e băng thông thấp hơn.

Đối với các khối lượng công việc AI và Học sâu đặc biệt là với các mô hình ngôn ngữ lớn, DGX H100 tỏa sáng hơn có hiệu suất suy luận tốt hơn tới 30 lần so với DGX A100. Điều này phần lớn là do Transformer Engine của của hệ thống GPU H100, được thiết kế riêng để tăng tốc các loại khối lượng công việc này.

Đối với HPC và tính toán khoa học cả hai hệ thống máy chủ này đều cung cấp khả năng ấn tượng. DGX A100 cung cấp hiệu suất FP64 tuyệt vời, rất quan trọng đối với nhiều ứng dụng khoa học. Tuy nhiên, DGX H100 tiến xa hơn một bước với hiệu suất FP64 được cải thiện đáng kể và giới thiệu độ chính xác FP8 lên tới 32 petaFLOPS, có thể tăng tốc đáng kể một số tác vụ đào tạo và suy luận AI.

Sức mạnh tính toán nâng cao của Nvidia DGX H100 cho phép xử lý các tác vụ tính toán phức tạp hơn và thực hiện các thuật toán lập trình động một cách dễ dàng, đặc biệt phù hợp cho các tác vụ tính toán khoa học và dữ liệu chuyên sâu.

Băng thông và dung lượng bộ nhớ GPU

Máy chủ DGX A100 sử dụng bộ nhớ GPU HBM2 640GB hoặc 320GB với băng thông 2TB/s, tuy nhiên với hệ thống DGX H100 được nâng cấp mạnh hơn với bộ nhớ HBM3 băng thông lên tới 3.35TB/s cho phép xử lý nhanh hơn với các tập dữ liệu lớn và các mô hình phức tạp, đồng thời nâng cao hơn nữa hiệu suất của GPU trong khối lượng công việc AI và HPC.

CPU và bộ nhớ RAM của hệ thống

DGX H100 sử dụng Intel Xeon Platinum 8480C với 112 lõi, trong khi DGX A100 trang bị AMD EPYC 7742 với 128 lõi, cả hai CPU này đều mạnh mẽ cho các công việc AI chuyên sâu nhất. Cả hai hệ thống này đều hỗ trợ bộ nhớ RAM hệ thống tối đa lên tới 2TB, tuy nhiên trên DGX H100 sử dụng RAM DDR5 hiện đại hơn so với RAM DDR4 của DGX A100.

Khả năng lưu trữ

DGX H100 có dung lượng lưu trữ là 30.72TB bằng 8 ổ cứng NVMe U.2, gấp đôi dung lượng lưu trữ của DGX A100 chỉ 15.36TB, giúp tăng cường khả năng xử lý và lưu trưc các mô hình AI có quy mô lớn hơn mà không cần phụ thuộc vào hệ thống lưu trữ bên ngoài nhiều như trước.

Ngoài dung lượng, số lượng khe SSD NVMe nhiều hơn trên DGX H100 cũng giúp tăng băng thông I/O, giảm độ trễ truy xuất dữ liệu, đặc biệt quan trọng trong các tác vụ AI, Machine Learning và HPC cần tốc độ xử lý dữ liệu cực cao.

Khả năng kết nối hệ thống và kết nối mạng

Mỗi GPU trên DGX H100 có 18x kết nối NVIDIA® NVLink® 4.0 cung cấp băng thông 900 GB/s tới các GPU khác, nhanh hơn gấp 1.5 lần so với NVlink trên GPU của DGX A100 sử dụng 12x kết nối NVLink 3.0 băng thông 600 GB/s.

Hệ thông DGX H100 có kiến trúc hiện đại tối ưu hơn với 4 NVSwitch 4.0 có tổng băng thông 7.2 TB/s gấp đôi với hệ thống 6 NVSwitch 3.0 băng thông 3.6 TB/s trên DGX A100. Như vậy DGX H100 có tốc độ kết nối giữa GPU nhanh hơn đáng kể so với DGX A100, giúp tăng hiệu suất xử lý AI và giảm độ trễ khi truyền dữ liệu.

DGX H100 tích hợp card mạng ConnectX-7 tốc độ lên tới 400Gbps hỗ trợ kết nối InfiniBand và Ethernet nhanh hơn gấp đôi so với kết nối mạng trên DGX A100 sử dụng Card mạng ConnectX-6 tốc độ tối đa 200Gbps. Như vậy, hệ thống mạng của DGX H100 nhanh hơn gấp đôi so với DGX A100, giúp tối ưu hiệu suất truyền tải dữ liệu trong các cụm máy tính hiệu năng cao (HPC) và AI workloads, đặc biệt khi sử dụng kết nối InfiniBand để giảm độ trễ và tăng tốc độ giao tiếp giữa các GPU.

Tiêu thụ và hiệu quả năng lượng

Đúng vậy, NVIDIA DGX H100 có công suất tiêu thụ tối đa lên đến 10.2kW, cao hơn đáng kể so với 6.5kW của DGX A100. Điều này chủ yếu đến từ việc GPU H100 tiêu thụ nhiều điện năng hơn so với A100, nhưng bù lại nó mang lại hiệu suất vượt trội trong các tác vụ AI, HPC và Deep Learning.

Cả hai hệ thống DGX H100 và DGX A100 đều được thiết kế để hoạt động với nguồn điện AC 220-240V, phù hợp với tiêu chuẩn trung tâm dữ liệu hiện đại. Do công suất tiêu thụ lớn, việc triển khai DGX H100 cũng đòi hỏi hệ thống làm mát mạnh mẽ hơn, thường là làm mát bằng chất lỏng (liquid cooling) để đảm bảo hiệu suất ổn định và giảm tải nhiệt cho trung tâm dữ liệu.

Bảng so sánh tổng quan giữa DGX H100 và DGX A100

| Thông số | DGX H100 | DGX A100 |

|---|---|---|

| GPU | 8x NVIDIA H100 Tensor Core, kiến trúc Hopper | 8x NVIDIA A100 Tensor Core, kiến trúc Ampere |

| Bộ nhớ GPU | 640GB HBM3 băng thông 3.35TB/s | 640GB / 320GB HBM2 2TB/s |

| Hiệu năng | 32 petaFLOPS FP8 | 5 petaFLOPS AI, 10 petaOPS INT8 |

| CPU | 2x Intel Xeon Platinum 8480C (112 lõi) | 2x AMD EPYC 7742 (128 lõi) |

| Bộ nhớ hệ thống | 2TB DDR5 | 1TB DDR4 |

| Kết nối NVSwitch | 4x NVSwitch 4.0 băng thông 900GB/s | 6x NVSwitch 3.0 băng thông 600GB/s |

| Lưu trữ OS | 2x 1.92TB NVMe M.2 | 1.92TB NVMe M.2 RAID 1 |

| Lưu trữ dữ liệu | 8x 3.84TB NVMe U.2 | 3.84TB NVMe U.2 (Tùy chọn: 7.68TB) |

| Mạng (Cluster) | Card mạng ConnectX-7 400Gb/s (InfiniBand/Ethernet) | Card mạng ConnectX-6 200Gb/s (InfiniBand/Ethernet) |

| Công suất | 10.2kW max | 6.5kW max |

Phần kết luận

NVIDIA DGX H100 và DGX A100 đều là những hệ thống máy chủ AI mạnh mẽ, cung cấp hiệu suất tính toán vượt trội cho các ứng dụng trí tuệ nhân tạo, học sâu và HPC. DGX A100 vẫn là một lựa chọn hiệu quả về chi phí cho các tổ chức có nhu cầu AI vừa và nhỏ, trong khi DGX H100 mang lại khả năng tính toán cao hơn đáng kể với GPU thế hệ mới, băng thông bộ nhớ lớn hơn, hiệu suất FP8 đột phá và hệ thống kết nối tiên tiến.

Việc lựa chọn giữa hai hệ thống này phụ thuộc vào yêu cầu cụ thể của doanh nghiệp, quy mô phát triển AI cũng như ngân sách đầu tư. Nếu doanh nghiệp cần một hệ thống AI tiên tiến nhất để xử lý các mô hình AI phức tạp như LLM hoặc có kế hoạch mở rộng trong tương lai, DGX H100 là lựa chọn lý tưởng. Ngược lại, nếu cần một nền tảng AI mạnh mẽ nhưng vẫn đảm bảo hiệu quả chi phí, DGX A100 vẫn là một lựa chọn đáng cân nhắc.

Dù chọn hệ thống nào, cả DGX H100 và DGX A100 đều mang đến những lợi thế vượt trội, giúp doanh nghiệp khai thác tối đa sức mạnh AI để tối ưu hóa quy trình vận hành và đổi mới sáng tạo. Nếu bạn cần tư vấn về các hệ thống máy chủ AI và giải pháp tôi ưu cho các hệ thống AI, hãy liên hệ tới CNTTShop để được hỗ trợ tốt nhất.

.png)

Bình luận bài viết!