NVIDIA HGX H100 - Nền tảng xây dựng máy chủ AI và điện toán hiệu suất cao

NVIDIA HGX H100 là nền tảng GPU mạnh mẽ được thiết kế để xây dựng cho các máy chủ AI, giúp tăng tốc hiệu suất xử lý các tác vụ điện toán hiệu năng cao (HPC), trí tuệ nhân tạo (AI) và các ứng dụng xử lý dữ liệu phức tạp. HGX H100 không chỉ mang lại hiệu suất tính toán cực cao mà còn tích hợp các công nghệ mạng tiên tiến để giảm độ trễ, tăng cường bảo mật, đồng thời cho phép mở rộng dễ dàng ở quy mô trung tâm dữ liệu.

Trong bài viết này CNTTShop sẽ giới thiệu về NVIDIA HGX H100 từ thiết kế, hiệu suất, các phiên bản HGX 8-GPU H100 và 4-GPU H100 đang góp phần tạo nên các máy chủ GPU đỉnh cao cho nền tảng trung tâm dữ liệu điện toán tăng tốc.

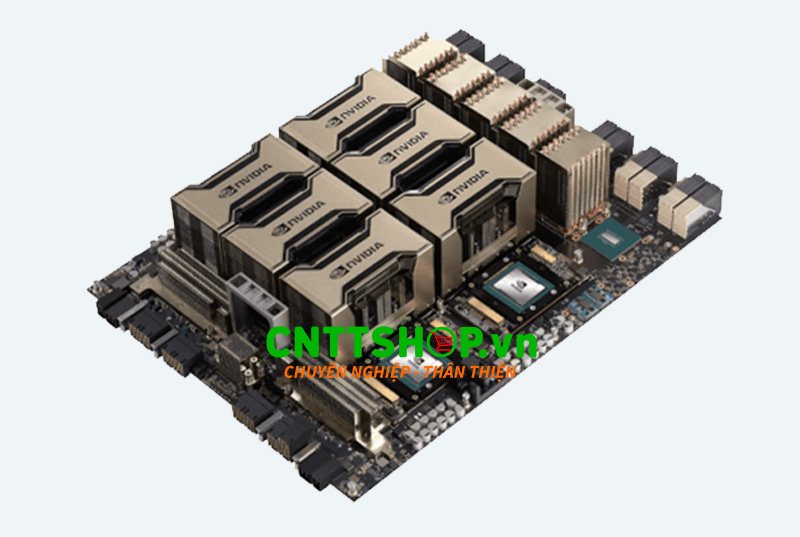

Tổng quan về thiết kế của NVIDIA HGX H100

HGX H100 được xây dựng tạo thành một khối bởi các GPU H100 SXM có kiến trúc Hopper. Các GPU trong nền tảng HGX H100 được kết nối trực tiếp thông qua NVLink 4.0 với băng thông liên kết lên đến 900 GB/s, và được trung tâm điều phối NVSwitch kết nối giao tiếp giữa bất cứ GPU nào với băng thông không chặn lên tới 7.2TB/s.

Bên cạnh đó là bộ nhớ GPU HBM3 cho phép xử lý dữ liệu khổng lồ với độ trễ cực thấp. Tât cả các thành phần GPU, NVLink, NVSwitch, bộ nhớ, đều được tích hợp khoa học trên bo mạch chủ (GPU board) tạo thành một module dễ dàng tích hợp vào các máy chủ từ nhiều nhà cung cấp khác nhau.

Vậy NVIDIA HGX H100 có những model nào, hãy cùng tìm hiểu hai phiên bản 4-GPU và 8-GPU sau:

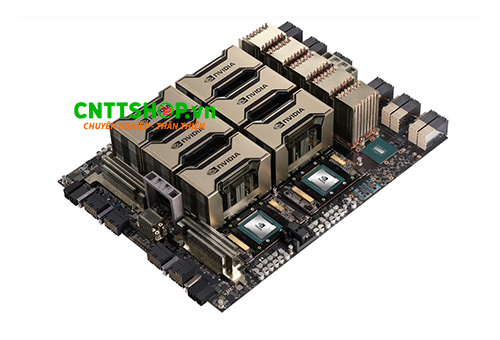

NVIDIA HGX 4 GPU H100

Phiên bản HGX H100 4-GPU là một cấu hình tối ưu hóa cho các môi trường tính toán hiệu năng cao (HPC) với thiết kế kết hợp 4 GPU NVIDIA H100 SXM có bộ nhớ 320GB HBM3. 4 GPU này được kết nối trực tiếp bằng công nghệ NVLink 4.0 với băng thông giữa các GPU đạt 300 GB/s (hai chiều), nhanh hơn khoảng 5 lần so với bus PCIe Gen4 x16 thông thường.

HGX H100 4-GPU có thể được tích hợp trong các hệ thống 1U làm mát bằng chất lỏng để tối đa hóa mật độ GPU trong mỗi rack.

Phiên bản HGX H100 4-GPU có thể kết nối trực tiếp với CPU mà không cần thông qua bộ chuyển mạch PCIe. Đây là một điểm lợi thế giúp giảm chi phí linh kiện và tiết kiệm điện năng nhờ giảm số lượng linh kiện trung gian.

HGX H100 4-GPU có thể kết hợp với các hệ thống máy chủ 2 socket CPU, giúp tăng tỷ lệ CPU/GPU để tối ưu hiệu suất trong các khối lượng công việc yêu cầu sức mạnh xử lý từ CPU. Cấu hình này đặc biệt hiệu quả đối với các ứng dụng cần có cả khả năng xử lý song song của GPU và xử lý logic tuần từ chính xác từ CPU.

| Thông số kỹ thuật | HGX H100 4-GPU |

|---|---|

| Form Factor | 4x NVIDIA H100 SXM |

| FP8 Tensor Core (với sparsity) | 16 PFLOPS |

| INT8 Tensor Core (với sparsity) | 16 POPS |

| FP16/BFLOAT16 Tensor Core (với sparsity) | 8 PFLOPS |

| TF32 Tensor Core | 4 PFLOPS |

| FP32 (Floating Point 32-bit) | 270 TFLOPS |

| FP64 (Floating Point 64-bit) | 140 TFLOPS |

| FP64 Tensor Core | 270 TFLOPS |

| Bộ nhớ GPU | 320GB HBM3 |

| Băng thông tổng GPU | 13GB/s |

| Kết nối NVLink | NVLink 4.0 |

| NVSwitch™ | Không hỗ trợ |

| Băng thông GPU-to-GPU (NVSwitch) | Không hỗ trợ |

| Tổng băng thông tổng hợp | 3.6TB/s |

HGX H100 4-GPU được tích hợp trong một số dòng máy chủ GPU HGX như Supermicro SYS-421GU-TNXR, Supermicro SYS-521GU-TNXR, TensorEX TS4-101818584, .vv

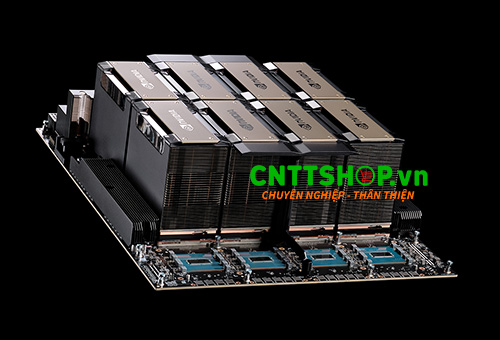

NVIDIA HGX 8 GPU H100

Ngoài phiên bảng 4 GPU, còn có phiên bản 8 GPU mạnh mẽ hơn và hỗ trợ kết nối NVSwitch. NVIDIA H100 8-GPU được trang bị 8 GPU H100 Tensor Core có bộ nhớ 640GB HBM3 được kết nối với 4 NVSwitch 3.0. Mỗi GPU H100 có nhiều cổng NVLink 4.0 và được kết nối với cả bốn NVSwitch với băng thông lên tới 900GB/s, giúp giảm thiểu độ trễ trong các tác vụ tính toán đa GPU phức tạp.

Không dừng ở đó, phiên bản HGX H100 8-GPU tích hợp thêm công nghệ NVLink-Network, giúp mở rộng khả năng kết nối GPU ra ngoài phạm vi một hệ thống máy chủ. Các hệ thống sử dụng HGX H100 8-GPU có thể kết nối với nhau thông qua cáp OSFP LinkX và bộ chuyển mạch NVLink Switch mới. Sự kết hợp này cho phép tạo thành các cụm GPU lớn với tối đa 256 GPU trong một miền NVLink duy nhất.

Thông số kỹ thuật chi tiết của HGX H100 8-GPU

- Form Factor: 8x NVIDIA H100 SXM

- FP8 Tensor Core (với sparsity): 32 PFLOPS

- INT8 Tensor Core (với sparsity): 32 POPS

- FP16/BFLOAT16 Tensor Core (với sparsity): 16 PFLOPS

- TF32 Tensor Core: 8 PFLOPS

- FP32 (Floating Point 32-bit): 540 TFLOPS

- FP64 (Floating Point 64-bit): 270 TFLOPS

- FP64 Tensor Core: 540 TFLOPS

- Bộ nhớ GPU: 640GB HBM3

- Băng thông tổng GPU: 27GB/s

- Kết nối NVLink: NVLink 4.0

- NVSwitch™: Thế hệ thứ 3

- Băng thông GPU-to-GPU (NVSwitch): 900GB/s

- Tổng băng thông tổng hợp: 7.2TB/s

Hiệu suất tính toán mạnh mẽ

HGX H100 8-GPU có hiệu suất tính toán mạnh mẽ Với 32 PFLOPS FP8 Tensor Core và 540 TFLOPS hiệu suất FP32, HGX H100 8-GPU mang lại khả năng tính toán khổng lồ, lý tưởng cho các mô hình học sâu phức tạp, các dự án phân tích dữ liệu lớn và ứng dụng AI thời gian thực.

HGX H100 8-GPU được tích hợp 4 bộ NVSwitch thế hệ thứ 3, hoạt động như các bộ chuyển mạch non-blocking giúp tối ưu khả năng giao tiếp GPU-to-GPU. Công nghệ này cũng hỗ trợ tăng tốc phần cứng cho các thao tác truyền dữ liệu, giúp tăng hiệu quả băng thông lên gấp 3 lần so với thế hệ HGX A100.

Khả năng tích hợp mạnh mẽ vào máy chủ HGX

Với hiệu năng vượt trội và băng thông cao, HGX H100 8-GPU lý tưởng tích hợp vào trong các máy chủ GPU cho các công việc như:

- Đào tạo và suy luận các mô hình AI quy mô lớn.

- Phân tích dữ liệu lớn trong môi trường doanh nghiệp.

- Các ứng dụng nghiên cứu khoa học và kỹ thuật đòi hỏi tính toán chính xác cao.

- Các hệ thống máy chủ phục vụ các dịch vụ đám mây với nhu cầu xử lý dữ liệu đồ sộ.

HGX H100 8-GPU là giải pháp lý tưởng cho các trung tâm dữ liệu, doanh nghiệp và tổ chức nghiên cứu đang tìm kiếm hiệu năng tính toán đột phá. Nó được ứng dụng tích hợp trong một số máy chủ HGX như: Supermicro SYS-821GE-TNHR, Supermicro AS-8125GS-TNHR, ASUS ESC N8-E11V, Dell PowerEdge XE9680, ThinkSystem SR680a V3, Exxact TensorEX TS4-193475697, Exxact TensorEX TS4-117847628,..vv

Các ưu điểm nổi bật của NVIDIA HGX H100

- Kiến trúc NVIDIA Hopper: HGX H100 tích hợp các GPU NVIDIA kiến trúc Hopper mới nhất, được thiết kế riêng để tăng cường khối lượng công việc AI và HPC. Một trong những điểm nổi bật của kiến trúc này là lõi tensor mới đạt hiệu suất đào tạo cao hơn gấp sáu lần so với các phiên bản trước.

- GPU Tensor Core nâng cao: NVIDIA đã giới thiệu nền tảng này bao gồm các GPU Tensor thế hệ thứ 4, tăng gấp đôi hiệu suất cho các ứng dụng đào tạo và suy luận AI. Các lõi Tensor hỗ trợ các độ chính xác khác nhau, bao gồm FP64, TF32, FP16 và INT8, do đó làm cho nó rất linh hoạt cho mọi loại tính toán.

- Băng thông bộ nhớ cao: HGX H100 đi kèm với bộ nhớ băng thông cao (HBM3), cung cấp băng thông bộ nhớ hơn 27GB/s. Với tính năng này, có thể chạy các mô phỏng quy mô lớn cũng như xử lý các tập dữ liệu lớn mà không gặp bất kỳ khó khăn nào.

- Kết nối nâng cao: HGX H100 có tính năng giao tiếp đa GPU cực nhanh được hỗ trợ bởi công nghệ NVIDIA NVLink. Băng thông kết nối này rất quan trọng để mở rộng khối lượng công việc chuyên sâu một cách trơn tru trên nhiều GPU vì NVLink 4.0 cung cấp tới 600 GB/giây.

- Khả năng mở rộng: Nền tảng có khả năng mở rộng cao và hỗ trợ cấu hình đa nút thông qua kết nối NVLink-Network. Do đó, đây là lựa chọn tốt cho việc triển khai mô-đun trong các trung tâm dữ liệu nơi yêu cầu tính toán có thể tăng lên.

- Hiệu quả năng lượng: HGX H100, được phát triển với mô hình tiêu thụ năng lượng được tối ưu hóa, đảm bảo hiệu suất cao trên mỗi watt, khiến đây trở thành lựa chọn thông minh về mặt kinh tế và môi trường cho các phép tính nặng.

Với những ưu điểm này NVIDIA HGX H100 được tích hợp vào các máy chủ GPU thương mại, giúp tăng hiệu suất và hiệu quả trong các ứng dụng AI và HPC, qua đó lập nên kỷ lục mới về khả năng tính toán tăng tốc.

Phần kết luận

Như vậy NVIDIA HGX H100 có 2 phiên bản là HGX H100 8-GPU và HGX H100-4GPU cả hai phiên bản này đều được thiết kế dạng Module dễ dàng tích hợp vào trong các máy chủ khác tuân thủ theo tiêu chuẩn tham chiếu của NVIDIA. Các máy chủ HGX H100 có sức mạnh tính toán mạnh mẽ cho các mô hình AI quy mô lớn và ứng dụng HPC. NVIDIA HGX H100 chính là nền tảng lý tưởng để giải quyết các bài toán phức tạp trong kỷ nguyên trí tuệ nhân tạo và dữ liệu lớn.

Nếu các bạn đang quan tâm tới nền tảng NVIDIA HGX H100 cho máy chủ GPU và các giải pháp tính toán hiệu suất cao (HPC), trí tuệ nhân tạo (AI) hoặc xử lý dữ liệu quy mô lớn, hãy liên hệ ngay với CNTTShop để được tư vấn và hỗ trợ tốt nhất. Đội ngũ kỹ thuật giàu kinh nghiệm tại CNTTShop sẵn sàng giúp bạn lựa chọn giải pháp phù hợp nhất với nhu cầu và đảm bảo hệ thống của bạn hoạt động tối ưu, ổn định và hiệu quả.

.png)

Bình luận bài viết!