NVIDIA HGX H200 - Đỉnh cao hiệu suất cho máy chủ GPU tăng tốc AI/HPC

NVIDIA HGX H200 cung cấp hiệu suất vượt trội với bộ nhớ siêu nhanh, dung lượng cao, đưa các máy chủ GPU AI lên một tầm cao mới. NVIDIA đã hợp tác với nhiều nhà sản xuất máy chủ hàng đầu như Dell Technologies, HPE, Lenovo, Supermicro, ASUS, GIGABYTE.. v.v., để tích hợp nền tảng HGX H200 vào các dòng máy chủ chuyên dụng cho AI và HPC.

Sau đây sẽ là giới thiệu tổng quan về NVIDIA HGX H200 và đánh giá tổng quan sức mạnh cũng như khả năng tích hợp vào các máy chủ GPU. Các bạn cùng theo dõi nhé.

Giới thiệu tổng quan về NVIDIA HGX H200

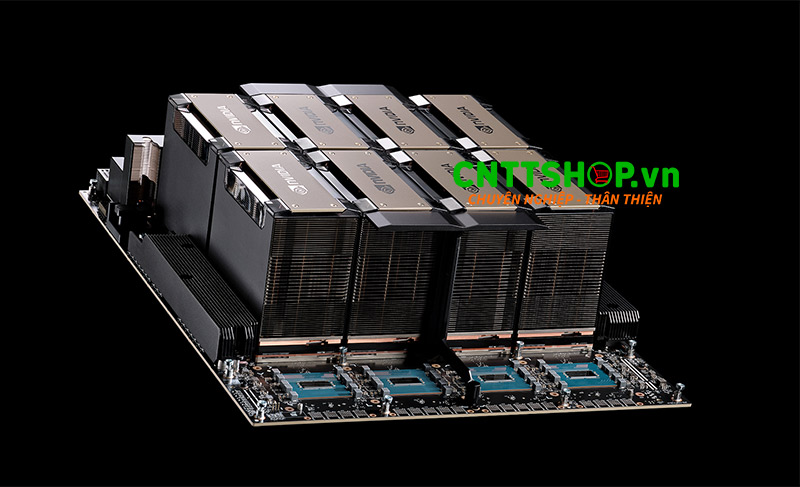

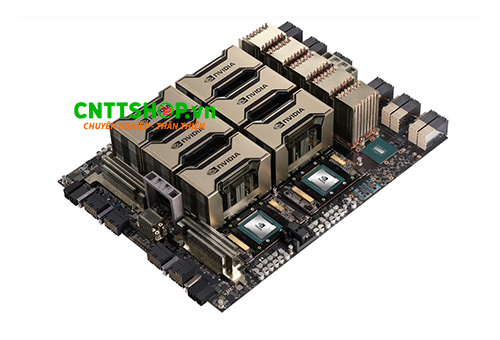

HGX H200 là nền tảng siêu tính toán cao cấp, được xây dựng dựa trên kiến trúc mạnh mẽ của NVIDIA HGX. Hệ thống này tích hợp 4 hoặc 8 GPU H200 SXM, trang bị bộ nhớ HBM3e với băng thông lên tới 4,8 TB/s, mang lại hiệu suất cao hơn 1,4 lần so với thế hệ tiền nhiệm HGX H100.

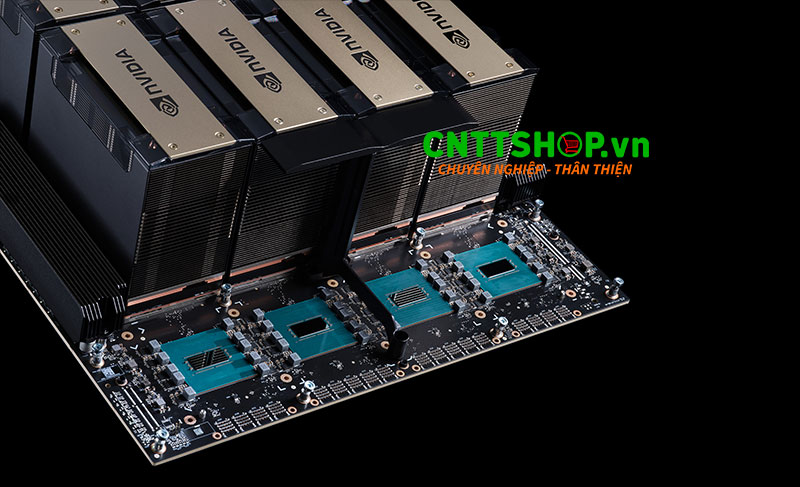

HGX H200 tận dụng tối đa sức mạnh của GPU H200 Tensor Core, kết hợp cùng các công nghệ kết nối tốc độ cao như NVLink 4.0 và NVSwitch 3.0, cho phép giao tiếp giữa các GPU với băng thông cực lớn, giảm thiểu độ trễ và tối ưu hiệu suất trong các tác vụ tính toán phức tạp.

Đặc biệt, khi được triển khai trong các trung tâm dữ liệu AI, việc kết hợp máy chủ HGX H200 với công nghệ mạng tốc độ cao NVIDIA Quantum InfiniBand và nền tảng NVIDIA Spectrum-X tạo nên một hệ sinh thái toàn diện. Sự kết hợp này không chỉ mang lại hiệu suất tính toán vượt trội mà còn cung cấp kết nối mạng băng thông siêu cao lên tới 400Gb/s, đồng thời cho phép mở rộng linh hoạt với nhiều cụm GPU. Nhờ đó, nền tảng này đáp ứng tối ưu các nhu cầu khắt khe của các bài toán AI tạo sinh, mô hình ngôn ngữ lớn (LLM) và điện toán hiệu năng cao (HPC).

Toàn bộ hệ thống HGX H200 được thiết kế theo dạng Module (bo mạch GPU), giúp dễ dàng tích hợp vào các máy chủ hiệu năng cao nhất thế giới, mang lại giải pháp lý tưởng cho các trung tâm dữ liệu AI hiện đại. Sau đây là hai phiên bản của HGX 4-GPU H200 và 8-GPU H200 để lắp đặt vào các máy chủ AI.

NVIDIA HGX H200 8 GPU

NVIDIA HGX H200 8 GPU là giải pháp hàng đầu dành cho các trung tâm dữ liệu AI quy mô lớn, nơi yêu cầu hiệu suất tính toán mạnh mẽ nhất. Hệ thống bao gồm:

- 8 GPU H200 SXM với bộ nhớ HBM3 1,1TB tốc độ cao, cung cấp băng thông tổng cộng lên tới 4,8 TB/s.

- Sử dụng công nghệ kết nối NVLink 4.0 và NVSwitch 3.0, giúp liên kết chặt chẽ các GPU với băng thông nội bộ lên tới 900GB/s.

- Có thể mở rộng với các công nghệ NVIDIA Quantum InfiniBand và nền tảng NVIDIA Spectrum-X.

Bảng thông số kỹ thuật của HGX 8-GPU:

| Đặc điểm | Thông số |

|---|---|

| GPU | 8x NVIDIA H200 SXM |

| Lõi Tensor FP8* | 32 PFLOPS |

| Lõi Tensor INT8* | 32 POPS |

| Lõi Tensor FP16/BF16* | 16 PFLOPS |

| Lõi Tensor TF32* | 8 PFLOPS |

| FP32 | 540 TFLOPS |

| FP64 | 270 TFLOPS |

| Lõi Tensor FP64 | 540 TFLOPS |

| Bộ nhớ | 1,1TB HBM3 |

| Băng thông tổng hợp GPU | 38GB/giây |

| NVLink | 4.0 |

| NVSwitch | 3.0 |

| Băng thông GPU-to-GPU NVSwitch | 900GB/giây |

| Tổng băng thông tổng hợp | 7,2TB/giây |

NVIDIA HGX H200 4GPU

NVIDIA HGX H200 4 GPU phiên bản hiệu suất thấp hơn, chỉ dùng 4 GPU H200 SXM có bộ nhớ 564GB HBM3 được kết nối trực tiếp với nhau bằng NVLink 4.0. Với lựa chọn này sẽ không được hỗ trợ kết nối các GPU thông qua NVSwitch chính vị vậy HGX H200 4-GPU có băng thông kết nối và hiệu suất thấp hơn phiên bảng HGX H200 8-GPU. Hệ thống này bao gồm:

- 4 GPU H200 SXM với bộ nhớ 564GB HBM3, cung cấp băng thông tổng cộng lên tới 4,8 TB/s.

- Hỗ trợ công nghệ kết nối NVLink 4.0, mang lại băng thông nội bộ lên tới 450GB/s giữa các GPU trong hệ thống.

Thông số kỹ thuật của HGX 4-GPU

| Đặc điểm | Thông số |

|---|---|

| GPU | 4x NVIDIA H200 Tensor Core SXM |

| Lõi Tensor FP8* | 16 PFLOPS |

| Lõi Tensor INT8* | 16 POPS |

| Lõi Tensor FP16/BF16* | 8 PFLOPS |

| Lõi Tensor TF32* | 4 PFLOPS |

| FP32 | 270 TFLOPS |

| FP64 | 140 TFLOPS |

| Lõi Tensor FP64 | 270 TFLOPS |

| Bộ nhớ | 564GB HBM3 |

| Băng thông tổng hợp GPU | 19GB/giây |

| NVLink | Thế hệ thứ tư |

| NVSwitch | Không có |

| Băng thông GPU-to-GPU NVSwitch | Không có |

| Tổng băng thông tổng hợp | 3,6TB/giây |

Hiệu suất và khả năng tích hợp vào máy chủ AI

NVIDIA HGX H200 là một trong những giải pháp tối tân dành cho các máy chủ AI nhờ vào khả năng tích hợp linh hoạt trong nhiều hình thức. HGX H200 sẽ được cung cấp dưới dạng bảng mạch GPU từ thương hiệu NVIDIA theo cấu hình bốn hoặc tám GPU, từ đó các hãng máy chủ khác sẽ tích hợp vào các máy chủ AI của họ.

Với NVIDIA NVLink và NVSwitch, HGX H200 đảm bảo hiệu năng vượt trội trong nhiều tình huống khác nhau, bao gồm huấn luyện và inference các mô hình AI lớn hơn 175 tỷ tham số. Cấu hình tám GPU HGX H200 cung cấp hơn 32 petaflops hiệu năng deep learning FP8 và băng thông bộ nhớ lên đến 1.1TB, là lựa chọn tối ưu cho AI tạo sinh và các ứng dụng HPC. Khi kết hợp với CPU NVIDIA Grace và công nghệ kết nối NVLink-C2C, HGX H200 trở thành một phần của bộ vi xử lý NVIDIA GH200 Grace Hopper Superchip với HBM3e, đặc biệt phù hợp cho các khối công việc AI và HPC quy mô lớn.

Ngoài ra, HGX H200 được hỗ trợ bởi bộ phần mềm NVIDIA AI Enterprise, giúp các nhà phát triển và doanh nghiệp dễ dàng xây dựng và tối ưu hóa các ứng dụng AI và HPC. Khi kết hợp công nghệ Medusa, nền tảng NVIDIA HGX H200 với NVLink Switch có thể tăng hiệu suất xử lý mô hình LLaMA 3.1 lên gấp 1.9 lần so với các giải pháp thông thường.

Nhiều nhà cung cấp máy chủ thương mại hàng đầu hiện nay như HPE, Lenovo, Supermicro, ASUS, GIGABYTE, EXXACT,..vv đã tích hợp hệ thống NVIDIA HGX H200 các máy chủ AI mạnh mẽ của họ. Một số ví dụ về các máy chủ HGX H200: Dell PowerEdge XE9680, ASUS ESC N8-E11, Gigabyte G593 Series, Supermicro SYS-821GE-TNHR, Exxact TensorEX TS4-127744315,..vv

Phần kết luận

NVIDIA HGX H200 là giải pháp mạnh mẽ và tối ưu dành cho các hệ thống máy chủ AI, đáp ứng nhu cầu từ các trung tâm dữ liệu AI quy mô lớn cho đến các mô hình hybrid-cloud và edge computing. Với hiệu năng vượt trội và khả năng mở rộng linh hoạt, HGX H200 là sự lựa chọn lý tưởng cho các ứng dụng AI hiện đại.

Nếu các bạn đang quan tâm về giải pháp máy chủ AI, hãy liên hệ ngay tới CNTTShop để được hỗ trợ tốt nhất và chính xác nhất.

.png)

Bình luận bài viết!