NVIDIA HGX A100 - Nền tảng HGX mạnh mẽ đầu tiên cho máy chủ GPU AI

Chúng ta không thể phủ nhận vai trò quan trọng của các máy chủ AI và máy chủ GPU trong thời đại trí tuệ nhân tạo và tính toán hiệu suất cao. Nhằm đáp ứng nhu cầu xử lý dữ liệu khổng lồ và các tác vụ phức tạp, các thương hiệu máy chủ đã không ngừng phát triển các dòng máy chủ tích hợp hệ thống siêu tính toán với nhiều GPU mạnh mẽ, mang lại hiệu suất vượt trội chưa từng có.

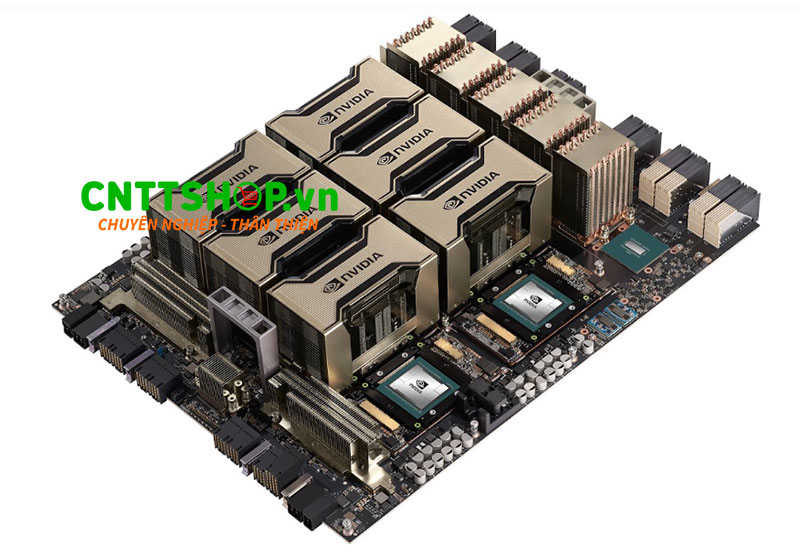

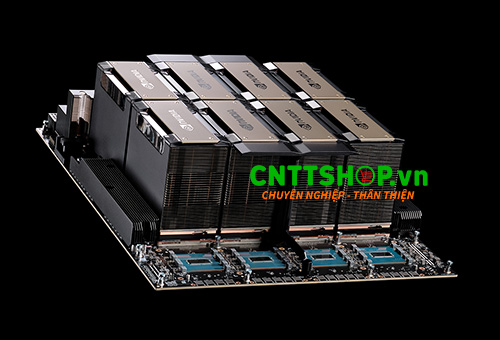

Một trong những giải pháp tiên phong trong lĩnh vực này là HGX A100, hệ thống kết hợp nhiều GPU đầu tiên được xây dựng trên nền tảng NVIDIA HGX tiên tiến của NVIDIA. Hệ thống này được tích hợp vào các máy chủ AI để tăng tốc cho các khối lượng công việc chuyên sâu như mô phỏng khoa học, phân tích dữ liệu và ứng dụng AI phức tạp. Với khả năng tối ưu hóa hiệu suất và mở rộng linh hoạt, HGX A100 đang trở thành lựa chọn hàng đầu để xây dựng các máy chủ AI, giúp doanh nghiệp khai thác tối đa tiềm năng của trí tuệ nhân tạo và khoa học dữ liệu.

Hãy cùng tìm hiểu chi tiết về NVIDIA HGX A100 ngay sau nội dung dưới đây nhé!

Giới thiệu về NVIDIA HGX A100

HGX A100 là một hệ thống siêu tính toán được xây dựng với 4, 8 hoặc 16 GPU A100 SXM dựa trên nền tảng HGX của NVIDIA. Bên cạnh các GPU là hệ thống kết nối NVLink 3.0, tăng gấp đôi băng thông trực tiếp từ GPU đến GPU lên 600 gigabyte mỗi giây (GB/giây), cao hơn gần 10 lần so với PCIe Gen4. Trên HGX A100 cũng hỗ trợ NVSwitch 2.0 kết nối tất cả các GPU với băng thông không chặn tạo nên một hệ thống tính toán khổng lồ duy nhất.

Mỗi hệ thống HGX A100 sử dụng GPU A100 Tensor Core 80G, kết hợp công nghệ NVIDIA NVLink và NVIDIA Mellanox InfiniBand giúp tăng cường khả năng kết nối đa GPU với tốc độ cực cao. Nền tảng đi kèm với bộ công cụ phần mềm NVIDIA NGC, giúp đơn giản hóa việc triển khai các mô hình AI và ứng dụng HPC.

NVIDIA HGX A100 4-GPU

HGX A100 4-GPU là một phiên bản của HGX A100, được xây dựng từ 4 GPU A100 SXM có dung lượng bộ nhớ 320GB được kết nối với nhau bằng NVLink 3.0 băng thông 600GB/s. Với hệ thống này sẽ cung cấp hiệu suất 78 teraFLOPS FP64, 1.25 petaFLOPS TF32, 2.5 petaFLOPS FP16 và 5 petaOPS INT8, lý tưởng cho các bài toán HPC phức tạp đòi hỏi sức mạnh tính toán cao nhất.

Thông số kỹ thuật nổi bật:

- GPU: 4 x NVIDIA A100 Tensor Core GPUs

- Bộ nhớ GPU: HBM2e

- Tổng bộ nhớ GPU: Lên đến 320GB

- NVLink: Kết nối trực tiếp giữa các GPU qua NVlink 3.0, băng thông lên đến 600GB/s.

- Hiệu suất AI và HPC ( FP64/TF32*/FP16*/INT8*): 78 TF/1.25PF*/2.5 PF*/5 POPS*).

NVIDIA HGX A100 8-GPU

HGX A100 8-GPU được xây dựng trên nền tảng HGX A100 với 8 GPU A100 80G kết hợp với NVLink 3.0 và NVSwitch 2.0 tạo nên một module GPU có tổng bộ nhớ 640GB, cung cấp hiệu suất 156 teraFLOPS FP64, 2.5 petaFLOPS TF32, 5 petaFLOPS FP16 và 10 petaOPS INT8, đáp ứng nhu cầu tính toán chuyên sâu trong các bài toán AI và HPC quy mô lớn.

Thông số kỹ thuật nổi bật:

- GPU: 8 x NVIDIA A100 Tensor Core GPUs

- Bộ nhớ GPU: HBM2e

- Tổng bộ nhớ GPU: Lên đến 640GB

- NVLink: Kết nối trực tiếp giữa các GPU qua NVlink 3.0, băng thông lên đến 600GB/s.

- NVSwitch: Kết nối các GPU với nhau qua NVSwitch 2.0 tổng băng thông là 4.8 TB/s.

- Hiệu suất AI và HPC (FP64/TF32*/F): 156 TF/2.5 PF*/5 PF*/10 POPS*.

NVIDIA HGX A100 16-GPU

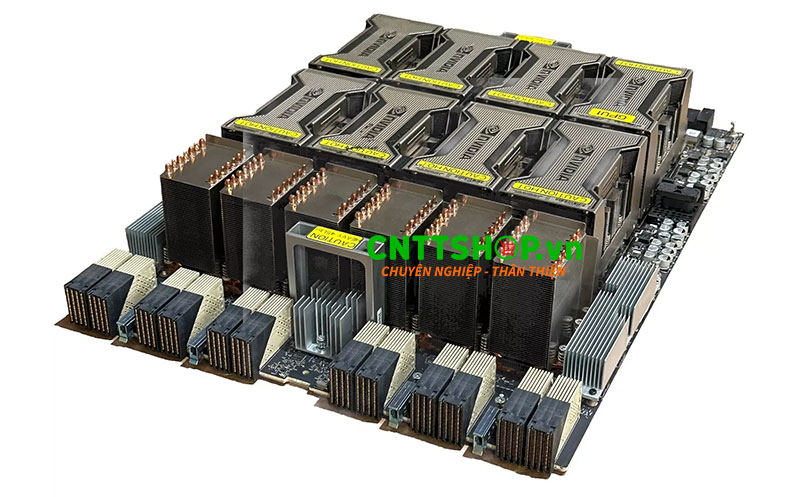

HGX A100 16-GPU là phiên bản cao cấp nhất của NVIDIA HGX A100, nó được thiết kế với 16 GPU A100 Tensor Core có tổng dung lượng bộ nhớ GPU lên tới 1,280 GB và băng thông truyền dữ liệu 9.6 TB/s. HGX A100 8-GPU đem lại tối đa 112 phân vùng GPU độc lập, cung cấp hiệu suất 312 teraFLOPS FP64, 5 petaFLOPS TF32, 10 petaFLOPS FP16 và 20 petaOPS INT8, trở thành nền tảng tăng tốc mạnh mẽ nhất hiện nay cho các ứng dụng AI, HPC và trung tâm dữ liệu hiệu năng cao.

Thông số kỹ thuật nổi bật:

- GPU: 16 x NVIDIA A100 Tensor Core GPUs

- Bộ nhớ GPU: HBM2e

- Tổng bộ nhớ GPU: Lên đến 1,280GB

- NVLink: Kết nối trực tiếp giữa các GPU qua NVlink 3.0, băng thông lên đến 600GB/s.

- NVSwitch: Kết nối các GPU với nhau qua NVSwitch 2.0 tổng băng thông là 9.6 TB/s.

- Hiệu suất AI và HPC (FP64/TF32*/FP16*/INT8*): 312 TF/5 PF*/10 PF*/20 POPS*

Các đặc điểm nổi bật của NVIDIA HGX A100

Nvidia NVLink 3.0

Nvidia NVLink 3.0 trong NVIDIA A100 Tensor Core GPU đưa băng thông giao tiếp GPU-GPU lên đến 600GB/s, nhanh gần 10 lần so với PCIe Gen4.

Nvidia NVLink thứ 3 được tích hợp trong cấu hình GPU A100 giúp HGX A100 hoạt động như một GPU duy nhất với hiệu năng vượt trội.

Nvidia NVSwitch 2.0

NVSwitch được tích hợp với NVLink, tạo nên một hạ tầng kết nối thống nhất, biến cả hệ thống thành một GPU siêu lớn. Giải pháp này giúp HGX A100 tối ưu hoá việc triển khai các mô hình AI và HPC quy mô lớn, đáp ứng các bài toán khoa học phức tạp.

Multi-Instance GPU (MIG)

Tính năng Multi-Instance GPU (MIG) giúp mỗi GPU A100 có thể chia thành 7 phân vùng GPU độc lập, mỗi phân vùng sở hữu bộ nhớ băng thông cao, bộ đệm và lõi xử lý riêng.

GPU Tensor Cores

Các GPU A100 sử dụng trong NVIDIA HGX A100 có kiến trúc Tensor Core thế hệ 3 trong NVIDIA Ampere đưa hiệu năng tăng tốc AI lên đến 20 lần và hiệu năng FP64 HPC lên 2.5 lần.

Băng thông và khả năng mở rộng

HGX A100 hỗ trợ băng thông bộ nhớ đạt 2TB/s kèm khả năng kết hợp NVIDIA Mellanox InfiniBand, phần mềm NVIDIA Magnum IO, GPU-accelerated Spark 3.0 và NVIDIA RAPIDS. Điểm mạnh này giúp tăng tốc xử lý những bài toán phân tích dữ liệu khổng lồ một cách vượt trội, tối ưu hiệu quả sử dụng trung tâm dữ liệu.

Phần kết luận

NVIDIA HGX A100 không chỉ là nền tảng GPU tăng tốc mạnh mẽ nhất hiện nay, mà còn là giải pháp tối ưu cho những bài toán AI, HPC và phân tích dữ liệu quy mô lớn. Với băng thông bộ nhớ và khả năng mở rộng đột phá, HGX A100 sẽ giúp đạt được kết quả vượt trội trong các máy chủ GPU tiên tiến nhất.

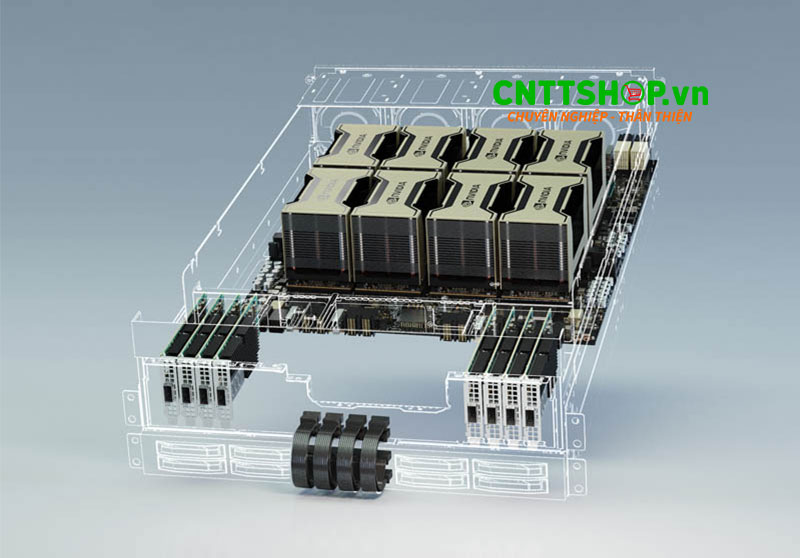

HGX A100 được thiết kế đồng bộ thành một Module dễ dàng tích hợp vào các máy chủ GPU được thiết kế tuân thủ tham chiếu của NVIDIA. NVIDIA đang hợp tác chặt chẽ với các đối tác hệ sinh thái của họ để đưa nền tảng máy chủ HGX A100 vào ứng dụng rộng rãi. Một số máy chủ của các thương hiệu khác tích hợp HGX A100 nổi bật phải kể đến như: Supermicro AS-4124GO-NART, Supermicro AS -2124GQ-NART, ASUS ESC N4A-E11,..vv

Nếu bạn đang quan tâm tới các giải pháp cho AI và HPC cũng như các máy chủ AI có tích hợp hệ thống HGX của NVIDIA, hãy liên hệ tới CNTTShop để được tư vấn chính xác và hỗ trợ tốt nhất

.png)

Bình luận bài viết!