NVIDIA HGX - Nền Tảng Điện Toán AI Hàng Đầu Thế Giới

NVIDIA HGX là một nền tảng siêu tính toán được xây dựng cho AI, HPC và máy chủ trí tuệ nhân tạo hiệu suất cao. NVIDIA HGX được thiết kế trong một module bo mạch tích hợp nhiều GPU như NVIDIA A100, H100, H200 và các thế hệ GPU tiên tiến khác của NVIDIA. Nó cung cấp sức mạnh tuyệt vời với khả năng kết hợp nhiều GPU thông qua công nghệ NVIDIA NVLink và NVSwitch, giúp tăng băng thông và giảm độ trễ trong quá trình truyền dữ liệu và xử lý tính toán.

Tiếp theo trong bài viết này CNTTShop sẽ mang tới nhưng thông tin quan trọng về NVIDIA HGX như: kiến trúc thiết kế, hiệu suất, khả năng tích hợp vào hệ thống máy chủ HGX của các thương hiệu Dell PowerEdge, Supermicro, ASUS, HPE, Gigabye.

Kiến trúc thiết kế và các thành phần của NVIDIA HGX

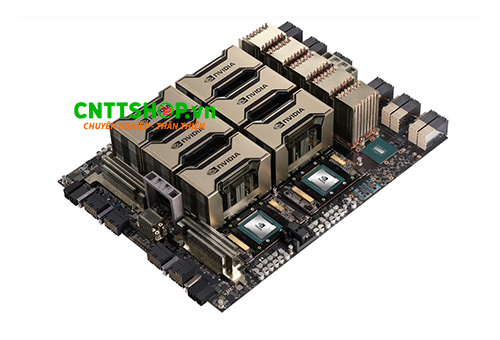

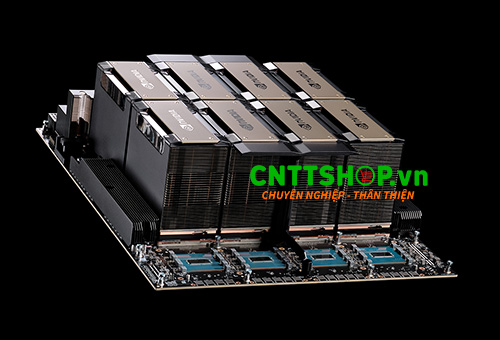

NVIDIA HGX được xây dựng với các thành phần cao cấp và công nghệ tiên tiến tạo nên một kiến trúc bo mạch GPU hiện đại. Các thành phần chính của NVIDIA HGX bao gồm:

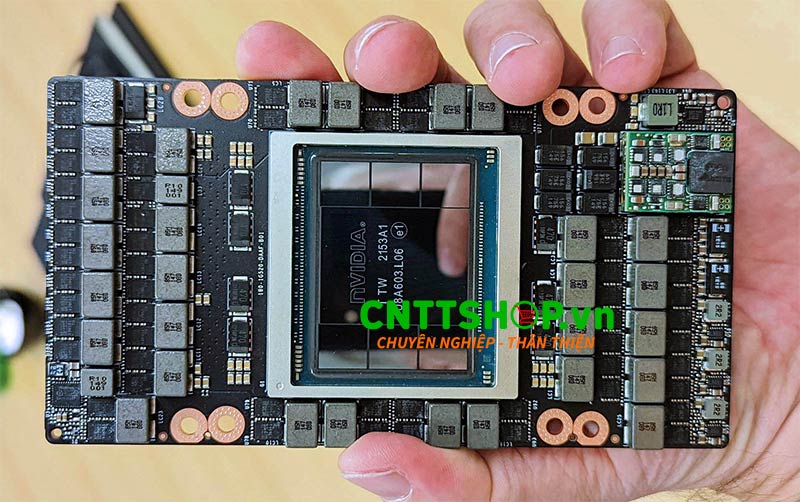

Bo mạch chủ GPU

GPU Board được NVIDIA thiết kế đặc biệt chuyên dụng tích hợp các GPU SXM, tối ưu kết nối và truyền tải dữ liệu. Bo mạch chủ GPU trong hệ thống NVIDIA HGX là nền tảng trung tâm, kết nối các GPU SXM với các thành phần khác trong hệ thống. Bo mạch này tích hợp các kết nối NVLink, NVSwitch, cũng như các giao tiếp dữ liệu tốc độ cao nhằm đảm bảo luồng dữ liệu thông suốt giữa các bộ GPU và các thành phần hệ thống khác.

GPU SXM

Đây là thành phần quan trọng mang tới sức mạng cho hệ thống HGX, GPU SXM là loại GPU có chân cắm đặc biệt SMX thay vì PCIe truyền thống và được gắn trực tiếp lên bo mạch chủ. Trên bo mạch chủ HGX có thể lắp 4 tới 8 GPU SXM H200 hoặc H100 hoặc 8 GPU Blackwell.

NVLink

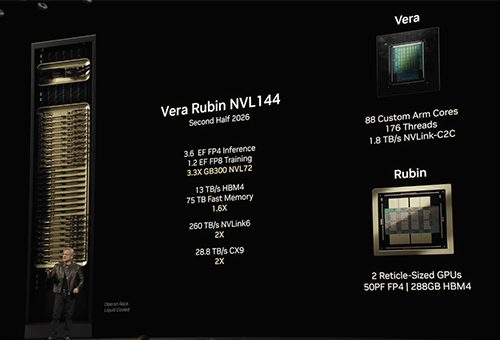

NVLink là công nghệ kết nối tốc độ cao được NVIDIA phát triển để truyền tải dữ liệu trực tiếp giữa các GPU với băng thông cao hơn nhiều so với PCIe. NVLink hỗ trợ băng thông lên tới 1.8TB/s trong các hệ thống HGX, cho phép các GPU giao tiếp hiệu quả trong các mô hình AI lớn và các bài toán tính toán phức tạp.

NVSwitch

NVSwitch là bộ chuyển mạch tốc độ cao, đóng vai trò như trung tâm điều phối kết nối NVLink giữa các GPU trong hệ thống HGX. NVSwitch giúp tạo nên một kiến trúc mạng lưới toàn diện, cho phép các GPU trong cùng một hệ thống giao tiếp với nhau mà không bị giới hạn bởi cấu trúc phân cấp truyền thống.

Bộ nhớ HBM

Trên hệ thống HGX sử dụng loại bộ nhớ HBM, HBM3 và HBM3e là các thế hệ bộ nhớ băng thông cao mới nhất được tích hợp trực tiếp lên GPU. HBM3 mang lại băng thông cao hơn đáng kể so với HBM2e, trong khi HBM3e cải tiến thêm về dung lượng và hiệu năng. Các công nghệ này giúp tối ưu hóa hiệu suất xử lý các mô hình AI phức tạp, mô phỏng khoa học và các ứng dụng đòi hỏi dung lượng bộ nhớ lớn.

Tản nhiệt

Hệ thống NVIDIA HGX sử dụng giải pháp tản nhiệt tiên tiến để đảm bảo các GPU SXM, NVSwitch và các thành phần liên quan hoạt động ổn định dưới tải cao. Các giải pháp tản nhiệt bao gồm cả tản nhiệt khí và tản nhiệt chất lỏng, giúp duy trì hiệu suất tối đa trong thời gian dài mà không làm giảm tuổi thọ thiết bị.

Hiệu suất mạnh mẽ cho AI của NVIDIA HGX

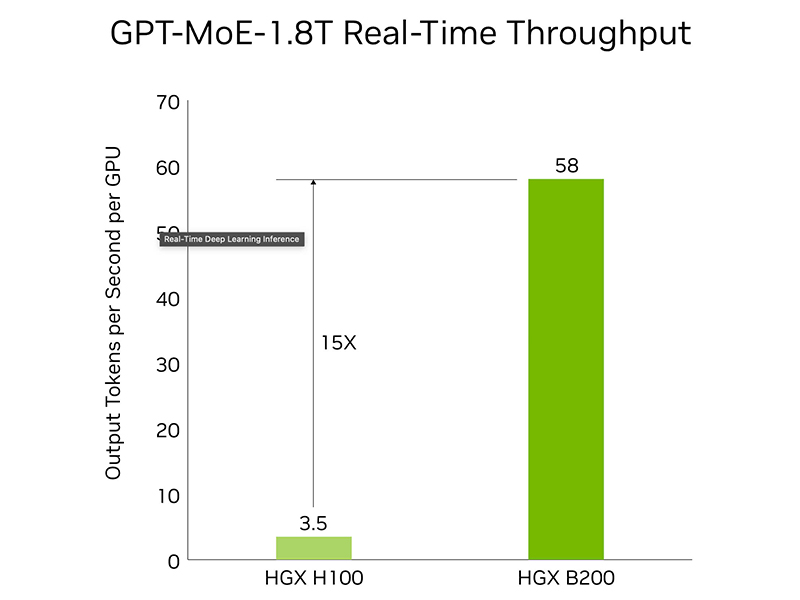

Hiệu suất về suy luận học sâu

Trên NVIDIA HGX kết hợp các GPU Tensor Core hoặc Blackwell Tensor Core và sử dụng công cụ Transformer thế hệ thứ hai, cùng với đó là các nền tảng TensorRT™-LLM và Nemo™ Framework tối ưu hóa chuyên dụng giúp tăng tốc suy luận cho các mô hình AI phức tạp như LLMs và Mixture-of-Experts (MoE).

Trong các bài toán suy luậu thời gian thực, hệ thống HGX mang đến hiệu suất ưu việt nhờ sự kết hợp giữa các GPU thế hệ mới và kỹ thuật tối ưu hóa luồng công việc. Hệ thống HGX có thể đạt hiệu suất suy luận cao hơn tới 15 lần khi xử lý các mô hình ngôn ngữ lớn (LLM) như GPT-MoE-1.8T.

HGX có thể xử lý dữ liệu đầu vào cho đến khi token đầu tiên được tạo ra với độ trễ tối đa chỉ 5 giây, HGX có thể khởi tạo suy luận nhanh chóng ngay cả trong các bài toán phức tạp, yêu cầu mô hình xử lý lượng lớn dữ liệu trước khi tạo ra kết quả.

Trong quá trình tạo ra kết quả độ trễ giữa các token liên tiếp chỉ là 50 mili giây (ms). Điều này cho thấy Nvidia HGX có thể phản hồi gần như tức thời, điều này rất quan trọng trong các ứng dụng đòi hỏi tính tương tác cao như chatbot, dịch thuật hoặc trợ lý ảo.

Nền tảng HGX hỗ trợ độ dài dãy đầu vào (độ dài chuỗi đầu vào) lên đến 32.768 token và đầu ra (độ dài chuỗi kết quả) tối đa 1.028 token, mở rộng khả năng xử lý các mô hình AI quy mô lớn.

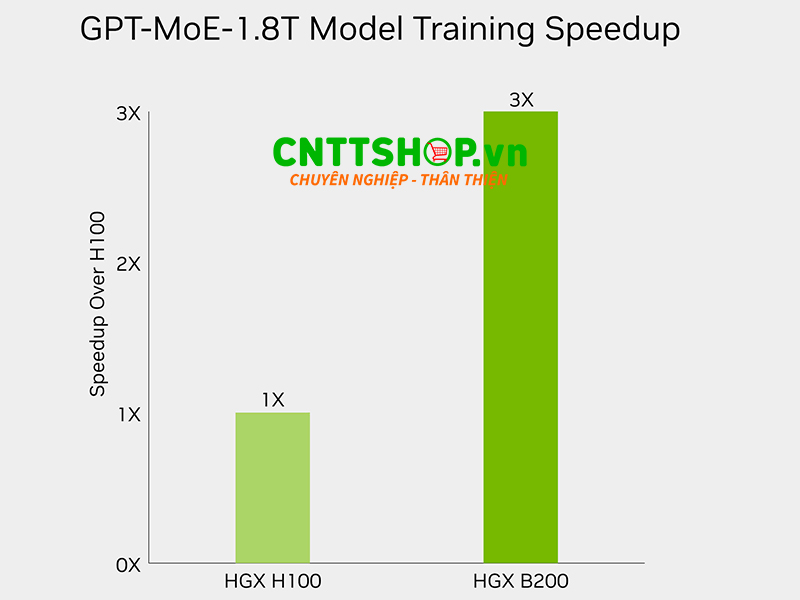

Hiệu suất về đào tạo học sâu

Việc huấn luyện Deep Learning ở quy mô lớn đang được cải tiến mạnh mẽ nhờ những bước tiến trong công nghệ GPU và hạ tầng mạng tốc độ cao. Với quy mô lên đến 32.768 GPU, các cụm máy chủ gồm 4.096 x 8-way HGX H100 và 4.096 x 8-way HGX B200 được kết nối qua mạng 400G InfiniBand mang lại hiệu năng huấn luyện vượt trội, giúp rút ngắn đáng kể thời gian xử lý các mô hình AI phức tạp.

Một trong những cải tiến quan trọng là Transformer Engine thế hệ thứ hai, hỗ trợ độ chính xác FP8 (8-bit floating point) mới. Công nghệ này giúp tăng tốc độ huấn luyện lên gấp 3 lần đối với các mô hình ngôn ngữ lớn như GPT-MoE-1.8T. Sự đổi mới này đặc biệt hữu ích trong việc tối ưu hóa hiệu năng khi xử lý các tập dữ liệu khổng lồ.

Bên cạnh đó, hệ thống còn được trang bị NVLink thế hệ thứ năm với băng thông lên đến 1.8TB/s, giúp tăng tốc độ truyền dữ liệu giữa các GPU, đảm bảo tính ổn định và hiệu quả trong quá trình huấn luyện mô hình. Phần mềm NVIDIA Magnum IO™ cũng được tích hợp nhằm tối ưu hóa luồng dữ liệu, giúp hệ thống mở rộng dễ dàng mà vẫn duy trì hiệu suất cao.

Khả năng tích hợp NVIDIA HGX vào máy chủ HGX

Máy chủ được tích hợp hệ thống HGX của NVIDIA được gọi là Máy chủ HGX, các máy chủ này có thiết kế dạng module tuân thủ kiến trúc tham chiếu của NVIDIA. Hiện nay trên thị trường có nhiều loại máy chủ HGX thương mại được các đối tác như Dell, Supermicro, ASUS, HPE, Gigabye, v.v. sản xuất dựa trên kiến trúc HGX của NVIDIA.

Các nhà sản xuất có thể tùy chỉnh khung máy, hệ thống làm mát, nguồn điện và khay đựng ổ cứng để phù hợp với các nhu cầu khác nhau. Máy chủ HGX của các thương hiệu thường kết hợp công cụ quản lý nội bộ như Dell iDRAC, HPE iLO, hoặc Supermicro IPMI để bổ sung các tính năng điều khiển từ xa và bảo mật. Các máy chủ HGX có thể kết hợp thêm giải pháp mạng như NVIDIA Spectrum-X, NVIDIA Quantum-2, hoặc các tùy chọn mở rộng lưu trữ chuyên biệt, lý tưởng cho việc mở rộng hiệu suất tối đa cho trung tâm dữ liệu AI.

Một minh chứng tiêu biểu cho khả năng mở rộng và hiệu quả của nền tảng này là siêu máy tính AI thế hệ mới mang tên Israel-1. Hệ thống này được xây dựng dựa trên máy chủ Dell PowerEdge XE9680, tích hợp nền tảng NVIDIA HGX 8-GPU, các bộ điều khiển BlueField-3 DPUs và các thiết bị chuyển mạch Spectrum-4 switches, mang lại hiệu suất vượt trội trong các tác vụ AI đòi hỏi quy mô lớn.

Các sản phẩm HGX của NVIDIA

Hiện tại, NVIDIA HGX có nhiều phiên bản khác nhau, bao gồm HGX A100, HGX H100, HGX H200 và HGX B200, mỗi phiên bản đều được tối ưu cho các nhu cầu tính toán chuyên biệt.

NVIDIA HGX A100

- GPU hỗ trợ: NVIDIA A100 (Ampere).

- Tùy chọn cấu hình GPU: HGX A100 4-GPU hoặc HGX A100 8-GPU.

- Kết nối nhiều GPU: NVLink 3.0 với băng thông 600GB/s.

>> Xem chi tiết: https://cnttshop.vn/blogs/tri-tue-nhan-tao-ai/nvidia-hgx-a100-nen-tang-hgx-manh-me-dau-tien-cho-may-chu-gpu-ai

NVIDIA HGX H100

- GPU hỗ trợ: NVIDIA H100 (Hopper)

- Tùy chọn cấu hình GPU: HGX H100 4-GPU hoặc HGX H100 8-GPU.

- Kết nối nhiều GPU: sử dụng NVLink 4.0 băng thông lên tới 900GB/s.

>> Xem chi tiết: https://cnttshop.vn/blogs/tri-tue-nhan-tao-ai/nvidia-hgx-h100-nen-tang-xay-dung-may-chu-ai-va-dien-toan-hieu-suat-cao

NVIDIA HGX H200

- GPU hỗ trợ: NVIDIA H200 (Hopper)

- Tùy chọn cấu hình GPU: HGX H200 4-GPU hoặc HGX H200 8-GPU.

- Kết nối nhiều GPU: Sử dụng NVLink thế hệ thứ 4.0 với băng thông tối đa lên tới 900GB/s giúp tăng tốc giao tiếp dữ liệu giữa các GPU.

>> Xem chi tiết: https://cnttshop.vn/blogs/tri-tue-nhan-tao-ai/nvidia-hgx-h200-dinh-cao-hieu-suat-cho-may-chu-gpu-tang-toc-ai-hpc

NVIDIA HGX B200

- GPU hỗ trợ: NVIDIA B200 (Blackwell - thế hệ tiếp theo của Hopper)

- Tùy chọn cấu hình GPU: HGX B200 4-GPU hoặc HGX B200 8-GPU.

- Kết nối nhiều GPU: NVLink thế hệ thứ 5 với băng thông tối đa 1.8TB/s.

>> Xem chi tiết: https://cnttshop.vn/blogs/tri-tue-nhan-tao-ai/nvidia-hgx-b200-he-thong-tang-toc-tinh-toan-dot-pha-cho-ai-va-hpc

Phần kết luận

NVIDIA HGX đã khẳng định vị thế là nền tảng tính toán hàng đầu trong lĩnh vực AI và HPC, mang lại hiệu suất vượt trội và khả năng mở rộng ấn tượng. Từ phiên bản HGX A100 với hiệu năng ổn định, đến các thế hệ tiên tiến như HGX H100, HGX H200 và HGX B200 với băng thông cao và khả năng xử lý khối lượng dữ liệu khổng lồ, mỗi phiên bản đều được thiết kế để đáp ứng các nhu cầu tính toán ngày càng phức tạp.

Việc lựa chọn Các máy chủ HGX phù hợp sẽ giúp doanh nghiệp tối ưu hiệu suất, cải thiện tốc độ xử lý và nâng cao hiệu quả đầu tư vào hạ tầng CNTT. Trong bối cảnh AI và khoa học dữ liệu tiếp tục phát triển mạnh mẽ, máy chủ HGX chính là giải pháp lý tưởng để hiện thực hóa các bài toán tính toán quy mô lớn với độ chính xác và tốc độ vượt trội.

Nếu bạn đang quan tâm đến các máy chủ tích hợp NVIDIA HGX hoặc muốn tìm hiểu thêm về giải pháp hạ tầng tối ưu cho AI và HPC, hãy liên hệ với CNTTShop để được tư vấn chi tiết và hỗ trợ tốt nhất.

.png)

Bình luận bài viết!