Multi-Instance GPU (MIG) là gì?

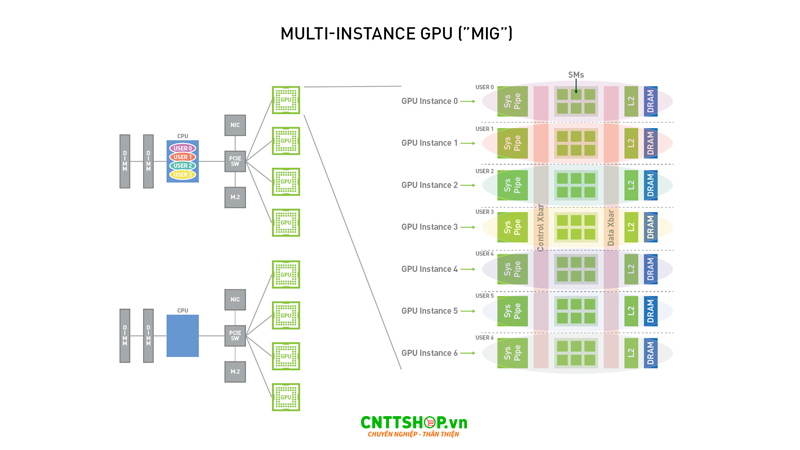

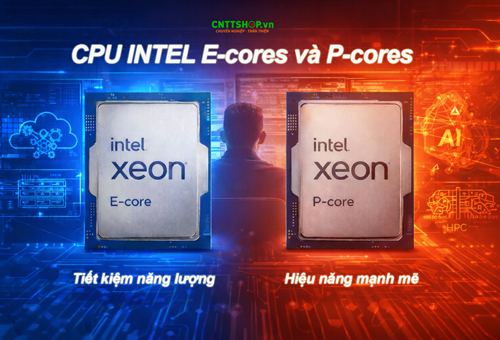

Multi-Instance GPU là một công nghệ tiên tiến của NVIDIA, cho phép phân chia một GPU vật lý thành tối đa 7 GPU ảo độc lập, mỗi GPU ảo sẽ được cấp phát riêng bộ nhớ, bộ nhớ đệm và tài nguyên tính toán băng thông cao. Được giới thiệu từ kiến trúc NVIDIA Ampere và tiếp tục hoàn thiện trên Hopper và Blackwell, MIG cho phép nhiều workload khác nhau vận hành song song trên cùng một GPU mà vẫn đảm bảo tính cô lập và hiệu năng ổn định.

Công nghệ Multil-Instance GPU hoạt động như thế nào?

Nếu không có Multi-Instance GPU, khi chạy nhiều tác vụ khác nhau trên cùng một GPU thì ngay lập tức sẽ xảy ra tình trạng các tác vụ này sẽ cạnh tranh nhau để sử dụng cùng một tài nguyên. Một tác vụ chiếm nhiều băng thông bộ nhớ sẽ gây thiếu hụt tài nguyên cho các tác vụ còn lại, điều này dẫn đến một số tác vụ sẽ bị tăng độ trễ.

Khi MIG được kích hoạt, GPU sẽ được chia toàn bộ tài nguyên phần cứng thành các GPU ảo riêng biệt. Mỗi GPU ảo có bộ nhớ riêng, compute cores riêng, cache L2 và băng thông bộ nhớ được phân tách.

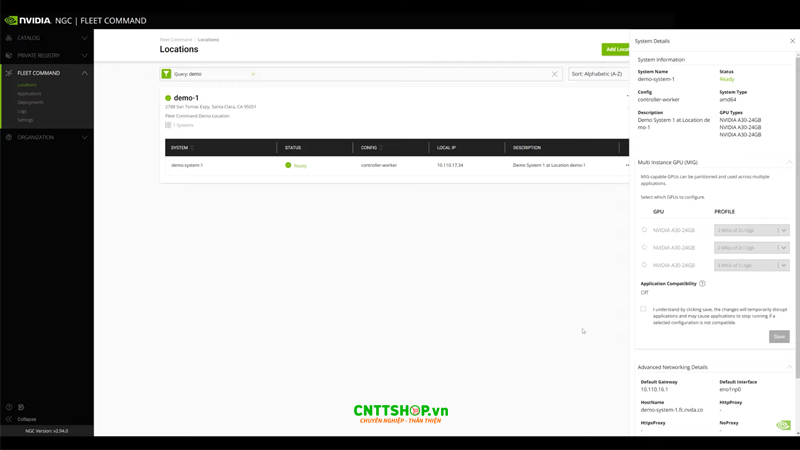

Người dùng có thể tuỳ chọn phân GPU thành nhiều phiên bản MIG khác nhau. Ví dụ, một GPU NVIDIA GB200 có thể được chia thành 2 GPU ảo với 95GB bộ nhớ mỗi GPU, 4 GPU ảo với 45GB bộ nhớ mỗi GPU hoặc 7 GPU ảo với 23GB bộ nhớ mỗi GPU. Các phiên bản MIG này có thể được cấu hình chạy linh hoạt, doanh nghiệp có thể sử dụng cấu hình 7 GPU ảo với bộ nhớ ít để suy luận thông lượng thấp vào ban ngày và sử dụng 2 GPU ảo bộ nhớ cao để huấn luyện học sâu vào ban đêm.

MIG cho phép người dùng xem và lên lịch cho các tác vụ trên GPU ảo như thể chúng là GPU vật lý. Công nghệ này hỗ trợ hệ điều hành Linux, chạy các workload dạng container bằng Docker Engine, điều phối công việc bằng Kubernetes, hoạt động trong các môi trường ảo hoá thông qua các hypervisor như Red Hat Vitualization và VMware vSphere.

Với các cơ chế này, nhiều workload khác nhau có thể hoạt động song song trên một GPU một cách độc lập và ổn định, không ảnh hưởng đến hiệu suất, độ trễ của nhau.

Những lợi ích khi sử dụng Multi-Instance GPU

Mở rộng khả năng truy cập và chia sẻ GPU hiệu quả

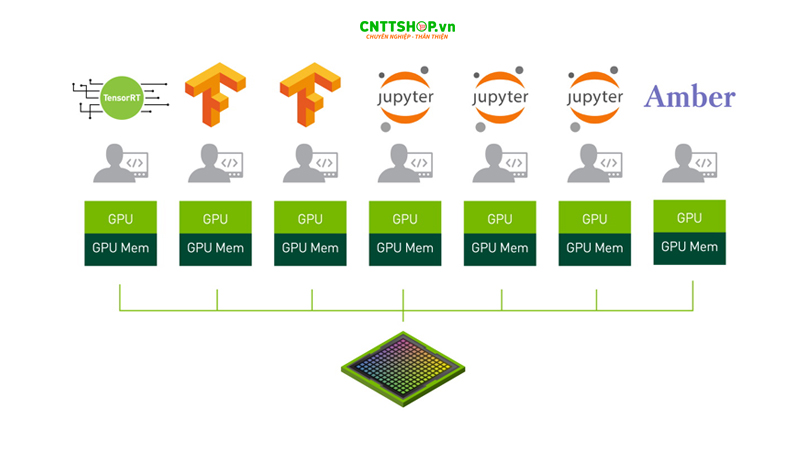

MIG mở ra khả năng cho phép nhiều người dùng hoặc nhiều ứng dụng có thể truy cập vào GPU cùng lúc. Thay vì một workload chiếm trọn GPU và các workload còn lại phải chờ đến lượt, MIG tạo nên điều kiện để phân bổ tài nguyên hợp lý song song cho nhiều tác vụ khác nhau. Điều này đặc biệt hữu ích cho các môi trường nghiên cứu, AI platform dùng chung hoặc trung tâm dữ liệu có nhiều nhóm phát triển đều cần khai thác GPU.

Tối ưu hoá mức sử dụng tài nguyên

Không phải workload nào cũng cần đến sức mạnh của toàn bộ GPU. MIG cho phép phân chia tài nguyên với quy mô phù hợp cho từng tác vụ cụ thể như Inference, training hoặc HPC…..Việc phân bổ tài nguyên GPU với đúng nhu cầu của workload giúp tránh lãng phí tài nguyên, tối đa hoá hiệu quả đầu tư hạ tầng GPU trong dài hạn.

Chạy đồng thời nhiều workload với hiệu năng ổn định

MIG giúp nhiều loại tác vụ như suy luận AI, huấn luyện mô hình và các bài toán HPC có thể vận hành đồng thời trên cùng một GPU, với độ trễ và thông lượng được kiểm soát rõ ràng. Thay vì phải luân phiên chia thời gian xử lý như cơ chế time slicing, các workload được thực thi song song, từ đó cải thiện đáng kể hiệu năng tổng thể của hệ thống.

Những GPU NIVIDIA được hỗ trợ Multi-Instance GPU

Để có được kế hoạch đầu tư GPU phù hợp với các workload thực tế, bạn cần nắm rõ được những GPU nào đang được tích hợp công nghệ hiện đại MIG. CNTTShop đã tổng hợp thông tin của các GPU NVIDIA được trang bị MIG trong bảng dưới đây để các bạn dễ theo dõi.

| Product | Architecture | Microarchitecture | Compute Capability | Memory Size | Max Number of Instances |

|---|---|---|---|---|---|

| RTX PRO 6000 Server Edition | Blackwell | GB202 | 12.0 | 96GB | 4 |

| RTX PRO 6000 Workstation Edition | Blackwell | GB202 | 12.0 | 96GB | 4 |

| RTX PRO 6000 Blackwell Max-Q Workstation Edition | Blackwell | GB202 | 12.0 | 96GB | 4 |

| RTX PRO 5000 Blackwell | Blackwell | GB202 | 12.0 | 48GB | 2 |

| GB200 | Blackwell | GB100 | 10.0 | 186GB | 7 |

| B200 | Blackwell | GB100 | 10.0 | 180GB | 7 |

| H100-SXM5 | Hopper | GH100 | 9.0 | 80GB | 7 |

| H100-PCIE | Hopper | GH100 | 9.0 | 80GB | 7 |

| H100-SXM5 | Hopper | GH100 | 9.0 | 94GB | 7 |

| H100-PCIE | Hopper | GH100 | 9.0 | 94GB | 7 |

| H100 on GH200 | Hopper | GH100 | 9.0 | 96GB | 7 |

| H200 | Hopper | GH100 | 9.0 | 96GB | 7 |

| H200-SXM5 | Hopper | GH100 | 9.0 | 141GB | 7 |

| H200 NVL | Hopper | GH100 | 9.0 | 141GB | 7 |

| A100-SXM4 | NVIDIA Ampere architecture | GA100 | 8.0 | 40GB | 7 |

| A100-SXM4 | NVIDIA Ampere architecture | GA100 | 8.0 | 80GB | 7 |

| A100-PCIE | NVIDIA Ampere architecture | GA100 | 8.0 | 40GB | 7 |

| A100-PCIE | NVIDIA Ampere architecture | GA100 | 8.0 | 80GB | 7 |

| A30 | NVIDIA Ampere architecture | GA100 | 8.0 | 24GB | 4 |

Ngoài các GPU trong bảng trên, MIG còn được tích hợp sẵn trong các hệ thống sử dụng những GPU này như DGX, DGX Station và HGX.

Bạn cũng có thể xem thêm các GPU NVIDIA mạnh mẽ cho workstation, server và server AI.

Kết Luận

Multi-Instance GPU cho thấy cách NVIDIA tiếp cận bài toán khai thác GPU hiệu quả hơn trong các môi trường AI, HPC và cloud hiện đại, nơi yêu cầu vừa tối ưu tài nguyên, vừa đảm bảo tính cô lập và hiệu năng ổn định cho từng workload. Thay vì chia sẻ GPU theo cơ chế time-slicing truyền thống, MIG mang lại khả năng phân vùng phần cứng thực sự, giúp hạ tầng đa người dùng vận hành hiệu quả và dễ kiểm soát hơn.

Trong bối cảnh các GPU NVIDIA thế hệ mới đang ngày càng được triển khai rộng rãi cho AI và tính toán hiệu năng cao, việc hiểu và áp dụng MIG hợp lý sẽ là lợi thế quan trọng. CNTTShop hiện đang phân phối các sản phẩm GPU NVIDIA mới nhất với số lượng stock lớn, cùng với đó là những tư vấn chuyên sâu về lựa chọn cấu hình và kịch bản triển khai phù hợp, giúp doanh nghiệp khai thác hiệu quả tài nguyên GPU và xây dựng hệ thống ổn định, dễ mở rộng trong thực tế.

.png)

Bình luận bài viết!