So sánh Ethernet và Infiniband: Đâu là xu hướng trong thời đại AI?

Trong những năm gần đây, với sự phát triển mạnh mẽ của điện toán đám mấy, dữ liệu lớn và Trí tuệ nhân tạo (AI), các trung tâm dữ liệu đã mở rộng nhanh chóng cả về quy mô và số lượng. Đặc biệt sự bùng nổ của AI đang đặt ra những thách thức chưa từng có về nhu cầu xử lý dữ liệu và truyền tải thông tin. Để đáp ứng những yêu cầu khắt khe này, các giải pháp kết nối hiệu suất cao trở nên vô cùng quan trọng. Ethernet và Infiniband là hai công nghệ mạng nổi bật, mỗi loại có những đặc điểm riêng biệt phù hợp với các yêu cầu khác nhau và đang cạnh tranh để trở thành xương sống cho hạ tầng AI. Vậy, giữa Ethernet và Infiniband, đâu mới thực sự là lựa chọn tối ưu và đâu là xu hướng tất yếu trong thời đại mới? Trong bài viết này hãy cùng CNTTShop đưa ra cái nhìn toàn diện về sự so sánh giữa hai công nghệ này nhé.

Tổng quan về Ethernet và Infiniband

Ngày nay hầu như tất cả hệ thống mạng máy tính từ mạng LAN cho đến mạng WAN đều sử dụng công nghệ Ethernet để kết nối các thiết bị với nhau. Ra đời từ đầu những năm 1970, Ethernet định nghĩa các lớp vật lý và liên kết dữ liệu của mô hình OSI, hoạt động dựa trên giao thức IEEE 802.3 và sử dụng cáp đồng (UTP, STP) hoặc cáp quang để truyền dữ liệu. Ethernet cung cấp tính linh hoạt, khả năng mở rộng và dễ sử dụng, khiến nó trở thành lựa chọn phổ biến cho nhiều ứng dụng khác nhau, bao gồm mạng gia đình, doanh nghiệp hay cả trung tâm dữ liệu.

InfiniBand (IB) là một giao thức kết nối tốc độ cao, được sử dụng chủ yếu trong trung tâm dữ liệu (Data Center), siêu máy tính (HPC - High-Performance Computing), và AI. Ra đời sau từ những năm 2000, nó cung cấp băng thông cực cao (có thể lên đến 1,6Tbps), độ trễ thấp hơn nhiều so với Ethernet và PCIe, giúp cải thiện hiệu suất tính toán và truyền dữ liệu.

Không giống như Ethernet, InfiniBand áp dụng các công nghệ giúp giảm tải cho CPU bằng RDMA (Remote Direct Memory Access) hay Lossless Fabric giúp truyền dữ liệu mượt mà, không mất gói mà không cần CPU tham gia. Infiniband đảm bảo hiệu suất tối đa cho các tác vụ AI chạy song song trên hàng nghìn GPU. Điều này giúp tối ưu hóa luồng dữ liệu phức tạp, loại bỏ tắc nghẽn và giữ cho hệ thống hoạt động mượt mà ngay cả khi xử lý khối lượng tác vụ khổng lồ.

So sánh công nghệ Ethernet và Infiniband

Kiến trúc

Ethernet hoạt động ở lớp Vật lý và liên kết dữ liệu trong mô hình OSI hay lớp Truy cập mạng trong mô hình TCP/IP. Lớp vật lý chủ yếu tập trung vào các thành phần phần cứng như cổng NIC, cáp mạng, chịu trách nhiệm về cách dữ liệu được truyền trên môi trường vật lý. Trong khi Lớp Liên Kết Dữ Liệu chịu trách nhiệm định dạng, đóng gói, địa chỉ hóa và kiểm soát lỗi của dữ liệu truyền trên mạng. Vì sử dụng địa chỉ MAC để truyền dữ liệu giữa các thiết bị nên tiêu đề khung Ethernet bao gồm cả địa chỉ MAC Nguồn & Đích, sau đó là tải trọng của khung. Mạng Ethernet cũng sử dụng cơ chế chuyển mạch Store-and-forward, tức là switch sẽ nhận toàn bộ gói dữ liệu hoặc khung dữ liệu vào bộ nhớ đệm của nó trước khi thực hiện bất kỳ hành động chuyển tiếp nào

Trong TCP/IP truyền thống, dữ liệu từ card mạng trước tiên được sao chép vào bộ nhớ RAM và sau đó được sao chép tiếp vào không gian lưu trữ của ứng dụng. Tương tự như vậy, dữ liệu từ không gian ứng dụng được sao chép vào bộ nhớ RAM trước khi được gửi ra ngoài qua card mạng đến thiết bị khác. CPU phải xử lý từng bước như sao chép dữ liệu vào bộ nhớ đệm (buffer), xử lý giao thức mạng, kiểm tra lỗi, rồi mới gửi đi. Hoạt động I/O này yêu cầu sao chép trung gian trong RAM, làm tăng độ dài đường dẫn truyền dữ liệu, tăng gánh nặng cho CPU và gây ra độ trễ truyền tải.

Trong khi Infiniband có kiến trúc mạng song song (fabric) dựa trên kênh, không dựa trên mô hình TCP/IP. Nó sử dụng công nghệ RDMA cho phép truyền dữ liệu trực tiếp giữa bộ nhớ RAM của hai máy tính mà không cần CPU can thiệp quá nhiều, giúp giảm tối đa độ trễ xuống còn đơn vị ns. InfiniBand cũng sử dụng cơ chế chuyển mạch Cut-through cho phép switch bắt đầu chuyển tiếp gói tin ngay khi nó nhận đủ thông tin về địa chỉ đích, thường là ngay sau khi header của gói tin đến, giúp giảm thiểu đáng kể độ trễ end-to-end. Các thành phần của Infiniband được chia thành 4 loại:

- HCA (Bộ điều hợp kênh chủ): là một module card có vai trò kết nối vật lý máy chủ với mạng Infiniband, tương tự như card NIC của Ethernet hay card HBA trong SAN nhưng được thiết kế với RDMA

- TCA (Bộ chuyển đổi kênh mục tiêu): tương tự như HCA nhưng được dùng để kết nối các thiết bị ngoại vi như hệ thống lưu trữ, ổ cứng, thiết bị mạng với mạng Infiniband. Nó giúp kết nối hệ thống máy chủ với các thiết bị lưu trữ NVMe hoặc SSD trong môi trường Data Center hoặc trong AI/ML, TCA giúp kết nối GPU với cụm máy tính để huấn luyện mô hình nhanh hơn.

- InfiniBand Switch (Bộ chuyển mạch InfiniBand): Khác với switch Ethernet thông thường, InfiniBand Switch hoạt động theo kiến trúc switched fabric, không phải mô hình bus truyền thống. Điều này giúp đa luồng dữ liệu có thể truyền đồng thời mà không bị tắc nghẽn. Nó giúp các máy chủ, thiết bị lưu trữ (NVMe), GPU kết nối với nhau qua mạng InfiniBand. Đặc biệt, InfiniBand Switch có thể hỗ trợ tốc độ từ 40 - 800 Gbps, vượt xa các chuẩn Ethernet thông thường.

- InfiniBand Link (liên kết InfiniBand): là kết nối vật lý giữa hai thiết bị trong mạng InfiniBand. Các loại cáp được sử dụng có thể là cáp đồng (DAC), cáp quang (AOC) hoặc thậm chí là liên kết trên bo mạch. InfiniBand Link có nhiều cấp độ tốc độ khác nhau, được xác định bởi số làn truyền dữ liệu (Lanes): 1X, 4X, 8X, 12X

Trong mạng InfiniBand, dữ liệu cũng được truyền dưới dạng gói tin với kích thước tối đa là 4KB và sử dụng phương pháp tuần tự

Nhìn chung, kiến trúc của InfiniBand được tối ưu hóa cho hiệu suất cao nhất trong các môi trường điện toán chuyên dụng, trong khi kiến trúc của Ethernet mang lại sự linh hoạt, khả năng tương thích rộng rãi và chi phí dễ tiếp cận hơn cho nhiều mục đích sử dụng mạng khác nhau.

Hiệu suất

Từ chuẩn Ethernet đầu tiên được áp dụng (10BASE-T) với băng thông chỉ 10Mbps, cho đến tiêu chuẩn hiện đại nhất bây giờ có thể đạt 800Gbps (800GBASE-R), công nghệ Ethernet đã liên tục được cải tiến để đáp ứng được nhiều ứng dụng mạng hiện đại ngày nay. Trong những năm gần đây, công nghệ RDMA cũng đã bắt đầu được áp dụng vào Ethernet để cạnh tranh với InfiniBand với giao thức RoCE và iWARP cho tốc độ đạt được lên đến 800Gbps. Tuy nhiên độ trễ hiện tại của Ethernet vẫn cao hơn InfiniBand (2us). Tại sao lại như vậy? Các công nghệ RDMA trên Ethernet có những đặc điểm riêng so với RDMA trên InfiniBand.

- Với iWARP, giao thức này vẫn tận dụng TCP làm giao thức truyền tải để đạt được độ tin cậy, giúp RDMA có thể hoạt động trên mạng Ethernet chuẩn mà không cần phần cứng RDMA chuyên dụng như InfiniBand. Điều này sẽ dẫn đến hiệu suất thấp hơn do phải xử lý TCP overhead

- RoCE lại sử dụng lớp UDP giúp truyền tải nhanh hơn nhưng cần switch phải hỗ trợ công nghệ kiểm soát luồng PFC để giảm mất gói tin. Do đó hiệu suất phụ thuộc vào QoS và PFC. Nếu mạng Ethernet không được tối ưu, RoCE có thể gặp vấn đề về tắc nghẽn và độ trễ cao hơn.

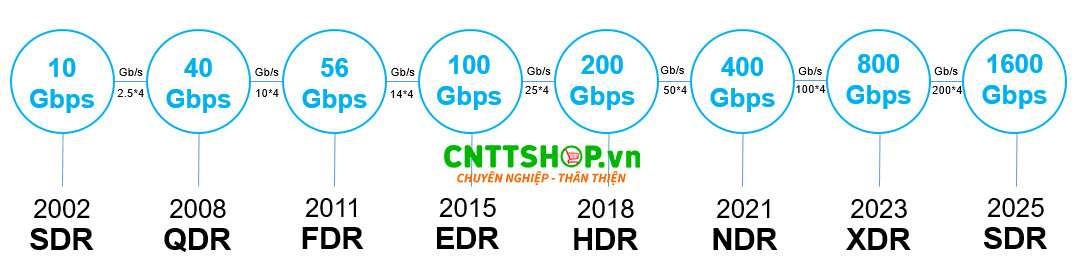

Trải qua 2 thập kỷ phát triển, tốc độ trên các card mạng InfiniBand đã được nâng cấp nhanh chóng. Đến năn 2025, băng thông đạt được đã lên tới 1,6Tbps với kiến trúc SDR và độ trễ chỉ dưới 400ns.

Mặc dù cùng được tích hợp công nghệ RDMA nhưng InfiniBand được triển khai ngay từ thời gian đầu với cơ chế Lossless kiểm soát được gói tin không bị mất ngay từ đầu, không cần TCP/IP để gửi lại gói tin giúp giảm đô trễ đáng kể.

Chi phí

Với sự ưu việt của công nghệ truyền tải dữ liệu thế hệ mới, InfiniBand có chi phí triển khai và vận hành cao hơn so với Ethernet, cụ thể:

- Card HCA thường có chi phí cao hơn card NIC của Ethernet do có phần cứng mạnh hơn và băng thông cao hơn. Ngược lại các card Ethernet thông thường có tốc độ thấp hơn và thường được sản xuất đại trà để phục vụ nhu cầu băng thông của doanh nghiệp và các cơ quan tổ chức nên giá thành sẽ thấp hơn.

- Switch Infiniband có chi phí cao hơn switch Ethernet do được tối ưu độ trễ cực thấp, không bị tắc nghẽn và thường được sử dụng trong kết nối siêu máy tính và huấn luyện các mô hình ngôn ngữ.

- Cáp được sử dụng trong mạng InfiniBand là cáp đồng (DAC) hoặc cáp quang (AOC) có chi phí cao hơn so với cáp quang và cáp đồng Cat5/6/7 của mạng Ethernet.

- Chi phí vận hành của InfiniBand có thể sẽ cao hơn do đòi hỏi đội ngũ kỹ thuật có chuyên môn về InfiniBand, làm tăng chi phí nhân sự. Hệ sinh thái phần mềm và công cụ quản lý có thể ít phổ biến hơn. Ngược lại mạng Ethernet dễ quản lý và bảo trì hơn do tính phổ biến và hệ sinh thái lớn mạnh.

Ứng dụng Ethernet và InfiniBand trong thời đại AI

Với sự bùng nổ của AI trong những năm gần đây, đặc biệt là việc phát triển các mô hình ngôn ngữ lớn như LLaMA, GPT-4 hay Gemini đòi hỏi hạ tầng mạng có hiệu suất cực cao (có thể lên đến hàng Terabyte) để truyền tải khối lượng dữ liệu khổng lồ giữa các GPU/TPU và đồng bộ trọng số mô hình giữa các node máy chủ. Cụ thể:

- Tốc độ truyền dữ liệu cực cao: AI tạo ra dữ liệu khổng lồ cần lượng băng thông cưc cao lên đến hàng trăm Gbps, thậm chí có thể lên đến hàng Tbps để truyền dữ liệu liên tục đến các node. Đồng thời cũng cần đảm bảo ít gói tin bị mất nhất tăng hiệu quả.

- Độ trễ thấp: Ngay cả độ trễ vài us của mạng Ethernet thông thường cũng có thể làm chậm quá trình huấn luyện ngôn ngữ và ảnh hưởng đến thông lượng. Do vậy để đảm bảo hiệu suất tốt, độ trễ cho phép thường chỉ dưới 1us.

- Khả năng mở rộng cao: Khi các mô hình AI ngày càng lớn, mở rộng từ vài chục đến hàng chục nghìn GPU/TPU mà vẫn giữ hiệu suất cao, không bị nghẽn cổ chai (bottleneck). Nếu mạng chậm, thời gian huấn luyện sẽ kéo dài.

Với ưu thế độ trễ cực thấp và thông lượng cực lớn khiến InfiniBand trở thành công nghệ lý tưởng cho các ứng dụng AI và HPC. InfiniBand có thể cung cấp 1600 Gbps cho mỗi cổng và mở rộng theo độ phức tạp của ứng dụng.

Ethernet với tiêu chuẩn hiện tại đã được nâng lên 800Gbps. Nhờ RoCEv2 và tốc độ cao hơn, truy cập bộ nhớ trực tiếp giữa các nút sẽ giảm bớt hầu hết gánh nặng của CPU. Tính hiệu quả về chi phí của Ethernet cũng khiến nó phù hợp với các công ty quy mô vừa và lớn đang mở rộng khối lượng công việc AI với yêu cầu băng thông và độ trễ thấp hơn.

Trong tương lai, Các mô hình AI sẽ trở nên lớn hơn, phức tạp hơn, đòi hỏi lượng dữ liệu huấn luyện khổng lồ và thời gian huấn luyện nhanh hơn. Điều này đồng nghĩa với việc tốc độ kết nối và độ trễ mạng sẽ đóng vai trò then chốt. Hiện tại, InfiniBand vẫn được coi là tiêu chuẩn vàng và nhiều tiềm năng phát triển cho các ứng dụng AI và điện toán hiệu năng cao (HPC).

Kết luận

Như vậy, Ethernet và InfiniBand đều đóng vai trò không thể thiếu trong việc xây dựng nền tảng mạng hiện đại. Đặc biệt với sự phát triển của AI, InfiniBand hiện duy trì ưu thế vượt trội về hiệu suất và độ trễ thấp, đặc biệt quan trọng cho các tác vụ huấn luyện chuyên sâu các mô hình ngôn ngữ lớn và điện toán hiệu năng cao. Trong tương lai công nghệ này sẽ tiếp tục được nghiên cứu và đẩy mạnh phát triển nhằm tăng tốc cho cuộc đua AI vốn là cốt lõi cho thời đại công nghệ 4.0. Bên cạnh đó, Ethernet cũng đang phát triển những tiêu chuẩn cải tiến hơn về tốc độ giúp đáp ứng rộng rãi nhu cầu kết nối trong doanh nghiệp và trung tâm dữ liệu. Cả InfiniBand và Ethernet sẽ tiếp tục thúc đẩy sự phát triển của CNTT nhằm tăng trải nghiệm của người dùng một cách hiệu quả.

.png)

Bình luận bài viết!