Làm thế nào để xây dựng một máy chủ AI cấu hình hiệu suất cao

Trí tuệ nhân tạo (AI) không chỉ là một lĩnh vực nghiên cứu mà còn trở thành một phần không thể thiếu của các ứng dụng thực tiễn trong nhiều ngành công nghiệp khác nhau. Việc xây dựng các máy chủ AI phù hợp với hiệu suất cao là một trong những bước quan trọng để tạo ra một nền tảng tính toán mạnh mẽ linh hoạt để nghiên cứu và triển khai các ứng dụng AI.

Tại bài viết này chúng tôi sẽ đưa ra một số các bước cần thiết để xây dựng cấu hình máy chủ AI hiệu suất cao. Từ việc đánh giá nhu cầu sử dụng cụ thể đến lựa chọn phần cứng và phần mềm phù hợp, chúng tôi sẽ cung cấp các gợi ý và lời khuyên để bạn có thể tạo ra một nền tảng tính toán mạnh mẽ và linh hoạt cho các ứng dụng AI.

1. Xác định nhu cầu sử dụng

Trước khi chọn và xây dựng cấu hình máy chủ AI, việc xác định nhu cầu sử dụng cụ thể là rất quan trọng. Dưới đây là một số loại máy chủ AI được phân loại phù hợp cho các ứng dụng và mô hình AI:

1.1. Máy chủ AI dành cho việc huấn luyện (AI Training)

Đây là một hệ thống tính toán chuyên biệt được thiết kế một cách tỉ mỉ nhằm tối ưu quá trình huấn luyện các mô hình trí tuệ nhân tạo (AI models). Các loại máy chủ này được xây dựng với các thành phần phần cứng và phần mềm đặc biệt để tăng tốc và tối ưu hóa quá trình huấn luyện, giúp cho các nhà nghiên cứu và các nhà phát triển AI có thể thực hiện công việc của mình một cách hiệu quả và nhanh chóng hơn.

Vì quá trình đào tạo các mô hình AI đòi hỏi tài nguyên tính toán lớn do sự phức tạp vốn có của nó, máy chủ đào tạo AI được thiết kế để giải quyết hiệu quả các tác vụ sử dụng nhiều tài nguyên tính toán (bao gồm cả CPU, GPU, RAM, bộ lưu trữ và băng thông mạng). Nó đảm nhận một vai trò quan trọng trong việc thúc đẩy sự tiến bộ của các mô hình AI trên các lĩnh vực khác nhau, bao gồm: xử lý ngôn ngữ tự nhiên, thị giác máy tính và nhận dạng giọng nói.

1.2. Máy chủ dành cho việc suy luận AI

Sau khi qua giai đoạn huấn luyện AI. Máy chủ AI được xây dựng để xử lý các yêu cầu suy luận từ các ứng dụng AI bằng cách sử dụng các mô hình AI đã được huấn luyện trước đó (quá trình này tính toán ở giai đoạn này thường không cần phải xử lý lượng dữ liệu lớn như trong quá trình đào tạo). Mục đích chính của máy chủ suy luận AI là thực hiện các dự đoán, đưa ra quyết định hoặc trả lời các yêu cầu dựa trên thông tin đã học từ các mô hình AI đã được huấn luyện (Ví dụ: phân loại hình ảnh, dự đoán giá cả, dịch ngôn ngữ tự nhiên).

Trong quá trình huấn luyện AI (trong phần 1.1 ở trên), mục tiêu trọng tâm là dạy các mô hình thông qua các tập dữ liệu lớn để nhận biết mẫu và tạo ra dự đoán. Trong khi máy chủ suy luận AI được dành riêng để áp dụng những mô hình AI đã được huấn luyện này để thực hiện các dự đoán và quyết định dựa trên dữ liệu đầu vào đang nhận được theo thời gian thực. Chính vì vậy máy chủ suy luận AI được thiết kế để xử lý các tác vụ yêu cầu phản hồi nhanh chóng và chính xác dựa trên kiến thức đã học từ quá trình huấn luyện trước đó. Mục đích là cung cấp các dịch vụ suy luận nhanh chóng và đáng tin cậy cho người dùng cuối và các ứng dụng AI khác.

1.4. Máy chủ tính toán xử lý hình ảnh (Visual Computing Server)

Đây là một hệ thống máy tính được thiết kế đặc biệt để xử lý các ứng dụng hình ảnh, từ đồ họa máy tính đến hoạt hình máy tính. Các ứng dụng của máy chủ tính toán hình ảnh bao gồm: Xử lý hình ảnh 3D trong y tế như chụp cắt lớp MRI + CT, Mô hình hóa 3D từ thiết kế sản phẩm đến phát triển trò chơi video, AR/VR 5G Edge hỗ trợ việc triển khai ứng dụng thực tế ảo (AR) và thực tế ảo (VR), Máy trạm ảo (Virtual Workstation).

1.5. Máy chủ tính toán hiệu suất cao (HPC)

Đây là một hệ thống máy chủ được thiết kế để xử lý các tác vụ tính toán phức tạp, khả năng xử lý dữ liệu và thực hiện các phép tính ở tốc độ cao có thể vượt qua mức một nghìn tỷ phép tính dấu phẩy động mỗi giây (teraFLOPS). Các yếu tố quan trọng của máy chủ HPC bao gồm sức mạnh xử lý, lượng dữ liệu lớn, kết nối mạng nhanh chóng và các công cụ tăng tốc. Các ứng dụng của máy chủ HPC bao gồm: Trí tuệ nhân tạo (Artificial Intelligence - AI), Học sâu (Deep Learning), Phân tích và Mô phỏng Khoa học (Scientific Analysis & Simulation), Mission Critical Workloads.

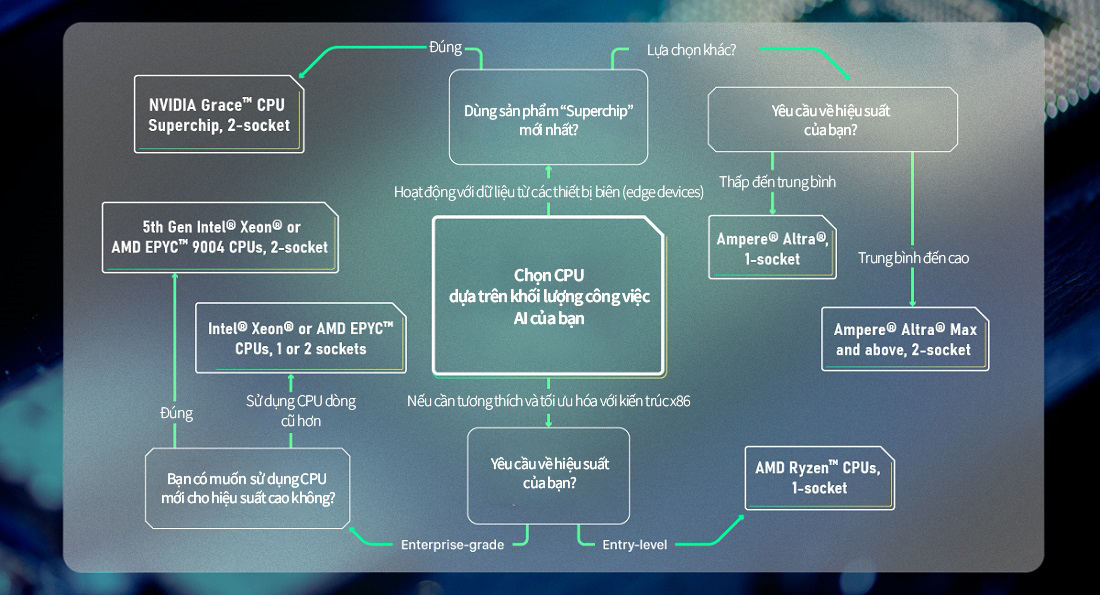

2. Làm thế nào để chọn CPU phù hợp cho máy chủ AI của bạn?

CPU vẫn là trái tim và linh hồn của tất cả các máy chủ AI. CPU là một bộ xử lý chính nhận lệnh từ người dùng và hoàn thành các "chu kỳ lệnh" để đưa ra kết quả mong muốn. Do đó, một phần lớn hiệu suất và sức mạnh của máy chủ AI phụ thuộc nhiều vào CPU và khả năng xử lý của nó.

Hiện nay không ai khác vẫn là 2 ông lớn Intel và AMD, là hai nhà sản xuất hàng đầu trong lĩnh vực CPU. Với dòng sản phẩm Intel Xeon Gen 5 của Intel và dòng CPU AMD EPYC™ 9004 của AMD đại diện cho đỉnh cao của các bộ vi xử lý có cấu trúc x86 và CISC. Nếu bạn muốn có máy chủ hiệu suất cao nhất, ổn định, và đã được kiểm tra thử nghiệm, thì 2 dòng CPU này của AMD hoặc Intel là lựa chọn lý tưởng.

Nhưng nếu ngân sách của bạn không cho phép sử dụng 1 trong 2 bộ CPU cao cấp ở trên, thì bạn có thể chọn lựa các dòng CPU thế hệ trước của Intel Xeon và AMD EPYC. Dòng sản phẩm AMD Ryzen™ cũng là một CPU tốt cho những dự án mới bắt đầu trong lĩnh vực AI, khi bạn không cần một bộ xử lý có quá nhiều lõi hoặc khả năng đa luồng cao.

Sự ra đời của các CPU dựa trên RISC (Reduced Instruction Set Computing) trong ngành công nghiệp trí tuệ nhân tạo (AI), đặc biệt là trong lĩnh vực siêu tính toán. RISC-based CPUs đang trở thành một đối thủ đáng gờm cho các CPU của AMD và Intel. Các bộ vi xử lý RISC có cấu trúc lệnh đơn giản hơn, giúp tiết kiệm năng lượng trong khi chứa nhiều lõi hơn, cho phép chúng có sức mạnh tính toán ngang bằng với các CPU x86 truyền thống khác.

Nếu bạn để ý gần như tất cả các thiết bị di động, điện thoại thông minh, cảm biến, camera an ninh, thiết bị IoT ..vv đều chạy trên các vi xử lý RISC, chúng có khả năng xử lý dữ liệu thu thập được một cách trực tiếp và hiệu quả, mà không cần sự can thiệp của một trình biên dịch bên ngoài (Điều này giúp giảm độ trễ và tăng cường hiệu suất của các hệ thống, đặc biệt là trong các ứng dụng đòi hỏi phản hồi nhanh và tính linh hoạt cao như IoT và các thiết bị di động). Do đó, nếu công việc AI của bạn liên quan đến dữ liệu từ các thiết bị di động hay các thiết bị gần với nguồn dữ liệu và người dùng, bạn có thể xem xét sử dụng các sản phẩm CPU dựa trên RISC nhé.

Một trong những dòng CPU dựa trên RISC nổi tiếng nhất là ARM, các CPU Ampere® tiên tiến nhất chứa khoảng 200 lõi trong một bộ xử lý duy nhất, đồng thời cung cấp tỷ lệ hiệu suất trên watt tốt nhất trong nghành, giúp giảm chi phí vận hành và chi phí đầu tư TCO. Một lựa chọn đặc biệt khác cho dòng CPU ARM là NVIDIA Grace™ CPU Superchip, nó kết hợp lõi ARM với các tính năng của NVIDIA đã được cấp bằng sáng chế, chẳng hạn như Kết nối NVLink-C2C 900GB/s và bộ nhớ LPDDR5X ECC đầu tiên trên thế giới.

Quyết định cuối cùng trong việc chọn CPU để xây dựng cấu hình máy chủ AI là lựa chọn số lượng CPU mà bạn muốn có trong máy chủ của mình. Cấu hình với hai bộ xử lý CPU sẽ có hiệu suất xử lý cao hơn và tính dự phòng tốt hơn, nhưng đi kèm với mức tiêu thụ năng lượng cao hơn, làm tăng nhu cầu về hệ thống làm mát và quản lý nhiệt độ. Và bạn cũng có thể lựa chọn sử dụng một bộ xử lý CPU đơn lẻ thay vì chạy 2 CPU, miễn là có đủ lõi CPU để đáp ứng xử lý các yêu cầu tính toán AI của bạn.

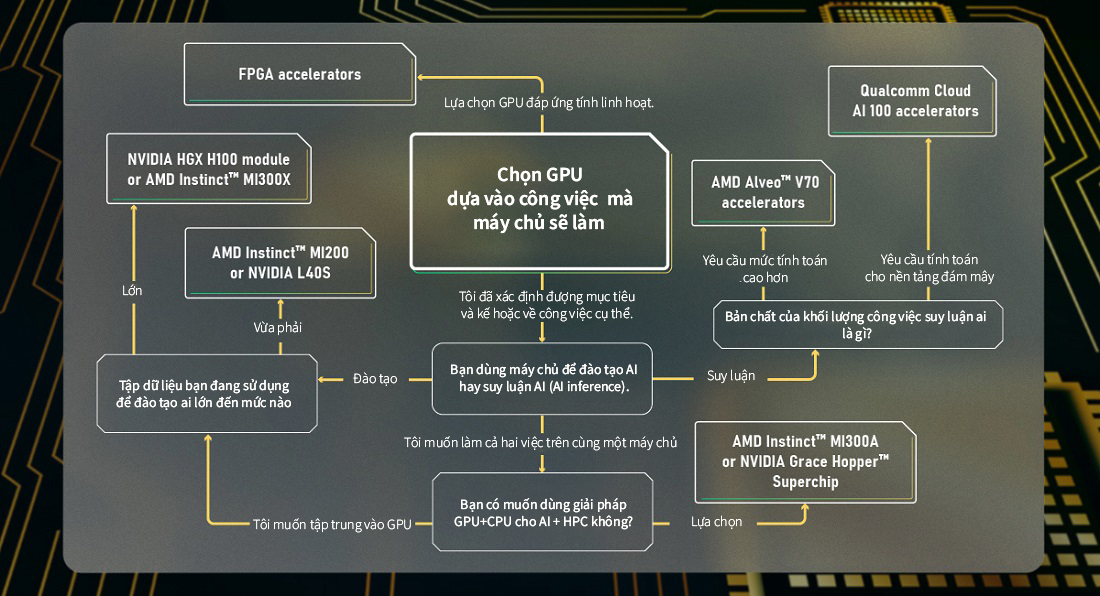

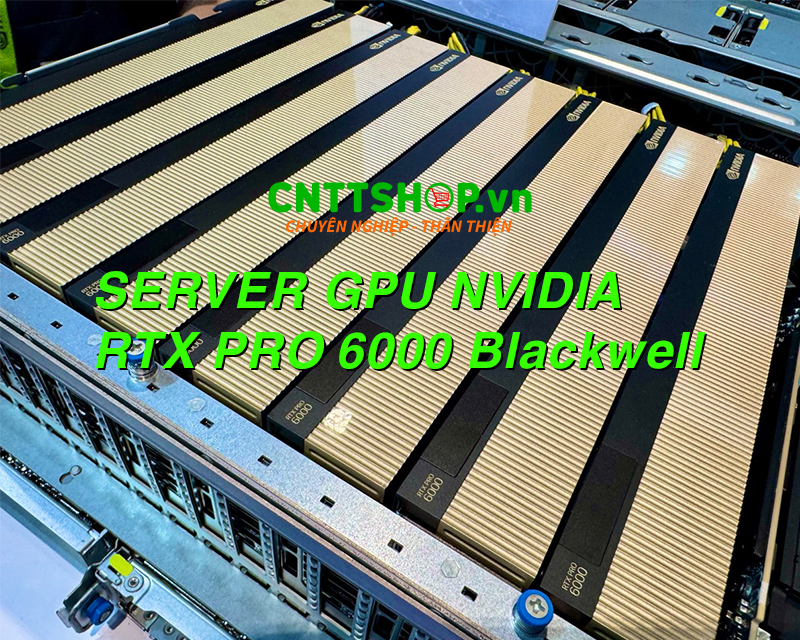

2. Làm thế nào để chọn GPU phù hợp cho máy chủ AI của bạn?

GPU là đơn vị xử lý đồ họa là thành phần quan trọng thứ hai sau CPU trong một máy chủ AI. Chúng đóng vai trò là bộ tăng tốc có thể giúp CPU xử lý khối lượng công việc AI nhanh hơn nhiều. Lý do là GPU có thể thực hiện các tác vụ song song và xử lý dữ liệu một cách hiệu quả hơn, đặc biệt là trong việc xử lý dữ liệu đồ họa và tính toán đồng thời.

Khi chọn GPU cho máy chủ AI, bạn chú ý quan tâm đến khối lượng công việc tính toán mà máy chủ AI cần thực hiện bao gồm (việc huấn luyện mô hình, suy luận, xử lý ảnh, xử lý ngôn ngữ tự nhiên và nhiều tác vụ AI khác). Công nghệ AI phát triển nhanh chóng và yêu cầu tính toán có thể thay đổi theo thời gian. Vì vậy, việc chọn GPU nên cân nhắc đến khả năng mở rộng và nâng cấp để đáp ứng được các yêu cầu công việc AI mới trong tương lai.

Nhưng nếu bạn muốn máy chủ của mình có sự linh hoạt có thể thích nghi với sự thay đổi công nghệ AI để xử lý nhiều nhiệm vụ khác nhau, GPU dựa trên cấu hình FPGA có thể là lựa chọn tốt hơn. Không giống như cấu trúc ASIC được thiết kế dành riêng cho một ứng dụng cụ thể và không thể thay đổi sau khi sản xuất, FPGA cho phép bạn thay đổi chức năng của nó bằng cách lập trình lại, mang lại sự linh hoạt lớn hơn cho quá trình phát triển và triển khai ứng dụng AI sau này. Gợi ý cho các bạn Xilinx, đã được AMD mua lại, là một nhà sản xuất chip FPGA nổi tiếng.

Một bước quan trọng tiếp theo là xem xét mục đích máy chủ của bạn dùng để huấn luyện trí tuệ nhân tạo (AI training) hay suy luận (inference). Cả hai quá trình này đều đòi hỏi xử lý lượng lớn dữ liệu và tính toán phức tạp. Tuy nhiên, cách thức mà dữ liệu được xử lý và sử dụng trong mỗi quá trình là khác nhau. Trong huấn luyện, dữ liệu thường được lưu trữ và truy cập nhiều lần trong bộ nhớ, trong khi suy luận thì không. Điều này yêu cầu các máy chủ AI phải được cấu hình một cách phù hợp để đáp ứng yêu cầu cụ thể của mỗi quá trình.

Trong quá trình đào tạo (AI training), mô hình AI tiêu thụ một lượng lớn dữ liệu lớn với hàng tỷ, thậm chí hàng nghìn tỷ tham số. Quá trình này đòi hỏi tính toán phức tạp và lượng lớn dữ liệu để điều chỉnh các trọng số của thuật toán, để mô hình có thể tạo ra kết quả phù hợp với đầu ra mong muốn. Trong quá trình suy luận, AI dựa trên bộ nhớ là các tham số đã được học từ trước của nó để đáp ứng với dữ liệu đầu vào mới trong thế giới thực. Cả hai quy trình này đều rất chuyên sâu về tính toán, và do đó, cần có bộ xử lý GPU được cài đặt để giúp tăng tốc mọi thứ.

2.1. Lựa chọn GPU cho máy chủ đào tạo AI (AI training)

GPU NVIDIA HGX™ H100 là một ví dụ cho lựa một bộ GPU hiệu suất cao, GPU này có khả năng cung cấp hơn 32 petaFLOPS của hiệu suất deep learning FP8. Mỗi GPU H100 SXM5 chứa các Tensor Cores thế hệ thứ tư sử dụng loại dữ liệu FP8 mới, cùng với một "Transformer Engine" để tối ưu hóa quá trình huấn luyện mô hình. NVLink® được sử dụng để kết nối các bộ xử lý với băng thông lên đến 900 GB/s, trong khi NVSwitch được sử dụng để điều phối cụm các GPU.

GPU AMD Instinct™ MI300X, là một sự lựa chọn mạnh mẽ khác. MI300X là bộ nhớ lớn và lưu lượng dữ liệu khổng lồ, điều này quan trọng đối với các công việc trí tuệ nhân tạo phát sinh dữ liệu, như mô hình ngôn ngữ lớn (LLM). Điều này cho phép các mô hình như Falcon-40, một mô hình có 40 tỷ tham số, chạy trên một bộ GPU MI300X duy nhất.

Nếu ngân sách đầu tư của bạn hạn và bộ dữ liệu đào tạo AI của bạn không quá lớn, bạn có thể sử dụng các bộ GPU khác có hiệu suất thấp hơn của AMD và NVIDIA. Ví dụ như: GPU AMD Instinct™ MI200 Series, GPU NVIDIA L40S.

2.2. Lựa chọn GPU để suy luận AI (AI inference)

Để suy luận AI, hãy thử tìm kiếm các GPU có ưu điểm tính năng cụ thể, phù hợp với nhu cầu và yêu cầu của một ứng dụng hay tình huống sử dụng cụ thể trong suy luận AI (Điều này giúp bạn tìm được card GPU phù hợp và tối ưu chi phí đàu tư). Ví dụ: GPU AMD Alveo™ V70 dựa trên kiến trúc XDNA™ của AMD, được chú ý với kiến trúc luồng dữ liệu thích ứng cho phép dữ liệu truyền qua các lớp của mô hình AI mà không yêu cầu bộ nhớ ngoài. Nó giúp cải thiện hiệu suất và giảm độ trễ, trở thành giải pháp lý tưởng cho khối lượng công việc AI đòi hỏi cao. GPU NVIDIA A2 Tensor Core và GPU L4 Tensor Core, cũng là một lựa chọn tuyệt vời nhằm giải quyết khối lượng công việc suy luận AI.

Nếu khối lượng công việc suy luận của bạn được thực hiện trên nền tảng đám mây, việc lựa chọn GPU có thể được định hình bởi các yếu tố khác như hiệu quả năng lượng và khả năng xử lý tín hiệu. Trong trường hợp này, bạn có thể xem xét GPU Qualcomm® Cloud AI 100, có thể suy luận AI trực tiếp trên thiết bị cục bộ hoặc gần nguồn dữ liệu hiệu quả hơn vì chúng giải quyết các yêu cầu riêng của điện toán đám mây.

Các bạn lưu ý do yêu cầu tính toán cho huấn luyện trí tuệ nhân tạo (AI training) thường cao hơn so với suy luận, nên hầu hết các máy chủ huấn luyện AI cũng có thể được sử dụng cho công việc suy luận.

2.3. Lựa chọn GPU cho máy chủ tính toán hiệu suất cao (HPC)

Một lựa chọn khác do các hãng công nghệ đưa ra cho người dùng là sự kết hợp sức mạnh giữa CPU và GPU, mang tới sự kết hợp tốt nhất cho tất cả các loại công việc trí tuệ nhân tạo (AI) và tính toán cao cấp (HPC). Đó chính là 2 dòng GPU NVIDIA Grace Hopper™ Superchip và AMD Instinct™ MI300A đây là APU đầu tiên của AMD dành cho trung tâm dữ liệu, cả hai đều là những lựa chọn xuất sắc cho máy chủ AI. Hãy chọn những sản phẩm này nếu bạn muốn làm việc với nền tảng siêu tính toán phức tạp nhất hiện nay.

Trên đây là một số chia sẻ hữu ích từ CNTShop sẽ giúp bạn chọn được bộ xử lý trung tâm (CPU) và Card đồ họa (GPU) phù hợp cho máy chủ AI của bạn. Mặc dù năng lực xử lý là tối quan trọng, nhưng còn có nhiều thành phần khác tham gia vào quá trình điện toán AI chứ không phải chỉ có CPU và GPU. Trong những phần nội dung dưới đây, hãy chúng tôi sẽ phân tích thêm để chọn bộ nhớ RAM, bộ lưu trữ Storage, bộ cấp nguồn (PSU), quản lý nhiệt độ, khe cắm mở rộng và cổng I/O, đúng với máy chủ để làm việc với AI. Tất cả chúng đều ảnh hưởng đến hiệu suất của máy chủ của bạn.

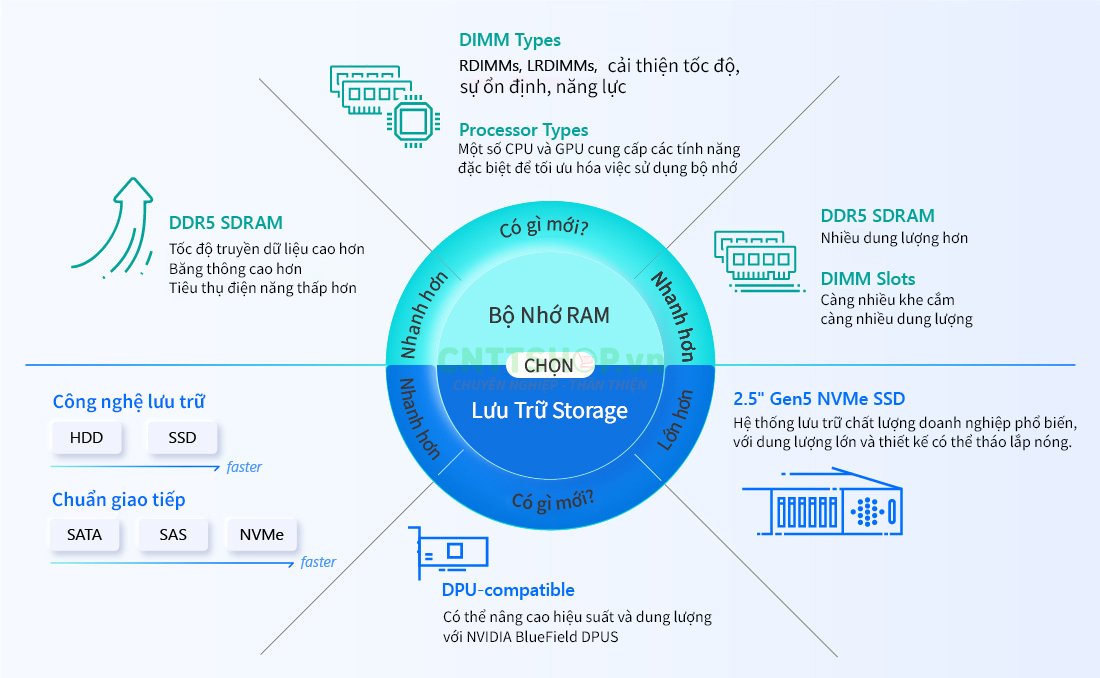

3. Làm thế nào để chọn bộ nhớ RAM phù hợp cho máy chủ AI của bạn?

RAM là bộ nhớ được sử dụng trong máy chủ để lưu trữ các chương trình và dữ liệu để bộ vi xử lý sử dụng ngay lập tức. Trong máy chủ dành cho trí tuệ nhân tạo, nơi mà các chip AI mạnh mẽ có khả năng tính toán một lượng lớn dữ liệu một cách nhanh chóng, việc sử dụng bộ nhớ không đủ sẽ làm giảm hiệu suất của chúng. Chính vì vậy bộ nhớ của máy chủ phải luôn có đủ thông lượng và dung lượng để hỗ trợ bộ xử lý.

Hiện tại, loại bộ nhớ tiên tiến nhất là DDR5 SDRAM, là thế hệ thứ 5 của bộ nhớ truy cập ngẫu nhiên động đồng bộ tốc độ dữ liệu kép. Chúng tôi sẽ gọi tắt là DDR5. Nó cung cấp tốc độ truyền dữ liệu cao hơn, băng thông cao hơn, yêu cầu điện áp thấp hơn và dung lượng lớn hơn các thế hệ trước, khiến nó trở thành thành phần bộ nhớ được lựa chọn cho các cấu hình máy chủ AI hàng đầu.

Rõ ràng, là sử dụng một thanh RAM (chính xác hơn được gọi là DIMM) sẽ không đủ. Các bạn nhớ rằng có 2 loại DIMM là RDIMMs và LRDIMMs cả hai loại DIMMs này đều có mục tiêu là cải thiện hiệu suất, ổn định và hỗ trợ mở rộng dung lượng của bộ nhớ trong hệ thống, tùy thuộc vào các yêu cầu cụ thể của máy chủ.

4. Làm thế nào để chọn hệ thống lưu trữ phù hợp cho máy chủ AI của bạn?

Bộ nhớ RAM được sử dụng để lưu trữ dữ liệu mà máy chủ cần sử dụng ngay lập tức, trong khi ổ cứng hay hệ thống Storage giữ lại tất cả dữ liệu của máy chủ một cách vĩnh viễn cho đến khi người dùng xóa nó. Bạn cần xem xét ba tiêu chí quan trọng để chọn các thiết bị lưu trữ:

- Tốc độ: Đây bao gồm tỷ lệ truyền dữ liệu và băng thông, tức là khả năng truyền dữ liệu nhanh chóng giữa bộ lưu trữ và các thành phần khác của hệ thống như CPU và GPU.

- Dung lượng lưu trữ: Đây là khả năng của bộ lưu trữ để lưu trữ dữ liệu, được đo bằng đơn vị như gigabyte hoặc terabyte, phản ánh số lượng dữ liệu mà nó có thể chứa.

- Khả năng tương thích với DPU (Data Processing Unit): DPU được xem là phần quan trọng thứ 3 trong trung tâm dữ liệu hiện đại, bên cạnh CPU và GPU. Nó được thiết kế để xử lý dữ liệu đám mây và các công việc liên quan đến kết nối mạng. Tính tương thích với DPU đảm bảo rằng bộ lưu trữ có thể hoạt động hiệu quả trong môi trường đám mây hiện đại, đồng thời đáp ứng các yêu cầu về xử lý dữ liệu mạng.

Chúng tôi xin không nhắc tới ổ cứng HDD vì ổ cứng SDD từ lâu đã vượt xa ổ đĩa cứng (HDD) là thiết bị lưu trữ cao cấp và chắc chắn nên được sử dụng trong máy chủ AI của bạn. Có ba loại giao diện lưu trữ: SATA, SAS và NVMe. SATA là công nghệ lâu đời nhất và ban đầu được thiết kế để sử dụng với ổ cứng. SAS nhanh hơn SATA, nhưng nhà vô địch là NVMe, chỉ có thể được sử dụng với SSD. Vì NVMe sử dụng công nghệ PCIe để cải thiện tốc độ đọc/ghi và tăng băng thông giữa các thiết bị lưu trữ và bộ xử lý, kết quả là tốc độ truyền dữ liệu nhanh hơn và độ trễ thấp hơn. Do đó, SSD sử dụng chuẩn kết nối NVMe Gen5 mới nhất là lựa chọn số một cho các thiết bị lưu trữ trong máy chủ AI.

Nói chung, SSD NVMe sử dụng kích cỡ M.2 nhỏ hơn hoặc có kích thước SFF 2,5 inch phổ biến hơn. Do vậy chúng ta nên chọn các máy chủ có sử dụng khoang lưu trữ 2,5" do cần dung lượng lớn hơn và thiết kế có thể thay thế nóng, cho phép các khoang được tháo ra hoặc thay thế một cách thuận tiện mà không cần phải tắt nguồn máy chủ.

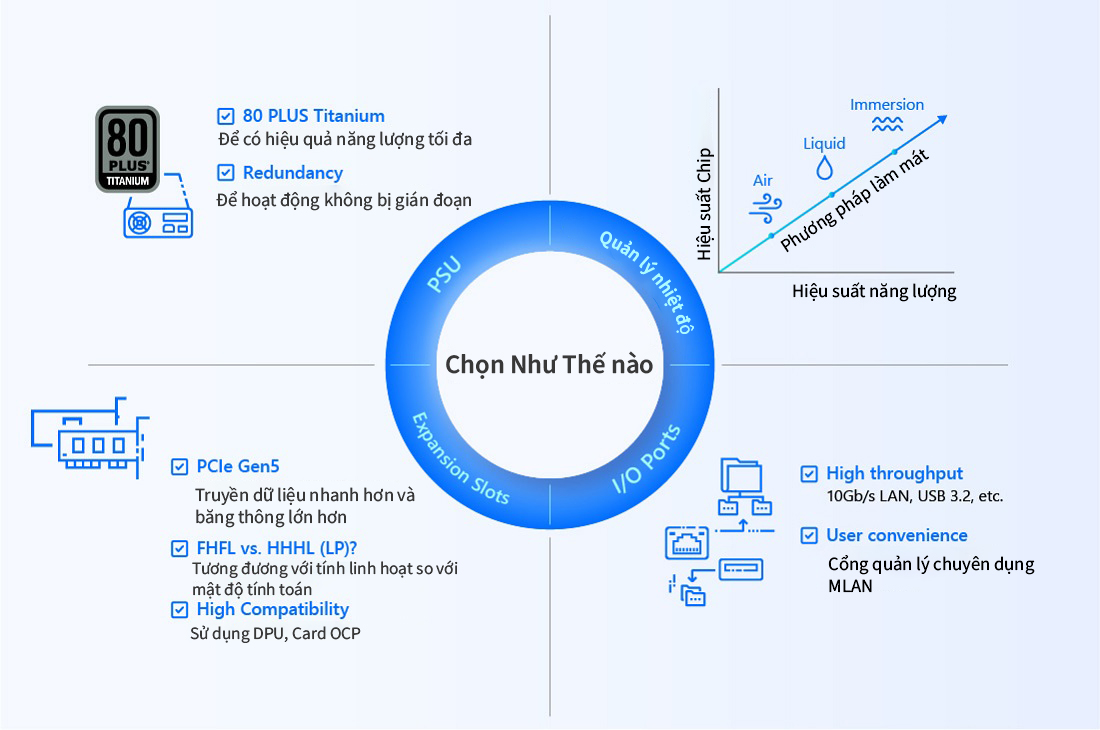

5. Làm thế nào để chọn bộ cấp nguồn (PSU) phù hợp cho máy chủ AI của bạn?

Bộ cấp nguồn (PSU) của máy chủ cung cấp nguồn điện an toàn, ổn định để máy chủ chạy. Vì khối lượng công việc AI có xu hướng tính toán chuyên sâu, nên bắt buộc phải chọn cấu hình PSU mang lại hiệu quả năng lượng và dự phòng vượt trội.

Cách tốt nhất để kiểm tra hiệu quả năng lượng của PSU là thông qua chương trình chứng nhận được gọi là 80 PLUS. Chương trình này tách PSU thành sáu cấp độ khác nhau dựa trên hiệu quả năng lượng, với 80 PLUS Titanium là hiệu quả nhất. Ở cấp độ này, hiệu suất chuyển đổi (nghĩa là bao nhiêu năng lượng đầu vào được chuyển đổi thành đầu ra hữu ích) là từ 90% đến 96%, nói một cách chính xác. Mức cao thứ hai là 80 PLUS Platinum, trong đó hiệu suất chuyển đổi là từ 89% đến 94%. Bạn nên sử dụng máy chủ AI có PSU được chứng nhận 80 PLUS Titanium là ok.

Một điều khác quan trọng cần nhớ là dự phòng là điều cần thiết. Máy chủ sẽ vẫn hoạt động ngay cả khi một hoặc nhiều PSU gặp sự cố. Máy chủ AI của của bạn nên được thiết kế với số lượng nguồn điện dự phòng thích hợp. Một số máy chủ có thể tiếp tục hoạt động bình thường ngay cả khi một nửa số PSU của nó ngưng hoạt động.

6. Làm thế nào để chọn bộ quản lý nhiệt phù hợp cho máy chủ AI của bạn?

Tất cả các thành phần bên trong máy chủ tạo ra rất nhiều nhiệt. Chọn đúng công cụ quản lý nhiệt hoặc tản nhiệt là rất quan trọng nếu bạn muốn có được hiệu suất tốt nhất từ máy chủ của mình mà không làm chi phí tiền điện.

Phương pháp truyền thống để giữ cho máy chủ mát mẻ là làm mát bằng không khí. Nói cách khác, quạt được lắp đặt trong máy chủ để lùa không khí nóng ra ngoài. Tất cả các Máy chủ AI của bản cần áp dụng thiết kế phần cứng tối ưu cho khả năng làm mát. Hướng của luồng không khí trong khung gầm máy chủ phải được đánh giá bằng phần mềm mô phỏng để tối ưu hóa thông gió. Quạt hiệu suất cao và tản nhiệt được lắp đặt để tăng cường hơn nữa khả năng tản nhiệt. Chương trình điều khiển tốc độ quạt tự động theo dõi nhiệt độ tại các điểm tới hạn và điều chỉnh tốc độ của (các) quạt tương ứng cho phù hợp. Cấu hình tốc độ quạt cũng có thể được tinh chỉnh thủ công để đạt được sự cân bằng phù hợp giữa quản lý nhiệt và mức tiêu thụ năng lượng.

bạn cũng có thể xây dựng máy chủ hỗ trợ làm mát bằng chất lỏng. Đây là một phương pháp quản lý nhiệt mới sáng tạo bơm chất làm mát chất lỏng thông qua các vòng lạnh cuộn quanh các thành phần chính trong máy chủ và hấp thụ nhiệt. Làm mát bằng chất lỏng có khả năng giải phóng toàn bộ tiềm năng của bộ xử lý đồng thời cải thiện PUE tổng thể của trung tâm dữ liệu.

Trong một số trung tâm dữ liệu hiện đại, đỉnh cao của làm mát bằng chất lỏng là làm mát ngâm, nhấn chìm máy chủ trực tiếp trong bể chất lỏng điện môi, không dẫn điện.

7. Làm thế nào để chọn các khe cắm mở rộng phù hợp cho máy chủ AI của bạn?

Cần chú ý đến các khe mở rộng trên máy chủ AI, vì tính mở rộng này cho phép bạn tăng cường hoặc thay đổi các tính năng và chức năng của máy chủ khi nhu cầu tăng lên. Các khe cắm trên bo mạch chủ được sử dụng để cắm thêm các thành phần mở rộng như card đồ họa, card mạng, hoặc các card tính toán phụ trợ khác.

Đầu tiên, hãy sử dụng bo mạch chủ MainBoard có khe cắm PCIe Gen5 (càng nhiều khe càng tốt). Băng thông của PCIe Gen5 là 128 GB/s và tốc độ truyền dữ liệu của nó là 32 GT/s, cả hai chỉ số này đều tăng gấp đôi so với thế hệ trước. Các khe cắm này sẽ cho phép bạn thêm card đồ họa, card RAID bổ sung, thậm chí cả các DPU nói ở trên, có thể xử lý truyền dữ liệu, nén dữ liệu, lưu trữ dữ liệu, bảo mật dữ liệu và phân tích dữ liệu cho CPU, cải thiện hơn nữa hiệu suất của máy chủ.

Bạn để ý những ký hiệu trên khung chassis của máy chủ AI, nó thể hiện các tiêu chuẩn về kích thước như sau:

- FHFL (full-height, full-length): Đây là card có chiều cao và chiều dài đầy đủ. Thường được sử dụng cho các card có kích thước lớn như card đồ họa cao cấp hoặc card RAID.

- HHHL (half-height, half-length), còn được gọi là LP (low-profile): Đây là card có chiều cao và chiều dài chỉ là một phần so với card FHFL. Thường được sử dụng cho các card nhỏ gọn hoặc card có yêu cầu không gian vật lý ít.

Trong quá trình chọn lựa, bạn cần phải cân nhắc giữa tính linh hoạt của các khe mở rộng và mật độ tính toán mà bạn muốn đạt được. Bạn cũng cần chú ý đến các khe mở rộng dạng OCP mezzanine, cần thiết cho các card mạng và lưu trữ OCP, nếu có kế hoạch sử dụng các phụ kiện này trong máy chủ AI của bạn.

8. Làm cách nào để chọn cổng I/O phù hợp cho máy chủ AI của bạn?

Thành phần cuối cùng cần xem xét để lựa chọn trong máy chủ AI của bạn là cách nó sẽ kết nối với các thiết bị bên ngoài, chẳng hạn như thiết bị chuyển mạch Switch, màn hình và các máy chủ khác. Và lời khuyên cho bạn là hãy lựa chọn có càng nhiều cổng với công nghệ và tốc độ cao nhất càng tốt. Nên chọn các cổng LAN với tốc độ truyền dữ liệu từ 1Gb/s, 10Gb/s, 40Gb/s hoặc cao hơn và các cổng USB 3.0 trở lên (ví dụ như USB 3.2).

Bạn cũng chú ý xem máy chủ của bạn có các cổng quản lý chuyên dụng hay không, còn được gọi là MLAN. Chúng cung cấp quyền truy cập an toàn vào BMC của máy chủ, có thể hữu ích nếu bạn muốn một cách thuận tiện hơn để quản lý máy chủ của mình. Khi mọi thứ đã sẵn sàng, bạn sẽ có một nền tảng siêu máy tính phù hợp lý tưởng với khối lượng công việc AI của mình.

9. Kết luận

Cảm ơn các bạn đã xem những chia sẻ từ CNTTShop về cách chọn máy chủ phù hợp hiệu suất cao cho trí tuệ nhân tạo? Chúng tôi hy vọng bài viết này hữu ích và nhiều thông tin thú vị tới các bạn. Nếu bạn đọc đang cần chọn mua và xây dựng cấu hình máy chủ AI phù hợp hiệu suất cao, vui lòng liên hệ tới chúng tôi để được các chuyên gia về máy chủ hỗ trợ tốt nhất.

Công Ty TNHH Công Nghệ Việt Thái Dương

Đ/C tại Hà Nội: NTT03, Line1, Thống Nhất Complex, 82 Nguyễn Tuân, Thanh Xuân, Hà Nội.

Đ/C tại HCM: Số 13, đường 7C, khu phố 4, phường An Phú, TP Thủ Đức, Hồ Chí Minh

Điện Thoại: 0906 051 599

Website: www.cnttshop.vn

.png)

Bình luận bài viết!