Giới thiệu tổng quan về InfiniBand

Tìm hiểu InfiniBand là gì?

InfiniBand (IB) là một công nghệ mạng tốc độ cao, được thiết kế chuyên biệt cho các hệ thống điện toán hiệu suất cao (HPC) và trung tâm dữ liệu AI. Với khả năng truyền tải dữ liệu nhanh chóng (tốc độ hiện tại lên tới 800Gbps) và độ trễ cực thấp (dưới 2μs), InfiniBand giúp kết nối hiệu quả giữa máy chủ, bộ lưu trữ và các thiết bị tính toán khác.

Không giống như Ethernet, InfiniBand áp dụng các công nghệ giúp giảm tải cho CPU, tối ưu hóa hiệu suất hệ thống và hỗ trợ các tính năng quan trọng như ảo hóa, Chất lượng dịch vụ (QoS) và truy cập bộ nhớ từ xa (RDMA).

Nhờ khả năng xử lý dữ liệu mạnh mẽ và tối ưu hóa băng thông, InfiniBand đang được sử dụng nhiều trong các trung tâm dữ liệu AI, đặc biệt trong việc kết nối các máy chủ GPU phục vụ đào tạo và suy luận mô hình trí tuệ nhân tạo.

Vì sao InfiniBand được sử dụng nhiều trong trung tâm dữ liệu AI, HPC hiệu suất cao?

InfiniBand là giải pháp mạng tiên tiến, được thiết kế chuyên dụng để đáp ứng các yêu cầu khắt khe của trung tâm dữ liệu AI và hệ thống HPC. Với băng thông siêu cao (trong năm 2025 có thể đạt được tốc độ kết nối lên tới 1600Gbps), độ trễ cực thấp và khả năng truyền dữ liệu không mất gói, IB đảm bảo hiệu suất tối đa cho các tác vụ AI chạy song song trên hàng nghìn GPU, CPU, FPGA… Điều này giúp tối ưu hóa luồng dữ liệu phức tạp, đảm bảo độ ổn định, loại bỏ tắc nghẽn và giữ cho hệ thống hoạt động mượt mà ngay cả khi xử lý khối lượng công việc khổng lồ. Nhờ đó, InfiniBand trở thành lựa chọn hàng đầu cho các trung tâm dữ liệu hiện đại, có nhu cầu huấn luyện nhiều mô hình suy luận lớn, thúc đẩy sự phát triển của AI và điện toán hiệu năng cao.

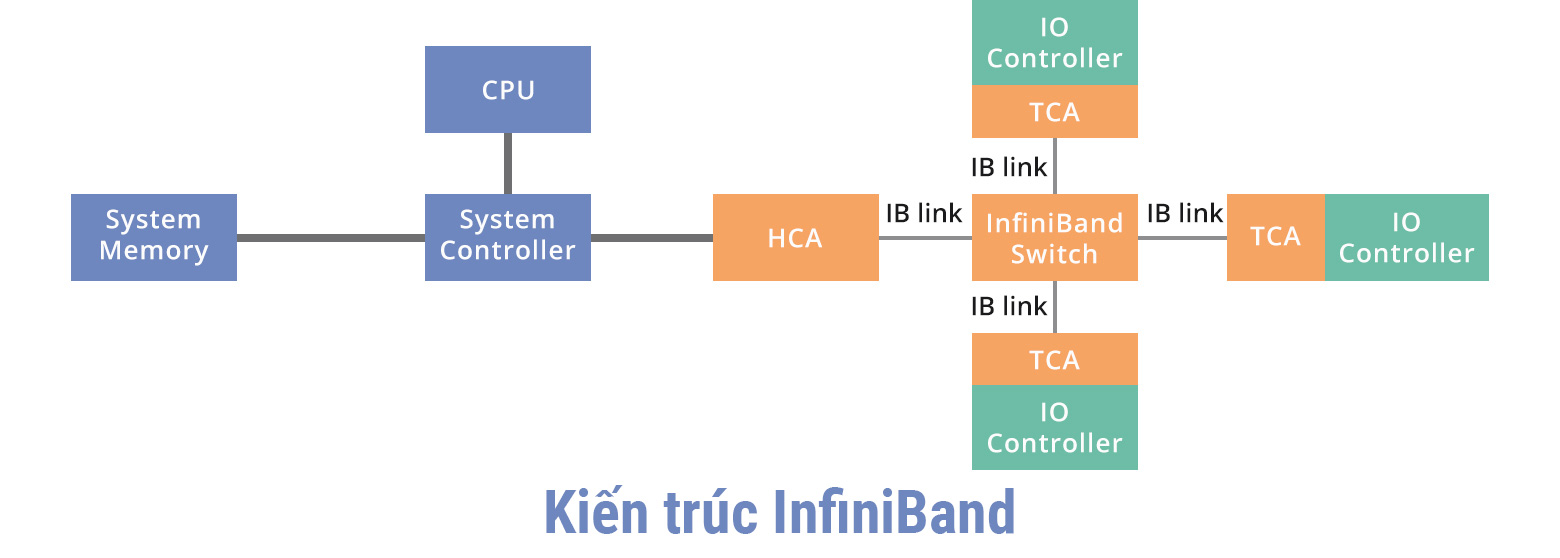

Kiến trúc của InfiniBand

InfiniBand là một công nghệ mạng sử dụng kiến trúc switched fabric, nơi nhiều nút được liên kết thông qua các switch nhằm cung cấp băng thông cao và độ trễ thấp. Kiến trúc này đặc biệt phù hợp cho các hệ thống tính toán hiệu năng cao (HPC) và các ứng dụng yêu cầu khả năng truyền dữ liệu nhanh chóng và ổn định.

Hệ thống InfiniBand dựa trên mô hình kênh và bao gồm bốn thành phần chính:

- Bộ điều hợp kênh chủ (HCA - Host Channel Adapter): Đây là thiết bị chịu trách nhiệm kết nối máy chủ với mạng InfiniBand. HCA hỗ trợ truyền tải dữ liệu giữa máy chủ và các thiết bị khác trong mạng, giúp tối ưu hóa hiệu suất giao tiếp.

- Bộ chuyển đổi kênh mục tiêu (TCA - Target Channel Adapter): TCA thực hiện chức năng tương tự HCA nhưng trên các thiết bị mục tiêu. Nó đảm nhiệm việc nhận và xử lý dữ liệu trên các thiết bị mục tiêu này.

- Liên kết InfiniBand: Đây là các kết nối vật lý giữa các thành phần trong mạng, có thể được triển khai bằng cáp đồng, cáp quang hoặc thậm chí là liên kết trên bo mạch. Những liên kết này đóng vai trò nền tảng trong việc truyền dữ liệu giữa các thiết bị.

- Switch và bộ định tuyến InfiniBand: Các thiết bị này giúp quản lý luồng dữ liệu trong hệ thống bằng cách định tuyến các gói tin giữa các thiết bị khác nhau kết nối trong mạng, đảm bảo việc truyền thông cũng như trao đổi dữ liệu liền mạch.

Phương thức hoạt động của InfiniBand

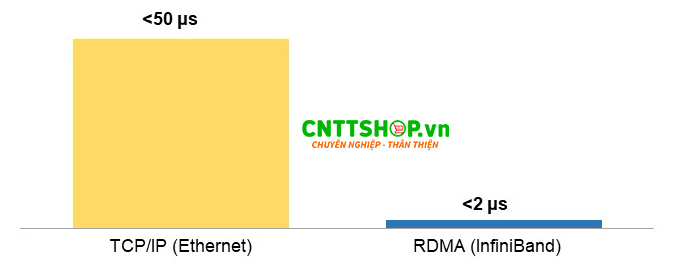

InfiniBand hoạt động dựa trên giao thức RDMA, có sự khác biệt so với giao thức TCP/IP truyền thống bằng cách loại bỏ sự can thiệp của CPU trong quá trình truyền dữ liệu, cho phép một máy chủ có thể truy cập trực tiếp vào bộ nhớ của máy chủ khác mà không cần thông qua CPU, giúp giảm tải cho phần cứng. Với RDMA, mạng có thể tự xác định ứng dụng đích của gói tin cũng như vị trí cụ thể trong bộ nhớ ứng dụng - nơi dữ liệu sẽ được lưu trữ ngay khi được nhận. Thay vì gửi gói tin đến CPU để xử lý và thực hiện sao chép dữ liệu vào không gian bộ nhớ ứng dụng, gói tin sẽ được chuyển trực tiếp tới nơi cần đến, giúp giảm độ trễ trong mạng vì cắt bớt được các hoạt động trung gian.

So sánh độ trễ end-to-end ở lớp ứng dụng giữa InfiniBand và Ethernet

Giới thiệu về mạng InfiniBand (InfiniBand Networks)

Mạng InfiniBand được thiết kế để cung cấp băng thông rộng và độ trễ cực thấp, đặc biệt phù hợp với các trung tâm dữ liệu quy mô lớn, siêu máy tính và các ứng dụng tính toán hiệu năng cao (HPC).

Khi so sánh InfiniBand với Ethernet truyền thống, chúng ta sẽ thấy rõ được sự khác biệt. Mạng InfiniBand sử dụng các InfiniBand adapters hoặc InfiniBand switch chuyên dụng để truyền dữ liệu, mang lại khả năng giao tiếp nhanh hơn và tối ưu hơn giữa các nút trong hệ thống.

Mạng InfiniBand truyền dữ liệu dựa trên RDMA thay vì TCP/IP như Ethernet truyền thống nên có độ trễ thấp hơn. So với một switch Ethernet có độ trễ port-to-port khoảng 230 ns, một switch InfiniBand với số cổng tương đương chỉ có độ trễ khoảng 100 ns. Điều này giúp tăng tốc quá trình truyền dữ liệu và giảm thiểu thời gian chờ, đóng vai trò quan trọng trong các hệ thống yêu cầu hiệu năng cao.

Mạng InfiniBand được quản lý tập trung thông qua Subnet Manager (SM), đóng vai trò tính toán và phân phối bảng forwarding của toàn bộ mạng. Ngoài ra, SM còn chịu trách nhiệm thiết lập các thông số quan trọng như phân vùng mạng (partitioning), chất lượng dịch vụ (QoS), và các cấu hình khác.

Hạ tầng của InfiniBand yêu cầu các thành phần chuyên dụng bao gồm card mạng InfiniBand (IB Network Card), switch InfiniBand (IB Switch), cáp InfiniBand (IB Cable) và các module quang tương ứng. Nhờ vào kiến trúc tối ưu hóa và khả năng mở rộng mạnh mẽ, mạng InfiniBand ngày càng được ứng dụng rộng rãi trong các hệ thống điện toán đám mây, trí tuệ nhân tạo và nghiên cứu khoa học.

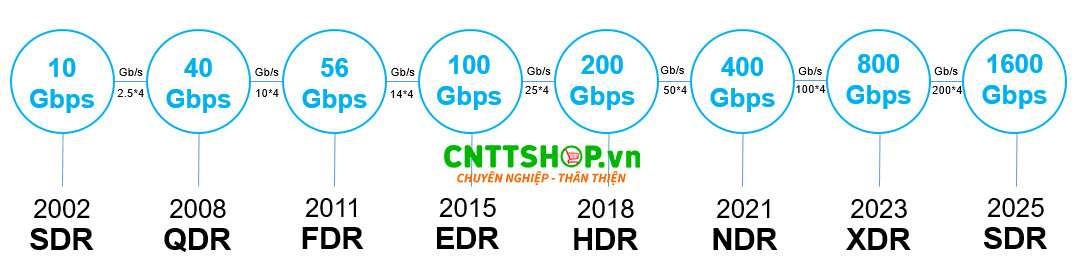

Các chuẩn tốc độ của InfiniBand

Xuất hiện từ đầu những năm 2000, trải qua hơn 2 thập kỷ phát triển, các card mạng InfiniBand đã được nâng cấp nhanh chóng về mặt tốc độ. Từ tên gọi SDR năm 2002 với tốc độ 10Gbps đến hiện tại đã có các tùy chọn cao hơn: NDR (400Gbps), XDR (800Gbps) hay SDR (1600Gbps) để đáp ứng cho nhu cầu ngày càng cao của các trung tâm dữ liệu huấn luyện mô hình AI siêu lớn, hệ thống HPC hiệu suất cực cao.

Tốc độ của InfiniBand phát triển nhanh chóng qua các thời kỳ (Nguồn: fibermall.com)

Các hãng sản xuất thiết bị InfiniBand nổi bật nhất

Hiện nay, thị trường có sự góp mặt của nhiều nhà cung cấp thiết bị InfiniBand lớn như NVIDIA, Intel, Cisco và HPE, trong đó NVIDIA chiếm ưu thế vượt trội với hơn 70% thị phần.

Sau khi mua lại Mellanox Technologies vào năm 2019, NVIDIA trở thành nhà cung cấp thiết bị InfiniBand hàng đầu hiện nay. Với dòng sản phẩm NVIDIA Quantum-2 InfiniBand, hãng cung cấp các thiết bị Switch InfiniBand có tốc độ lên đến 400Gbps/cổng, giúp tối ưu hiệu suất trong các hệ thống HPC, AI và cloud computing.

Một minh chứng rõ ràng cho sức mạnh từ thiết bị InfiniBand của hãng đó là các siêu máy tính trong TOP mạnh nhất thế giới như Eagle (TOP3) sử dụng NVIDIA InfiniBand NDR, Leonardo (TOP 6) sử dụng Quard-rail NVIDIA HDR100 InfiniBand. Phần lớn các trung tâm dữ liệu AI và HPC lớn như Google, Microsoft, AWS cũng tích hợp hệ thống InfiniBand của hãng.

Các hãng như Cisco, HPE cũng được biết đến trong thị trường InfiniBand nhưng hiện tại đều tập trung nhiều hơn vào mảng Ethernet và các công nghệ Networking khác. Nhờ đó, INVIDIA ngày càng khẳng định được vị thế thống trị của mình trong việc cung cấp sản phẩm InfiniBand hiệu suất cao cho hạ tầng trung tâm dữ liệu AI và HPC.

Nếu bạn đang có nhu cầu cần tư vấn về các thiết bị InfiniBand của NVIDIA, hãy liên hệ ngay tới CNTTShop để được hỗ trợ vì hiện tại ở Việt Nam, chúng tôi là đơn vị uy tín cung cấp các sản phẩm NVIDIA chính hãng. Từ GPU, card đồ họa, server cho tới các thiết bị InfiniBand, đội ngũ kỹ sư chuyên nghiệp của chúng tôi đều có thể tư vấn chính xác theo nhu cầu sử dụng của bạn và đảm bảo chất lượng sản phẩm cao cấp, bảo hành chính hãng.

.png)

Bình luận bài viết!