Top 5 GPU NVIDIA cho AI & Deep Learning năm 2025

AI đang tái định hình cách doanh nghiệp vận hành, tối ưu hóa nguồn lực và nâng cao hiệu suất. Từ các mô hình ngôn ngữ lớn (LLM) như GPT, LLaMA, Gemini… đến hệ thống tự động hóa, phân tích dữ liệu và thị giác máy tính, AI không chỉ giúp giảm tải công việc, tăng năng suất mà còn mở ra nhiều cơ hội mới. Khi kết hợp với Deep Learning, AI có thể học hỏi, dự đoán và tự động hóa các quy trình phức tạp. Nhờ vào các mô hình học sâu, AI nâng cao độ chính xác trong dự báo, tối ưu sản xuất, cải thiện dịch vụ khách hàng và giảm chi phí vận hành, mang lại lợi thế cạnh tranh bền vững cho doanh nghiệp trong kỷ nguyên công nghệ.

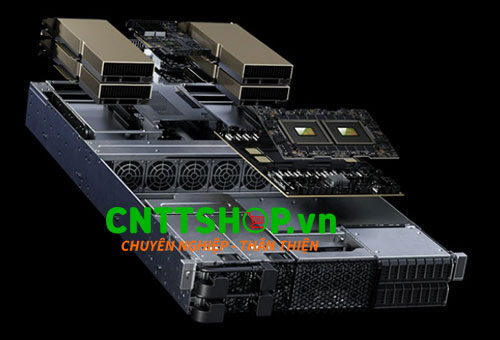

Trước xu hướng này, nhiều tập đoàn công nghệ đang đẩy mạnh đầu tư vào hạ tầng AI, trong đó GPU NVIDIA đóng vai trò then chốt. Việc xây dựng các trung tâm dữ liệu quy mô lớn không chỉ nhằm triển khai những mô hình AI tiên tiến mà còn giúp tối ưu hiệu suất, mở rộng khả năng xử lý và duy trì lợi thế cạnh tranh trong kỷ nguyên trí tuệ nhân tạo.

Bài viết này CNTTShop sẽ giới thiệu 5 GPU NVIDIA mạnh nhất cho AI & Deep Learning năm 2025, giúp bạn chọn GPU phù hợp nhất theo nhu cầu nghiên cứu, triển khai AI hoặc vận hành hệ thống thông minh.

1. Tại sao GPU NVIDIA là lựa chọn số 1 cho AI & Deep Learning?

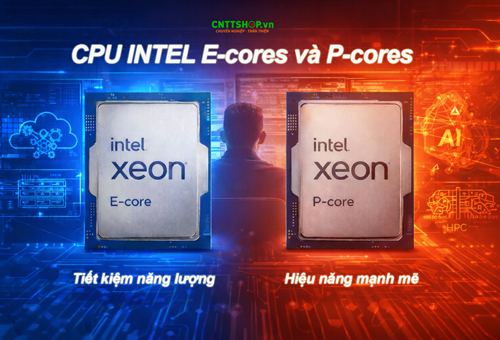

Nền tảng CUDA: CUDA (Compute Unified Device Architecture) là nền tảng lập trình giúp GPU xử lý AI, Deep Learning và mô phỏng dữ liệu nhanh hơn CPU truyền thống. CUDA tận dụng hàng nghìn lõi xử lý song song, giúp tăng tốc tính toán và tối ưu hiệu suất AI.

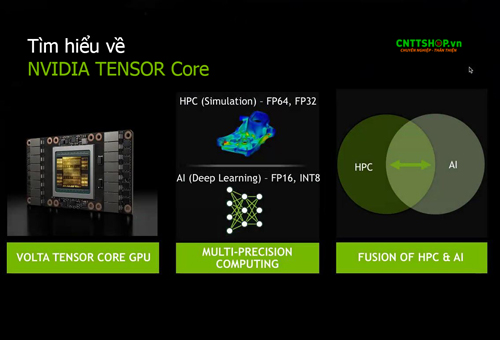

Phần cứng Tensor Core: Là lõi phần cứng chuyên biệt trên GPU NVIDIA, được thiết kế để tăng tốc các phép toán tensor – nền tảng của Deep Learning. Khả năng xử lý nhiều phép nhân ma trận đồng thời giúp tăng tốc huấn luyện mô hình AI, suy luận AI và xử lý dữ liệu lớn hiệu quả hơn.

VRAM băng thông cao: GPU như H200, H100, A100 sử dụng VRAM băng thông cao HBM (High Bandwidth Memory), trong đó HBM3e trên H200 là thế hệ mới nhất, cung cấp băng thông lên đến 4.8TB/s, giúp truyền tải dữ liệu nhanh hơn, tối ưu hiệu suất huấn luyện và suy luận AI.

Hệ sinh thái AI toàn diện: NVIDIA AI Enterprise hỗ trợ AI doanh nghiệp, Omniverse phục vụ mô phỏng AI trong đồ họa 3D, robotics, và DGX Systems là máy chủ AI mạnh mẽ, sử dụng GPU như H100, H200.

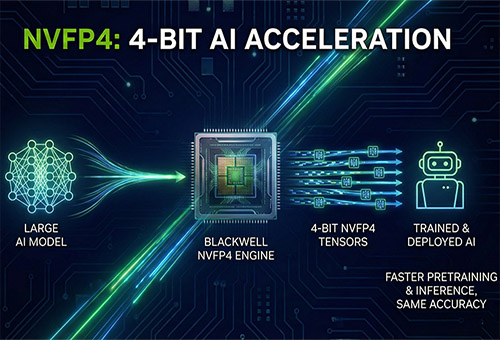

Chuẩn tính toán tối ưu (FP8, FP16, FP32, FP64): FP8 trên H100, H200 tăng tốc suy luận AI, FP16 & FP32 tối ưu huấn luyện Deep Learning, còn FP64 dành cho HPC và mô phỏng khoa học, giúp tăng độ chính xác tính toán.

2. Top 5 GPU NVIDIA mạnh cho AI & Deep Learning

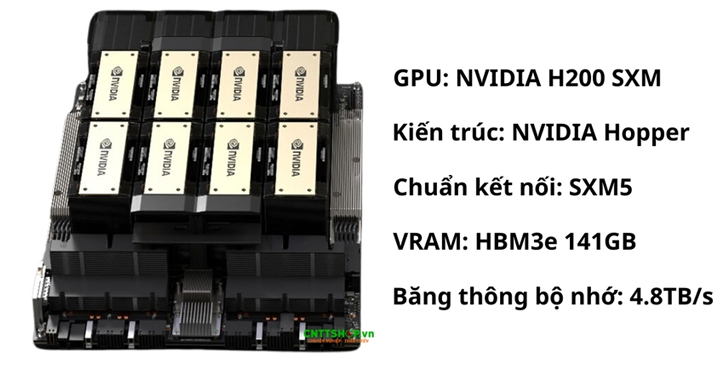

Top1. GPU NVIDIA H200 – GPU AI mạnh nhất hiện nay

Lý do chọn: NVIDIA H200 là GPU AI mạnh nhất, được thiết kế tối ưu cho LLM (Large Language Models), Generative AI và HPC. So với H100, H200 sở hữu VRAM HBM3e lớn hơn và băng thông cao hơn 43%, giúp tăng tốc huấn luyện mô hình AI khổng lồ và cải thiện hiệu suất suy luận. Mặc dù điện năng tiêu thụ tương đương với H100, GPU NVIDIA H200 mang lại hiệu năng cao hơn, giúp tối ưu hóa chi phí vận hành, giảm thiểu yêu cầu hạ tầng và nâng cao hiệu quả cho các dự án AI quy mô lớn. Đây là xu hướng mới cho trung tâm dữ liệu AI, nghiên cứu AI và các mô hình AI tiên tiến.

Điểm nổi bật:

- GPU: NVIDIA H200 SXM

- Kiến trúc: NVIDIA Hopper

- Chuẩn kết nối: SXM5

- VRAM: HBM3e 141GB

- Băng thông bộ nhớ: 4.8TB/s

- Hiệu năng tính toán (FP64 / FP32 / FP16 / FP8): 34 / 67 / 1,979 / 3,958 TFLOPS

- Điện năng tiêu thụ: ~700W

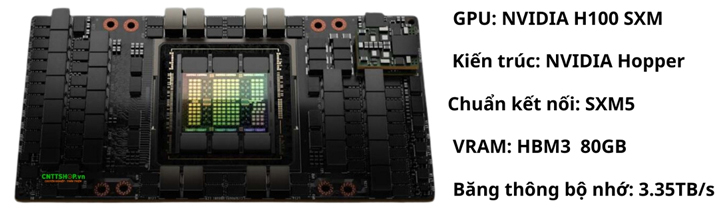

Top2. GPU NVIDIA H100 – Tiêu chuẩn cho trung tâm dữ liệu AI

Lý do chọn: H100 là GPU tiêu chuẩn vàng hiện nay trong trung tâm dữ liệu AI, được sử dụng rộng rãi cho LLM, Generative AI và Deep Learning. Với hiệu suất cao và khả năng xử lý dữ liệu lớn, GPU NVIDIA H100 giúp tăng tốc huấn luyện, tối ưu suy luận AI và đảm bảo vận hành ổn định. Đây là lựa chọn lý tưởng cho các hệ thống AI yêu cầu mở rộng linh hoạt, độ tin cậy cao và hiệu suất tối ưu.

Điểm nổi bật:

- GPU: NVIDIA H100 SXM

- Kiến trúc: NVIDIA Hopper

- Chuẩn kết nối: SXM5

- VRAM: HBM3 80GB

- Băng thông bộ nhớ: 3.35TB/s

- Hiệu năng tính toán (FP64 / FP32 / FP16 / FP8): 34 / 67 / 1,979 / 3,958 TFLOPS

- Điện năng tiêu thụ: ~700W

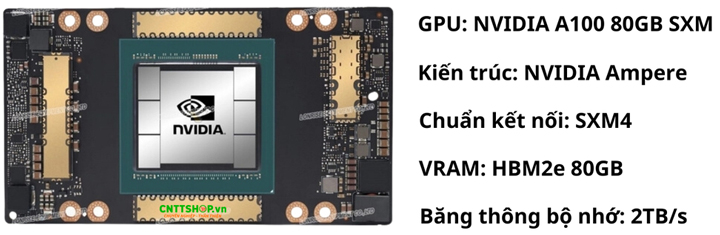

Top3. GPU NVIDIA A100 – GPU AI cân bằng hiệu suất và chi phí

Lý do chọn: Với lợi thế cân bằng giữa hiệu suất, chi phí đầu tư và vận hành, GPU NVIDIA A100 trở thành GPU AI phổ biến nhất trong doanh nghiệp. Nhờ khả năng tối ưu Deep Learning, phân tích dữ liệu và vận hành AI ổn định, A100 được nhiều tổ chức tin dùng cho hệ thống AI thương mại và trung tâm dữ liệu quy mô vừa và nhỏ. Đây là lựa chọn lý tưởng cho doanh nghiệp muốn triển khai AI hiệu quả mà không cần đầu tư hạ tầng quá lớn.

Điểm nổi bật:

- GPU: NVIDIA A100 80GB SXM

- Kiến trúc: NVIDIA Ampere

- Chuẩn kết nối: SXM4

- VRAM: HBM2e 80GB

- Băng thông bộ nhớ: 2TB/s

- Hiệu năng tính toán (FP64 / FP32 / FP16 / FP8): 9.7 / 19.5 / 624 / - TFLOPS

- Điện năng tiêu thụ: ~400W

Top4. GPU NVIDIA L40S – GPU AI kết hợp xử lý đồ họa

Lý do chọn: Với lợi thế kết hợp giữa sức mạnh AI và xử lý đồ họa, L40S là GPU AI thế hệ mới, đặc biệt phù hợp cho Inference AI, workstation AI và mô phỏng 3D. Nhờ khả năng xử lý AI thời gian thực, tối ưu đồ họa chuyên sâu và hỗ trợ sáng tạo nội dung, GPU NVIDIA L40S không chỉ đáp ứng nhu cầu các ngành công nghiệp sáng tạo, kiến trúc, sản xuất, mà còn tăng cường hiệu suất vận hành doanh nghiệp, giúp xử lý nhanh các tác vụ AI thương mại và mô phỏng kỹ thuật số. Đây là giải pháp mạnh mẽ cho những hệ thống cần hiệu suất AI cao đồng thời đáp ứng yêu cầu đồ họa phức tạp.

Điểm nổi bật:

- GPU: NVIDIA L40S

- Kiến trúc: NVIDIA Ada Lovelace

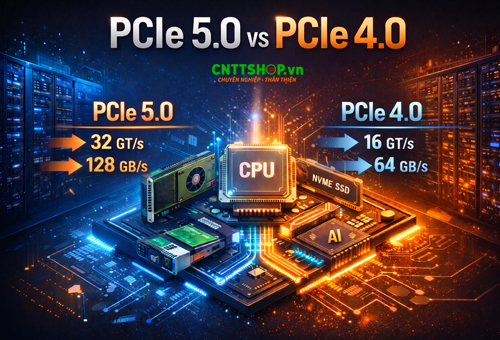

- Chuẩn kết nối: PCIe 4.0 x16

- VRAM: GDDR6 48GB

- Băng thông bộ nhớ: 864GB/s

- Hiệu năng tính toán (FP64 / FP32 / FP16 / FP8): - / 91.6 / 733 / 1,466 TFLOPS

- Điện năng tiêu thụ: ~300W

Top5. GPU NVIDIA RTX 5090 – GPU dành cho cá nhân làm AI cơ bản

Lý do chọn: RTX 5090 là GPU đa dụng với hiệu suất mạnh mẽ, dù không được tối ưu hoàn toàn cho AI & Deep Learning nhưng vẫn đáp ứng tốt ở mức cơ bản. Đây là lựa chọn phù hợp cho cá nhân và doanh nghiệp nhỏ muốn chạy AI mà không cần đầu tư vào hạ tầng đắt đỏ. Với khả năng xử lý đa nhiệm và hiệu suất cao, RTX 5090 hỗ trợ nhà nghiên cứu AI, nhà sáng tạo tiếp cận công nghệ tiên tiến. Tuy nhiên, GPU này không thể thay thế các dòng chuyên dụng cho trung tâm dữ liệu. Đây là lựa chọn lý tưởng cho nhà phát triển AI độc lập và phòng nghiên cứu nhỏ.

Điểm nổi bật:

- GPU: NVIDIA RTX 5090

- Kiến trúc: NVIDIA Blackwell

- Chuẩn kết nối: PCIe 5.0 x16

- VRAM: GDDR7 32GB

- Băng thông bộ nhớ: 1.792TB/s

- Hiệu năng tính toán (FP64 / FP32 / FP16 / FP8): 1.64 / 104.9 / 209.8 / - TFLOPS

- Điện năng tiêu thụ: ~450W

3. Bảng so sánh 5 GPU NVIDIA mạnh nhất cho AI & Deep Learning

|

GPU |

VRAM & Băng thông bộ nhớ |

Hiệu năng tính toán (TFLOPS) (FP64 / FP32 / FP16 / FP8) |

|

NVIDIA H200 (SXM) |

141GB HBM3e, 4.8TB/s |

34 / 67 / 1,979 / 3,958 |

|

NVIDIA H100 (SXM) |

80GB HBM3, 3.35TB/s |

34 / 67 / 1,979 / 3,958 |

|

NVIDIA A100 (SXM) |

80GB HBM2e, 2TB/s |

9.7 / 19.5 / 624 / - |

|

NVIDIA L40S |

48GB GDDR6, 864GB/s |

- / 91.6 / 733 / 1,466 |

|

NVIDIA RTX 5090 |

32GB GDDR7, 1.792TB/s |

1.64 / 104.9 / 209.8 / - |

4. Kết luận:

Lựa chọn GPU phù hợp là yếu tố then chốt để tối ưu hiệu suất AI và Deep Learning, giúp doanh nghiệp kiểm soát chi phí và mở rộng quy mô trong tương lai.

- H200, H100, A100 là GPU NVIDIA mang lại sức mạnh tính toán vượt trội, lý tưởng cho trung tâm dữ liệu AI và mô hình AI quy mô lớn.

- GPU NVIDIA L40S kết hợp Inference AI và xử lý đồ họa, cung cấp giải pháp tối ưu cho doanh nghiệp sáng tạo.

- GPU NVIDIA RTX 5090 là lựa chọn linh hoạt, phù hợp với cá nhân và doanh nghiệp nhỏ muốn tiếp cận AI với chi phí thấp.

Tùy vào quy mô dự án và ngân sách, doanh nghiệp có thể chọn GPU phù hợp để tối đa hiệu suất, tối ưu chi phí và đảm bảo khả năng mở rộng lâu dài.

CNTTShop là đơn vị cung cấp đáng tin cậy các sản phẩm GPU NVIDIA, cam kết cung cấp sản phẩm chính hãng, chất lượng cao với giá cạnh tranh. Chúng tôi luôn sẵn sàng tư vấn chuyên sâu, giúp doanh nghiệp lựa chọn GPU phù hợp để tối ưu hiệu suất AI và Deep Learning.

Công Ty TNHH Công Nghệ Việt Thái Dương (CNTTShop)

Đ/C tại Hà Nội: NTT03, Line1, Thống Nhất Complex, 82 Nguyễn Tuân, Thanh Xuân, Hà Nội.

Đ/C tại HCM: Số 13, đường 7C, khu phố 4, phường An Phú, TP Thủ Đức, Hồ Chí Minh

Điện Thoại: 0906 051 599

Website: www.cnttshop.vn

.png)

Bình luận bài viết!