So sánh GPU NVIDIA A100 và H100 – Đâu là lựa chọn phù hợp nhất?

GPU NVIDIA A100 (kiến trúc Ampere) ra mắt năm 2020, trở thành lựa chọn tiêu chuẩn cho AI Training, mô phỏng khoa học và phân tích dữ liệu lớn. Tuy nhiên, với sự phát triển mạnh mẽ của các mô hình AI thế hệ mới, NVIDIA đã giới thiệu GPU H100 (kiến trúc Hopper) vào năm 2022, mang lại bước nhảy vọt về hiệu suất trong AI Training, Generative AI và mô hình ngôn ngữ lớn (LLM).

Vậy GPU NVIDIA H100 có thực sự đáng để nâng cấp từ NVIDIA A100? GPU nào phù hợp hơn với nhu cầu của doanh nghiệp? Bài viết này sẽ giúp bạn có cái nhìn rõ ràng và đưa ra quyết định tối ưu nhất.

1. So sánh chi tiết giữa NVIDIA A100 và H100

Dưới đây là sự khác biệt quan trọng giữa GPU NVIDIA A100 và NVIDIA H100, phân tích từng tiêu chí quan trọng để giúp bạn hiểu rõ sự nâng cấp của H100 so với A100.

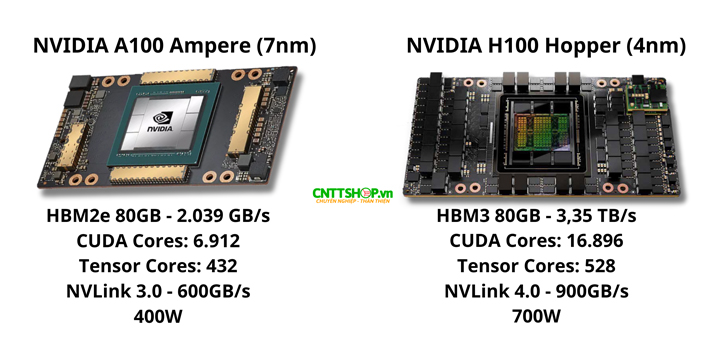

1.1. Kiến trúc & Nhân CUDA, Tensor Core

NVIDIA H100 sử dụng kiến trúc Hopper, đây là thế hệ tiếp theo của Ampere trên A100. Một trong những điểm nâng cấp lớn nhất của H100 là số lượng nhân CUDA và Tensor Core.

-

NVIDIA A100 dựa trên tiến trình 7nm của TSMC, với 6.912 nhân CUDA và 432 Tensor Cores. Đây là GPU tiên phong cho AI Training và HPC trong suốt những năm qua.

-

NVIDIA H100 sử dụng tiến trình 4nm, giúp tăng mật độ bóng bán dẫn và tối ưu điện năng. GPU này có 16.896 nhân CUDA, gấp 2,5 lần so với A100. Ngoài ra, H100 cũng được trang bị 528 Tensor Cores, nâng cấp quan trọng cho các tác vụ AI.

GPU Nvidia Với 16.896 nhân CUDA, gấp 2,44 lần so với A100 (6.912 nhân), H100 có khả năng xử lý song song vượt trội, giúp tăng tốc đáng kể cho Deep Learning và HPC.

1.2. Hiệu suất tính toán & AI Training

-

NVIDIA A100 có hiệu suất FP64 đạt 9,7 TFLOPS và FP32 đạt 19,5 TFLOPS, đáp ứng tốt các ứng dụng HPC và mô phỏng khoa học. Trong AI Training, A100 hỗ trợ Tensor FP16/BF16 với 312 TFLOPS.

-

NVIDIA H100 nâng cấp mạnh mẽ với FP64 đạt 34 TFLOPS (gấp 3,5 lần A100) và FP32 đạt 67 TFLOPS (gấp 3,4 lần), giúp xử lý nhanh hơn đáng kể. H100 được trang bị Tensor Core thế hệ 4, tăng hiệu suất Tensor FP16/BF16 lên 1.979 TFLOPS (gấp 6,3 lần) và bổ sung Tensor FP8 đạt 3.958 TFLOPS, tối ưu cho AI Training và LLM.

Nếu bạn huấn luyện mô hình AI lớn, H100 giảm đáng kể thời gian training so với A100, từ đó giúp tiết kiệm chi phí vận hành.

1.3. Bộ nhớ HBM & Tốc độ truyền tải dữ liệu

-

A100 sử dụng HBM2e với băng thông 2.039 GB/s. Đây là mức băng thông cao, nhưng vẫn có thể trở thành điểm nghẽn khi huấn luyện mô hình AI cực lớn.

-

H100 nâng cấp lên HBM3 với băng thông 3,35 TB/s, tức là tăng 67% so với A100, giúp các mô hình AI sử dụng bộ nhớ hiệu quả hơn.

Với các ứng dụng tài chính, dự báo thời tiết, nghiên cứu khoa học, HBM3 trên H100 giúp cải thiện tốc độ xử lý đáng kể.

1.4. Kết nối NVLink & Khả năng mở rộng Multi-GPU

Đối với hệ thống AI lớn như DGX SuperPOD hoặc các trung tâm dữ liệu, kết nối giữa các GPU là yếu tố quan trọng.

-

A100 sử dụng NVLink 3.0 với băng thông 600GB/s.

-

H100 nâng cấp lên NVLink 4.0, với băng thông 900GB/s, nhanh hơn 50% so với A100.

H100 tối ưu cho hệ thống multi-GPU, giúp tăng tốc độ truyền dữ liệu giữa các GPU trong AI Training lớn.

1.5. Điện năng tiêu thụ

Bên cạnh hiệu suất vượt trội, H100 tiêu thụ nhiều điện hơn so với A100, điều này cần cân nhắc khi triển khai.

-

A100 có mức TDP là 400W, dễ triển khai hơn cho doanh nghiệp vừa và nhỏ.

-

H100 tiêu thụ tới 700W, tức là cao hơn 75% so với A100, đòi hỏi hệ thống cấp nguồn mạnh hơn.

Nếu doanh nghiệp không có hạ tầng phù hợp để cung cấp đủ điện năng, thì A100 vẫn là lựa chọn hợp lý.

1.6. Chi phí đầu tư & Hiệu suất sử dụng

Giá của H100 cao hơn đáng kể, nhưng đi kèm với hiệu suất vượt trội.

-

A100 có mức giá rẻ hơn, phù hợp với doanh nghiệp vừa và nhỏ, hoặc các hệ thống AI không yêu cầu hiệu suất tối đa.

-

H100 đắt hơn A100 từ 2-3 lần, nhưng lại mang lại hiệu suất AI Training nhanh hơn gấp 3-6 lần, giúp giảm chi phí vận hành lâu dài.

Nếu cần đầu tư GPU để chạy AI Training lớn (LLM, Generative AI, HPC cao cấp), H100 là lựa chọn hàng đầu. Nhưng nếu bạn chỉ cần một GPU mạnh nhưng giá hợp lý, A100 vẫn rất đáng giá.

2. Bảng so sánh thông số kỹ thuật

|

Thông số |

NVIDIA A100 80GB SXM4 |

NVIDIA H100 80GB SXM5 (Tăng bao nhiêu %) |

|

Kiến trúc |

Ampere (7nm) |

Hopper (4nm) - Tiến trình nhỏ hơn, tối ưu hơn |

|

CUDA Cores |

6.912 |

16.896 (+144%) |

|

Tensor Cores |

432 |

528 (+22%) |

|

Bộ nhớ GPU |

HBM2e 80GB - 2.039 GB/s |

HBM3 80GB - 3,35 TB/s (+67%) |

|

Hiệu năng FP64 |

9,7 TFLOPS |

34 TFLOPS (+250%) |

|

Hiệu năng FP32 |

19,5 TFLOPS |

67 TFLOPS (+244%) |

|

Tensor FP16/BF16 |

312 TFLOPS |

1.979 TFLOPS (+534%) |

|

Tensor FP8 |

Không hỗ trợ |

3.958 TFLOPS (Tăng tốc AI Training 3-6 lần) |

|

NVLink |

NVLink 3.0 - 600GB/s |

NVLink 4.0 - 900GB/s (+50% tốc độ Multi-GPU) |

|

Công suất |

400W |

700W (Cao hơn 75%) |

3. Nên chọn NVIDIA A100 hay H100?

Việc lựa chọn giữa NVIDIA A100 và H100 phụ thuộc vào nhu cầu sử dụng, hiệu suất mong muốn và khả năng đầu tư hạ tầng.

-

Nếu bạn cần một GPU ổn định cho HPC hoặc AI Training tiêu chuẩn, A100 vẫn là một lựa chọn tốt với hiệu suất đáng tin cậy. Tuy nhiên, H100 nhanh hơn gấp 3 lần trong huấn luyện AI, đặc biệt là với mô hình ngôn ngữ lớn (LLM) và Generative AI, nơi H100 tỏ ra vượt trội hoàn toàn.

-

Đối với các ứng dụng HPC, H100 mạnh hơn 2,5 lần so với A100, giúp đẩy nhanh quá trình mô phỏng khoa học, tài chính và nghiên cứu y sinh. Trong Inference AI, H100 có lợi thế lớn nhờ hỗ trợ FP8, giúp tăng tốc suy luận đáng kể so với A100.

-

Về ngân sách, A100 có mức giá thấp hơn, phù hợp với doanh nghiệp cần hiệu suất cao nhưng chưa sẵn sàng đầu tư vào GPU thế hệ mới. Trong khi đó, H100 có chi phí cao hơn, nhưng mang lại hiệu suất vượt trội, giúp tối ưu thời gian huấn luyện và giảm chi phí vận hành lâu dài.

-

Ngoài ra, H100 yêu cầu hệ thống điện mạnh hơn (700W so với 400W của A100), đòi hỏi doanh nghiệp phải có hạ tầng phù hợp để khai thác tối đa sức mạnh của GPU này.

Nếu bạn cần GPU mạnh nhất cho AI Training, LLM hoặc HPC cao cấp, H100 là lựa chọn hàng đầu. Ngược lại, nếu ngân sách hạn chế nhưng vẫn cần hiệu suất cao, A100 là phương án đáng cân nhắc.

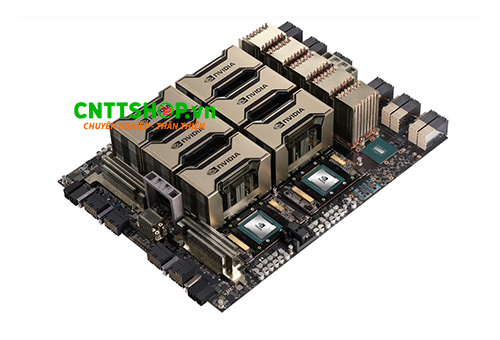

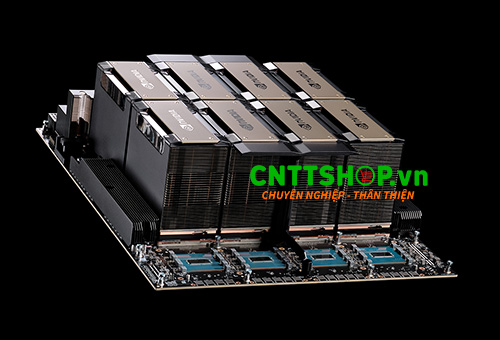

4. CNTTShop cung cấp GPU NVIDIA chính hãng, phù hợp cho AI & HPC

NVIDIA A100 là lựa chọn phù hợp cho AI Training tiêu chuẩn và HPC, đáp ứng tốt nhu cầu tính toán với mức giá hợp lý. Trong khi đó, NVIDIA H100 mang lại bước nhảy vọt về hiệu suất, đặc biệt tối ưu cho LLM, Generative AI và AI Training quy mô lớn, giúp rút ngắn thời gian huấn luyện và tăng tốc tính toán đáng kể. Nếu bạn cần GPU mạnh nhất cho AI thế hệ mới, H100 là lựa chọn hàng đầu, còn nếu muốn cân đối giữa hiệu suất và chi phí, A100 vẫn là phương án đáng cân nhắc.

CNTTShop là đơn vị phân phối chính hãng GPU NVIDIA A100 và H100, cung cấp giải pháp tối ưu cho AI Training, HPC và Generative AI. Chúng tôi cam kết giá tốt nhất, hàng chính hãng, bảo hành đầy đủ, cùng hỗ trợ kỹ thuật chuyên sâu giúp doanh nghiệp triển khai hệ thống AI hiệu quả.

Địa chỉ phân phối GPU NVIDIA chính hãng tại Hà Nội

Công Ty TNHH Công Nghệ Việt Thái Dương - CNTTShop

Địa chỉ: NTT03, Thống Nhất Complex, 82 Nguyễn Tuân, Thanh Xuân, Hà Nội.

Điện Thoại: 0906 051 599

Email: kd@cnttshop.vn

website: cnttshop.vn

Địa chỉ phân phối GPU NVIDIA chính hãng tại TP. Hồ Chí Minh

Công Ty TNHH Công Nghệ Việt Thái Dương - CNTTShop

Địa chỉ: Số 13, đường 7C, khu phố 4, phường An Phú, TP Thủ Đức, Hồ Chí Minh.

Điện Thoại: 0906 051 599

Email: kd@cnttshop.vn

website: cnttshop.vn

.png)

Bình luận bài viết!